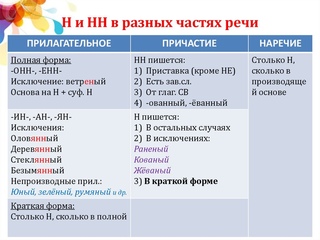

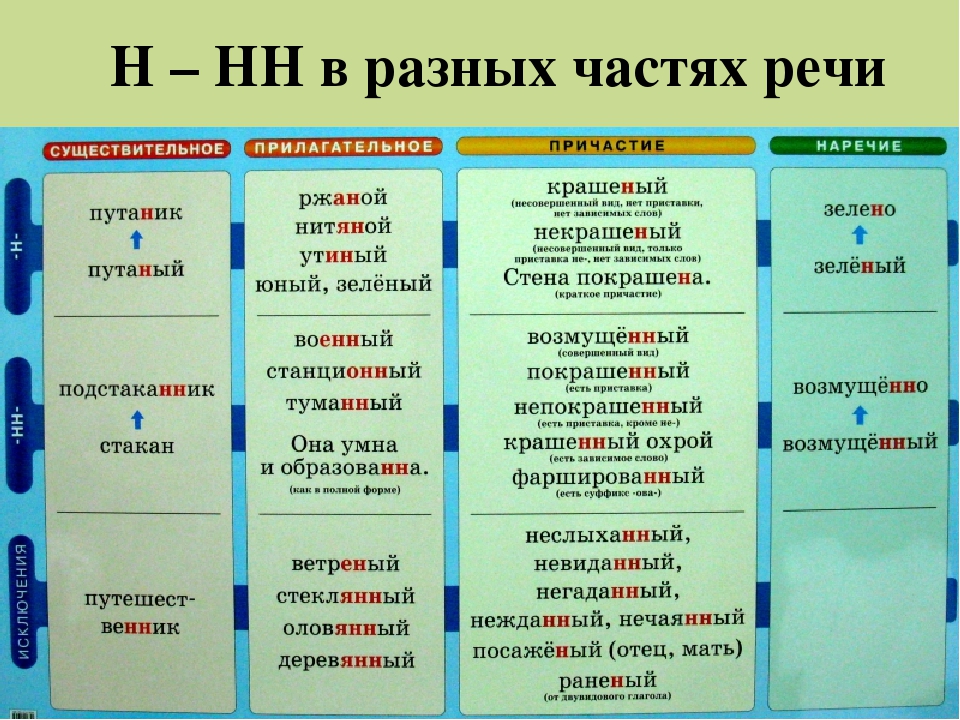

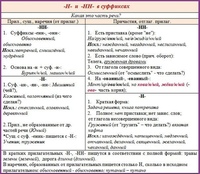

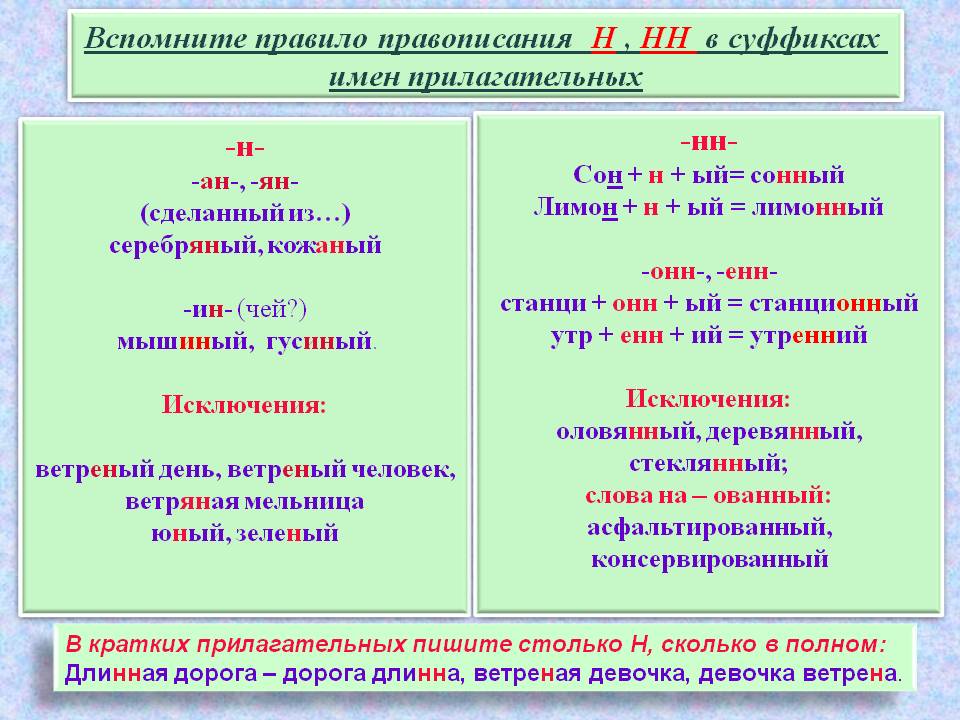

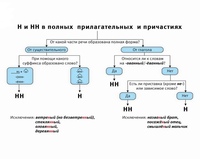

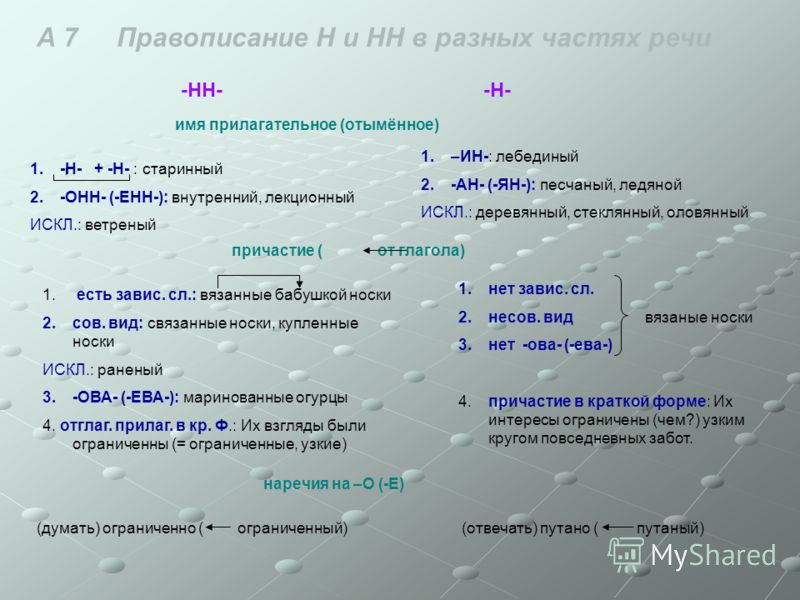

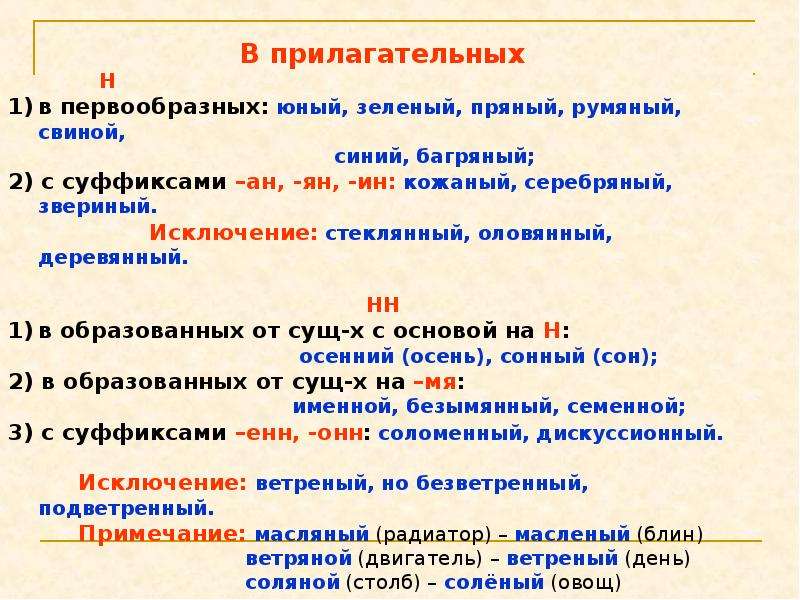

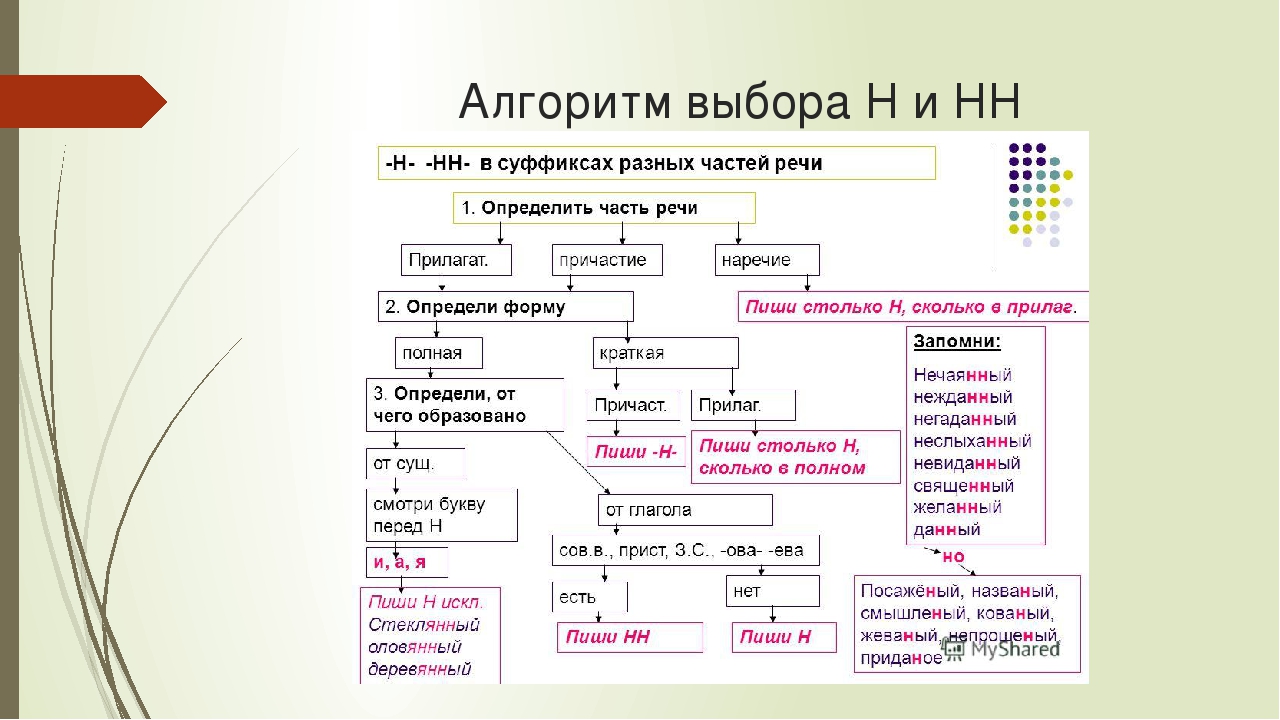

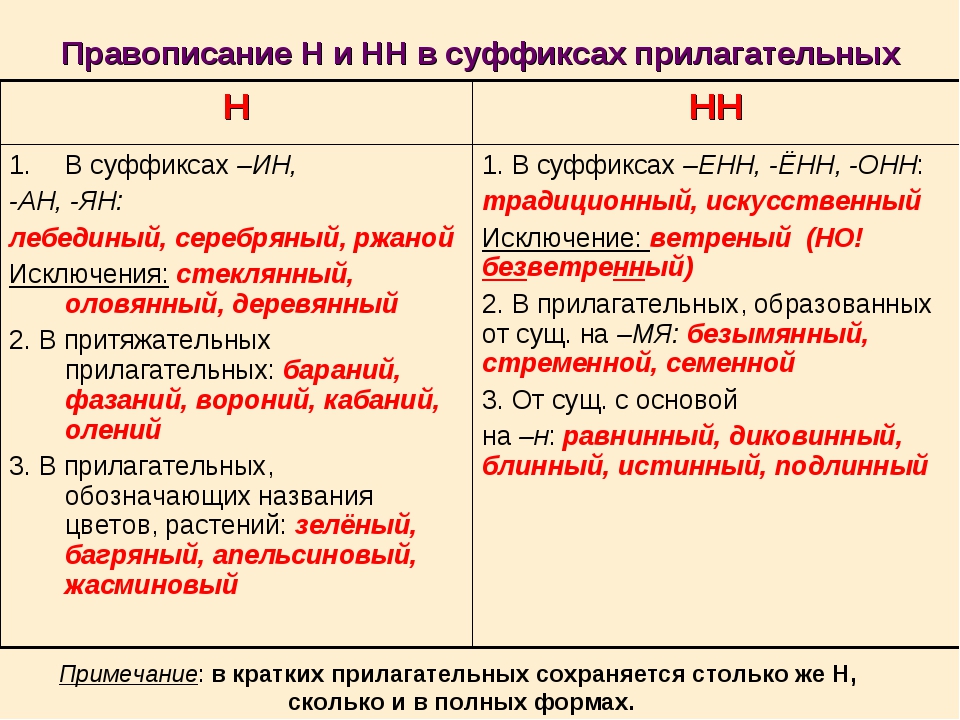

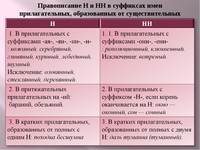

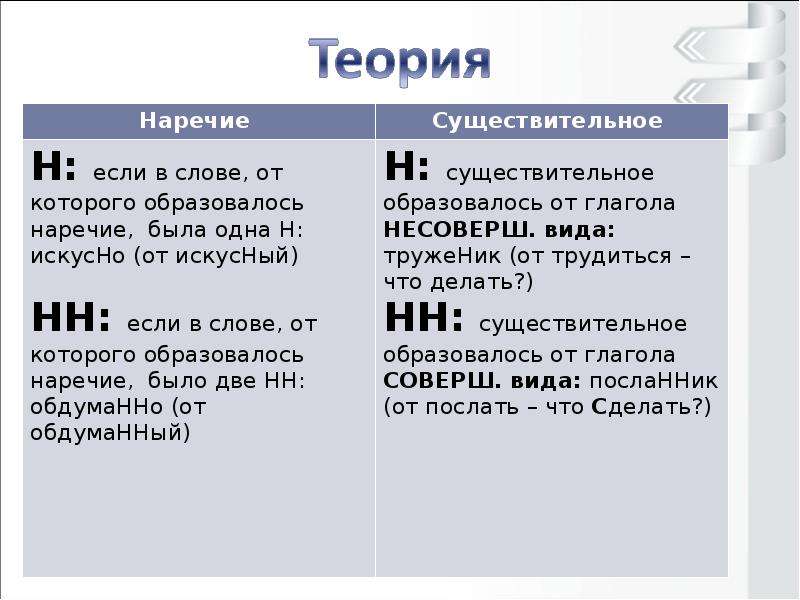

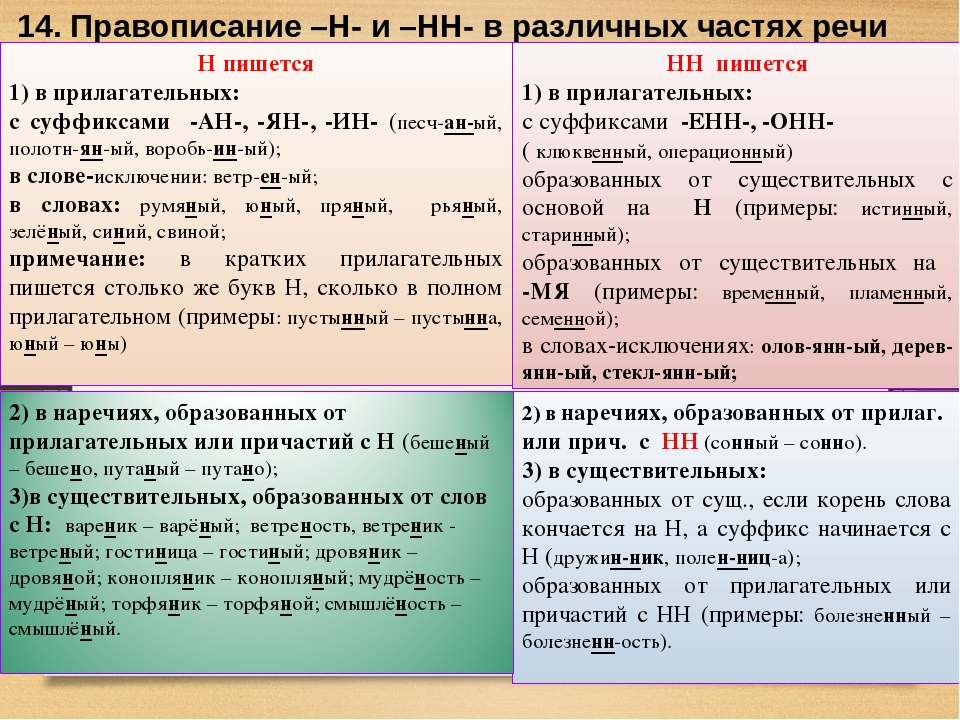

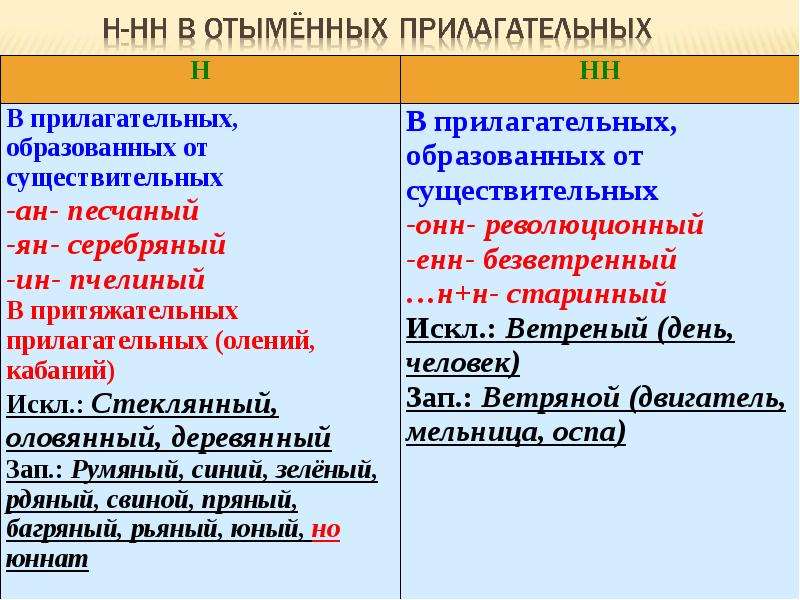

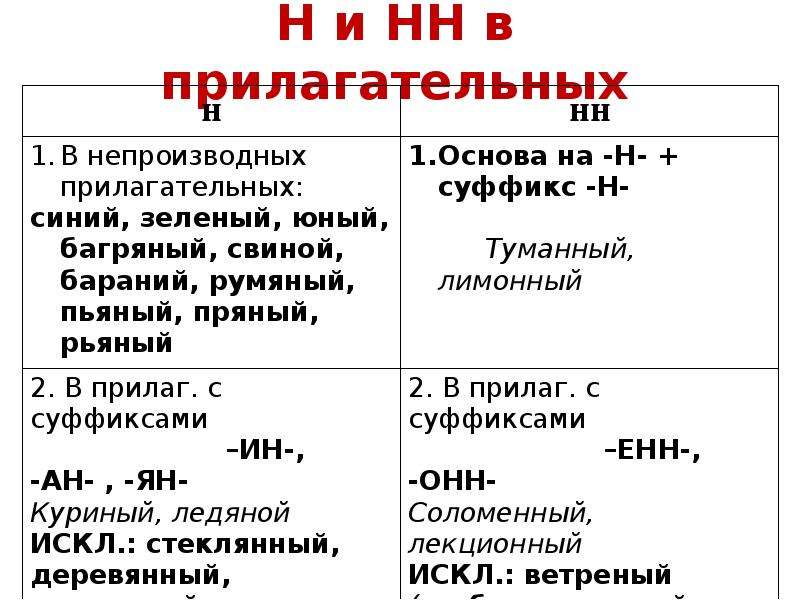

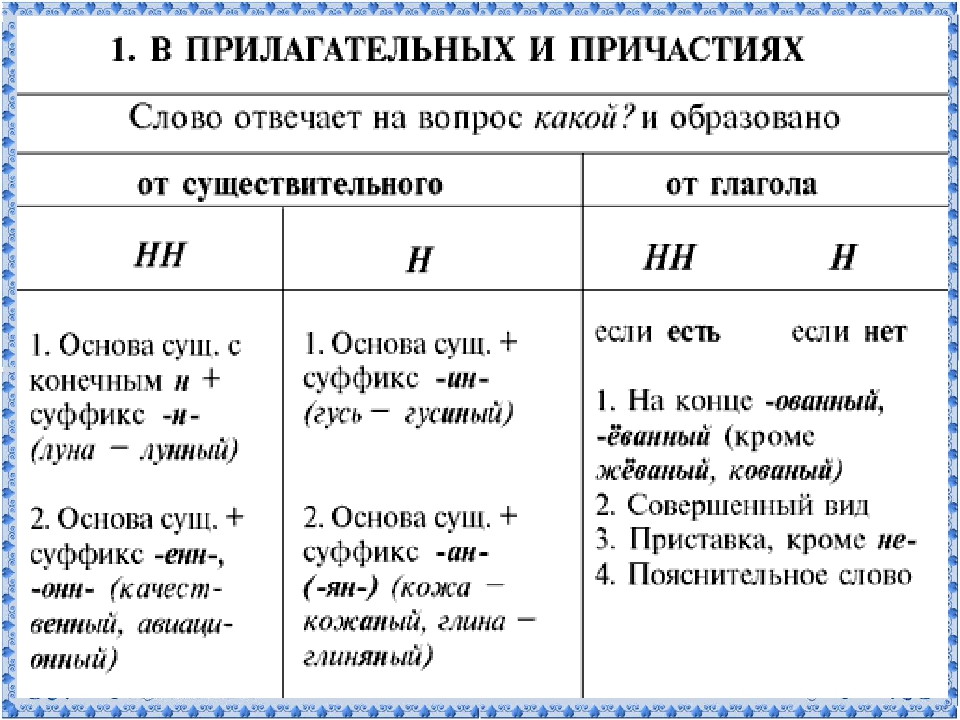

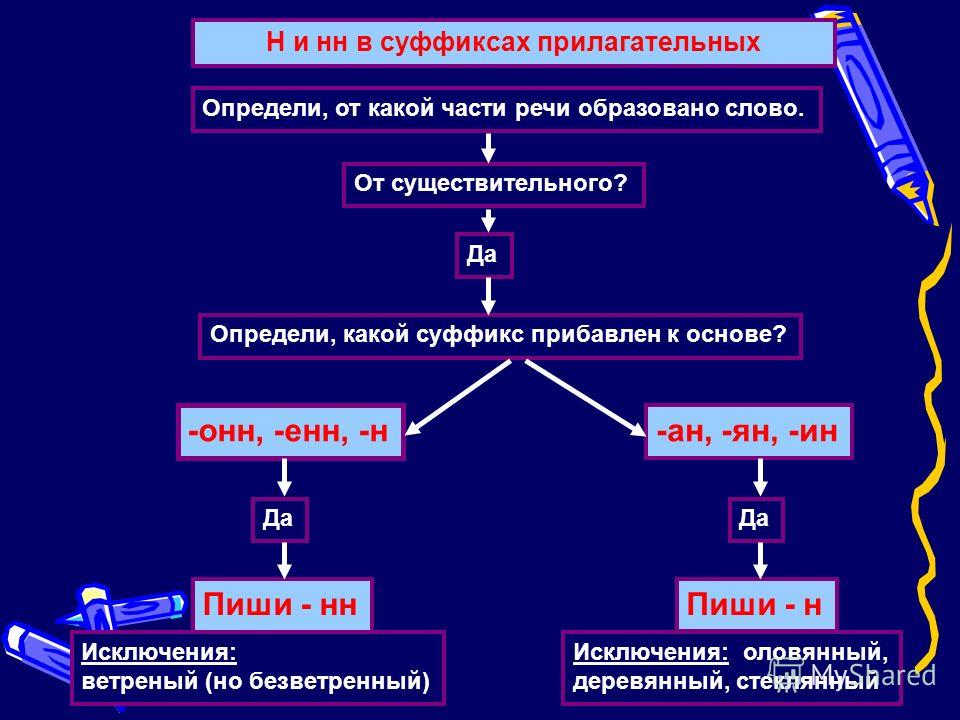

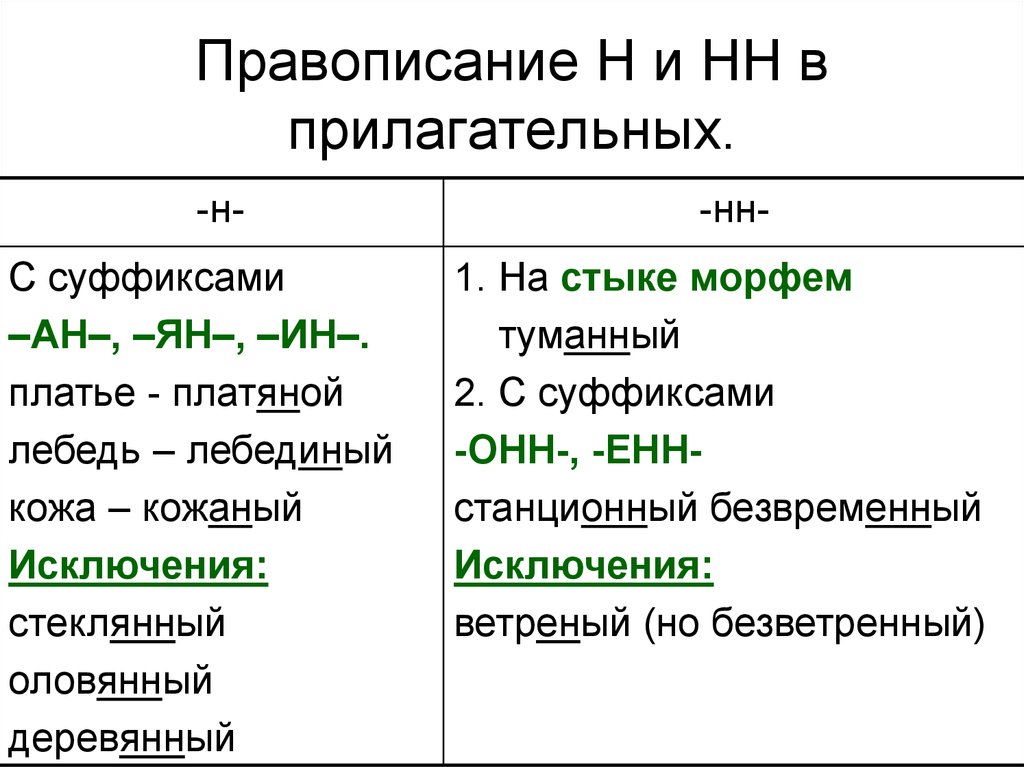

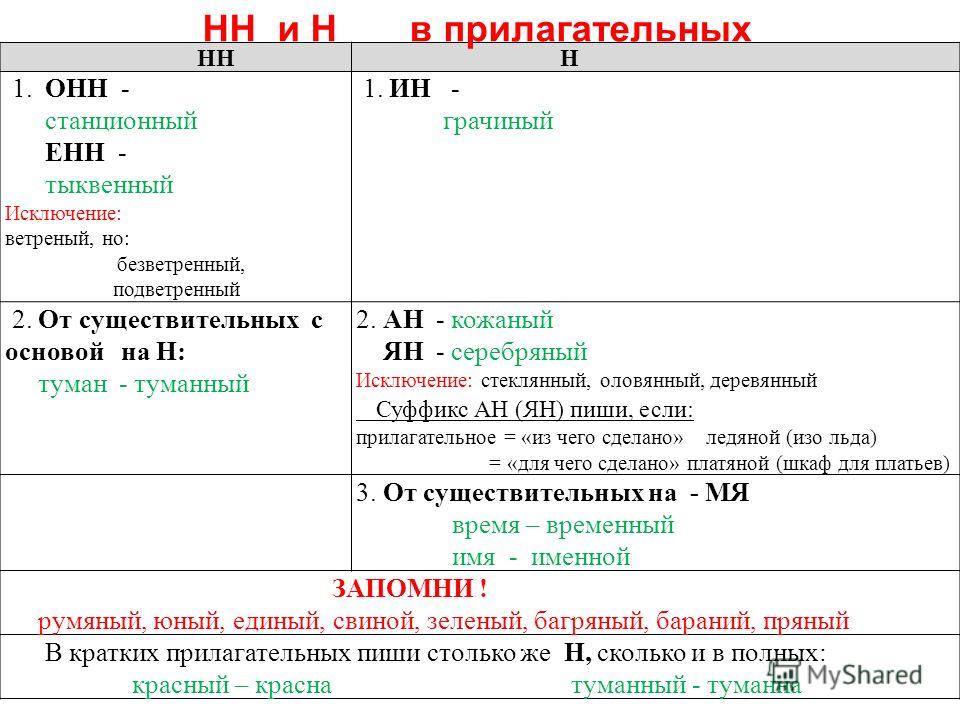

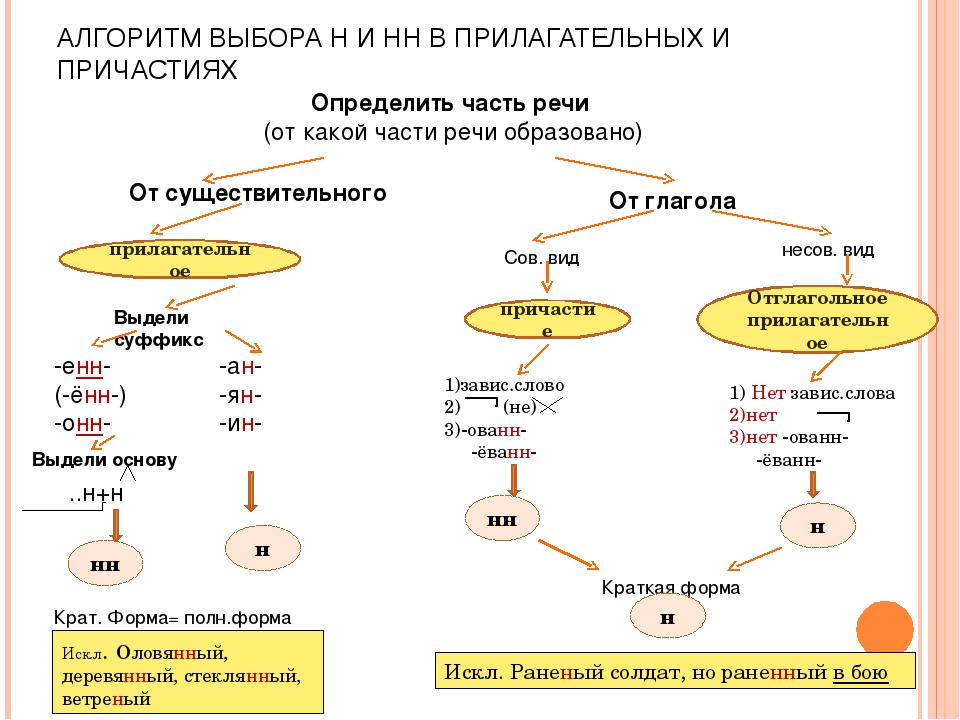

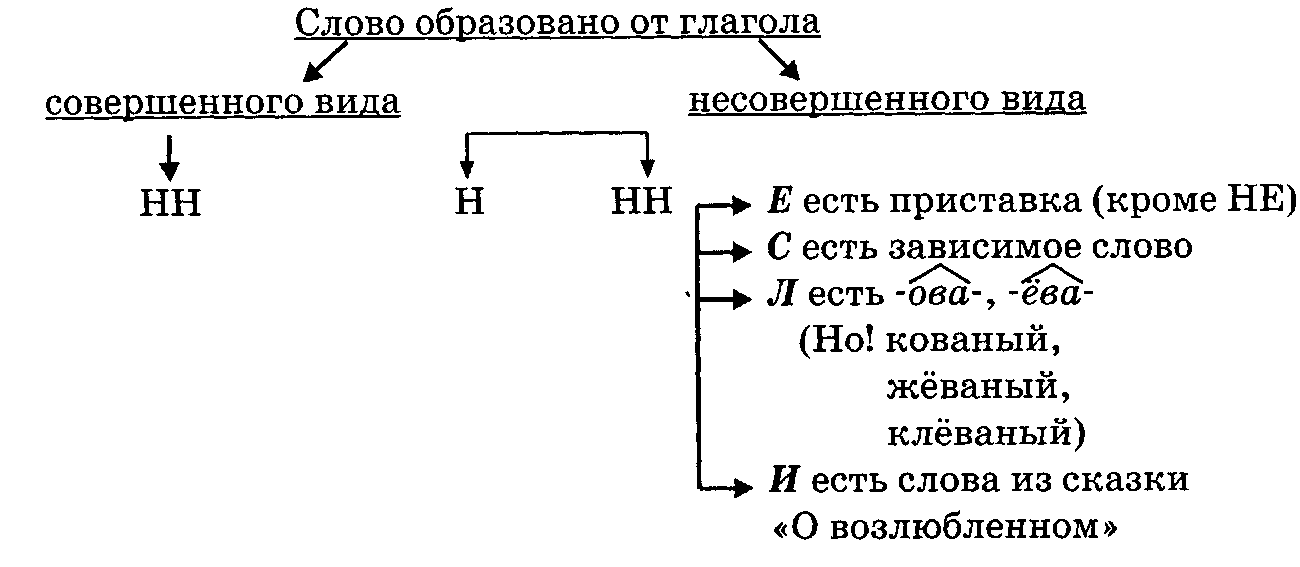

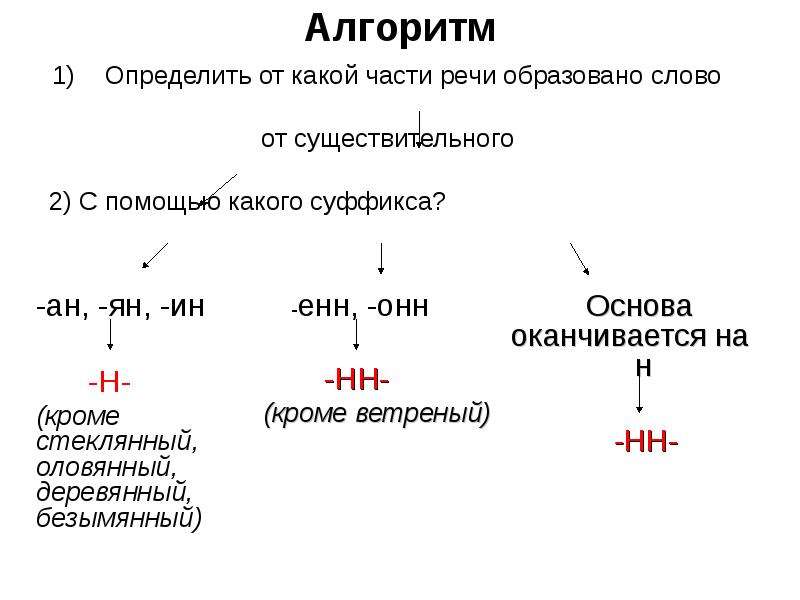

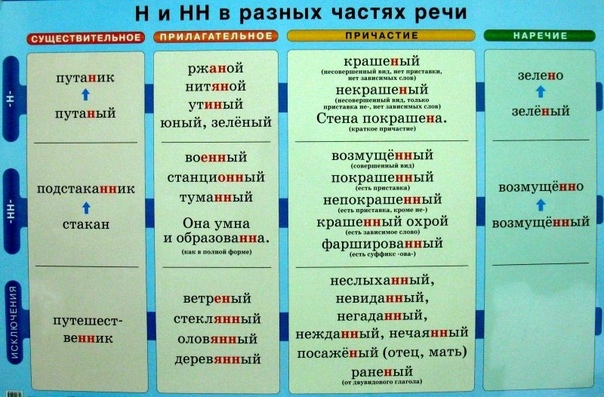

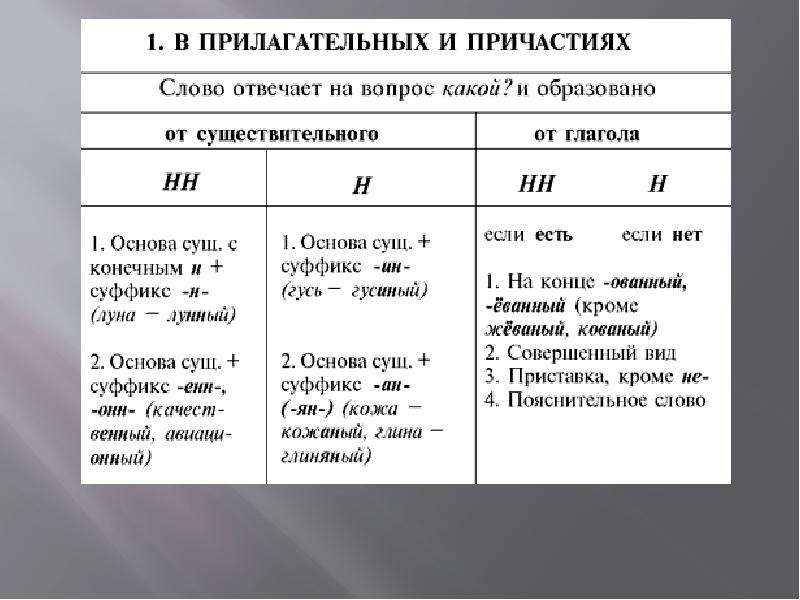

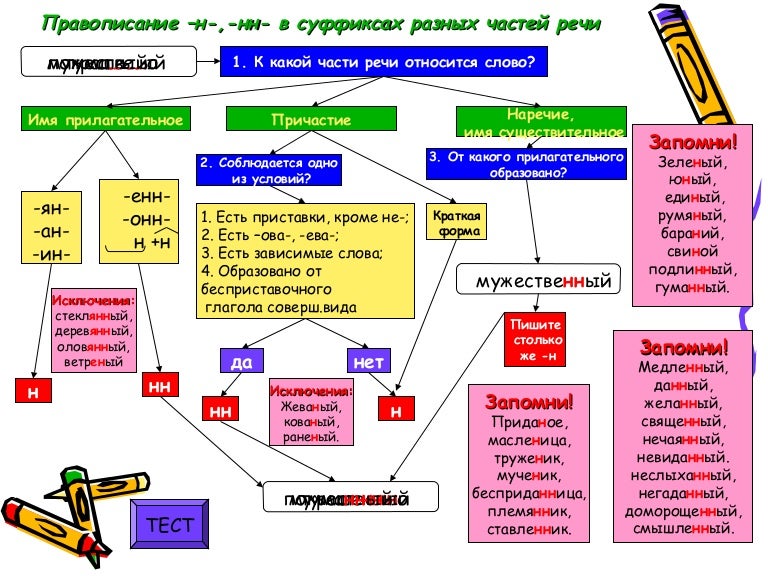

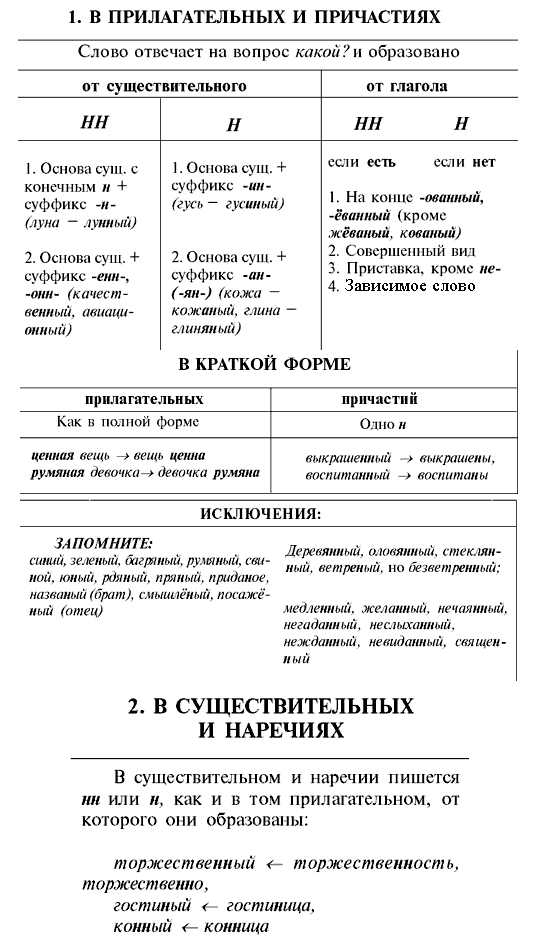

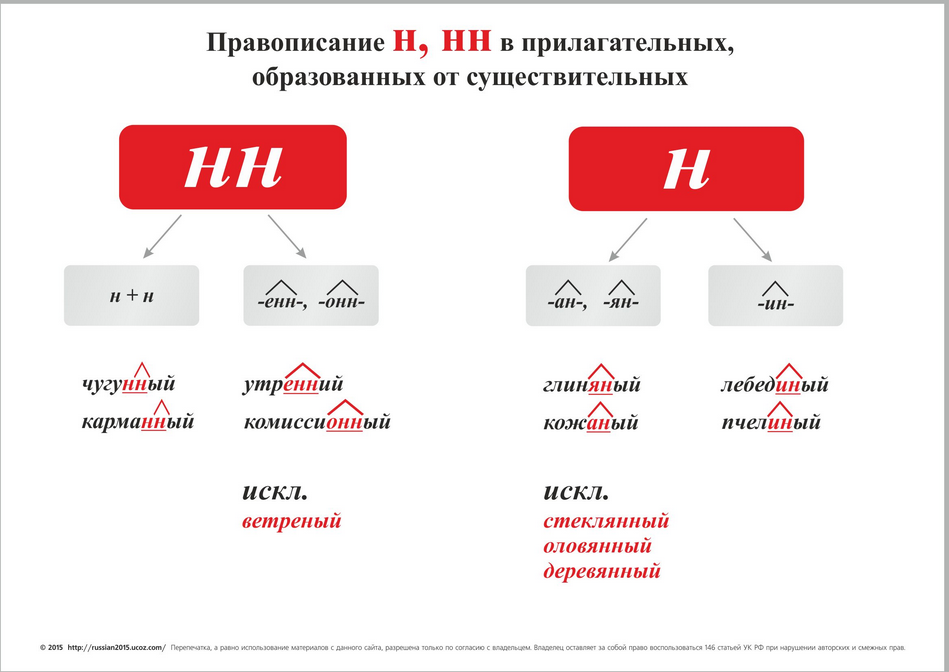

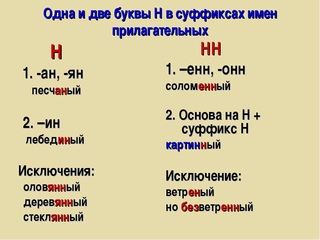

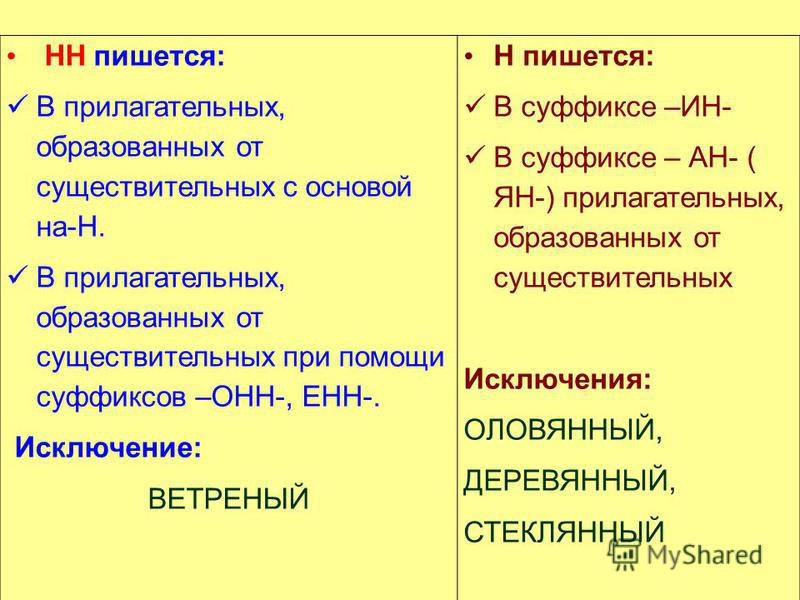

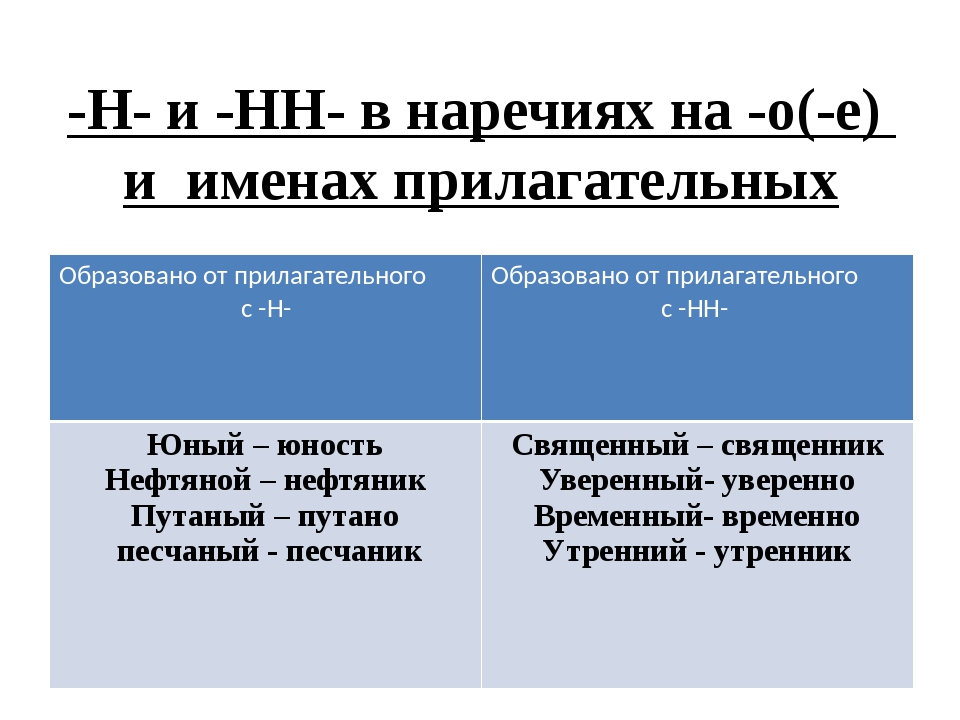

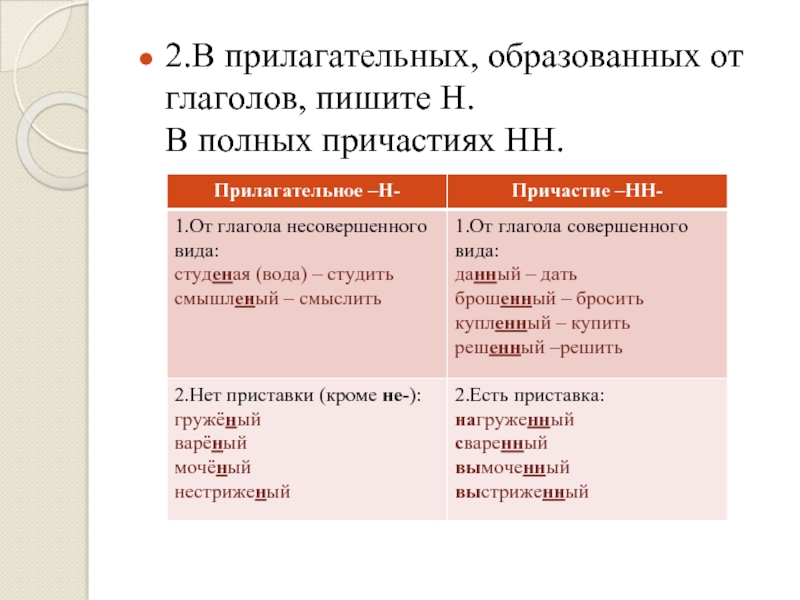

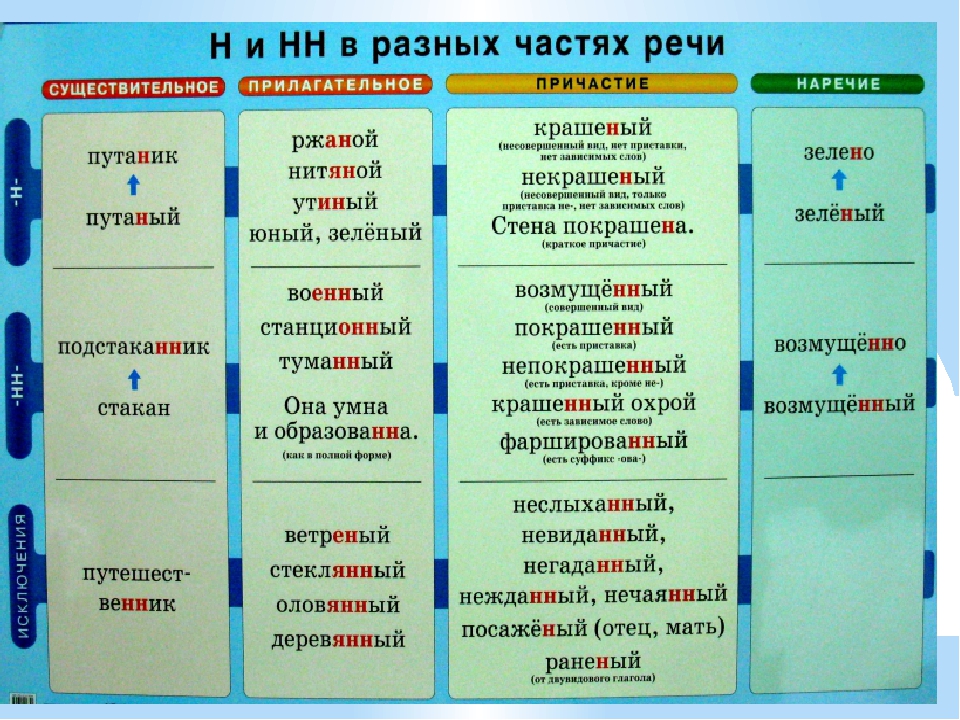

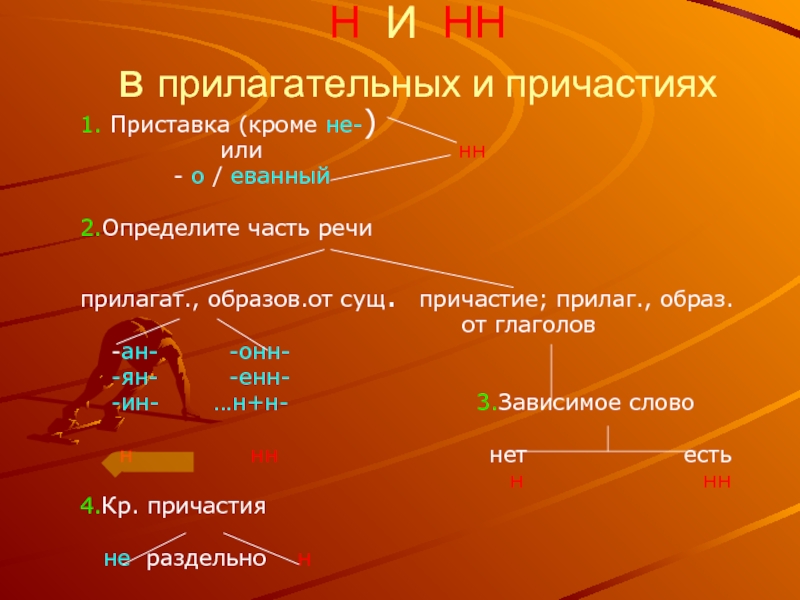

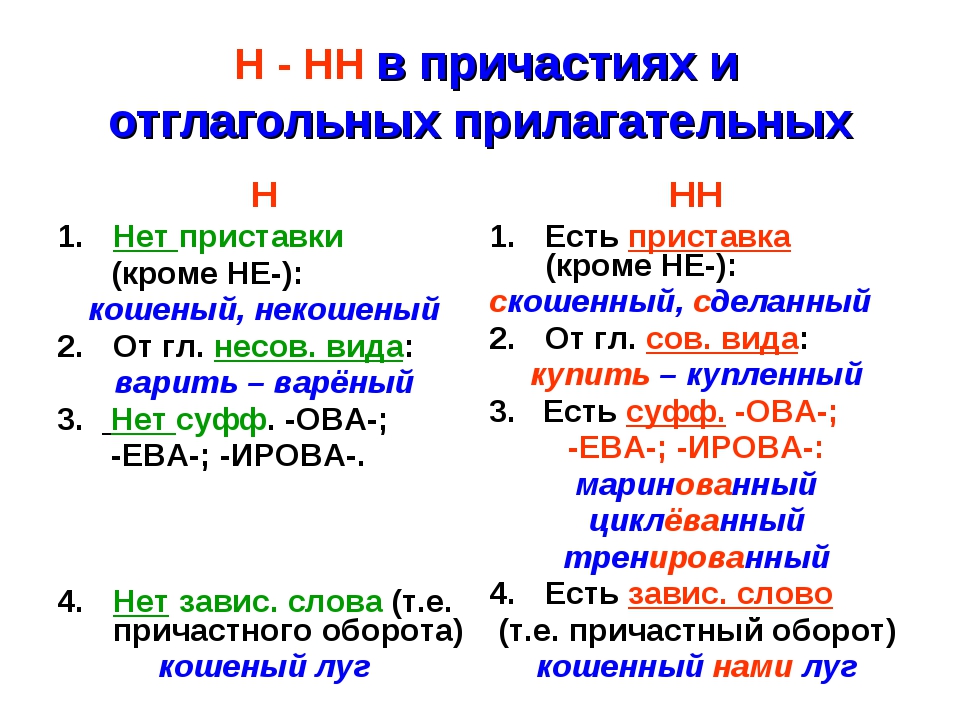

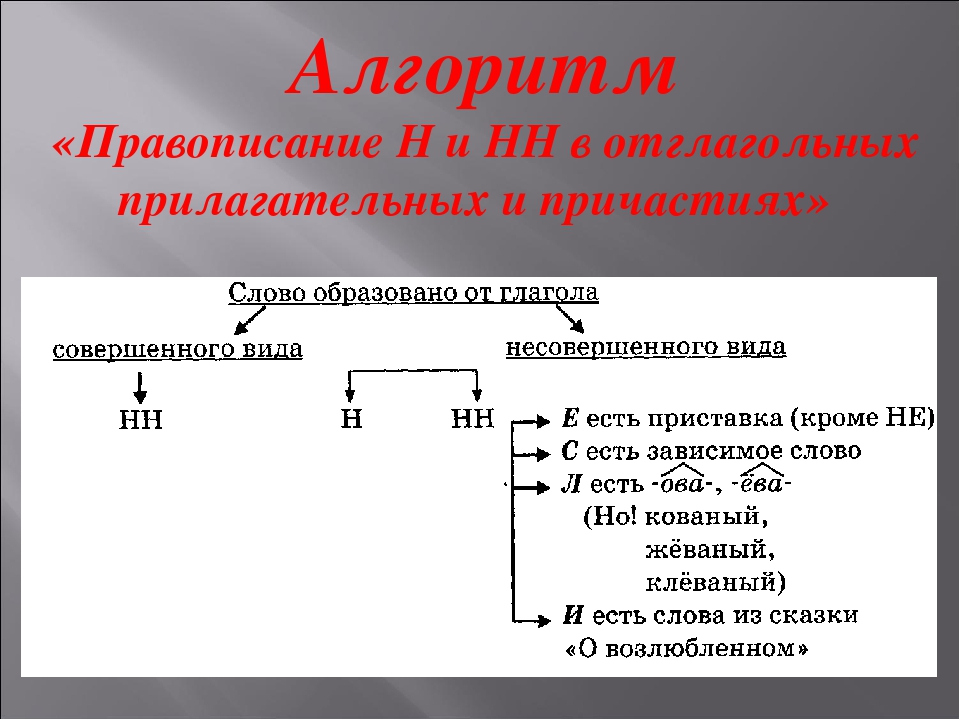

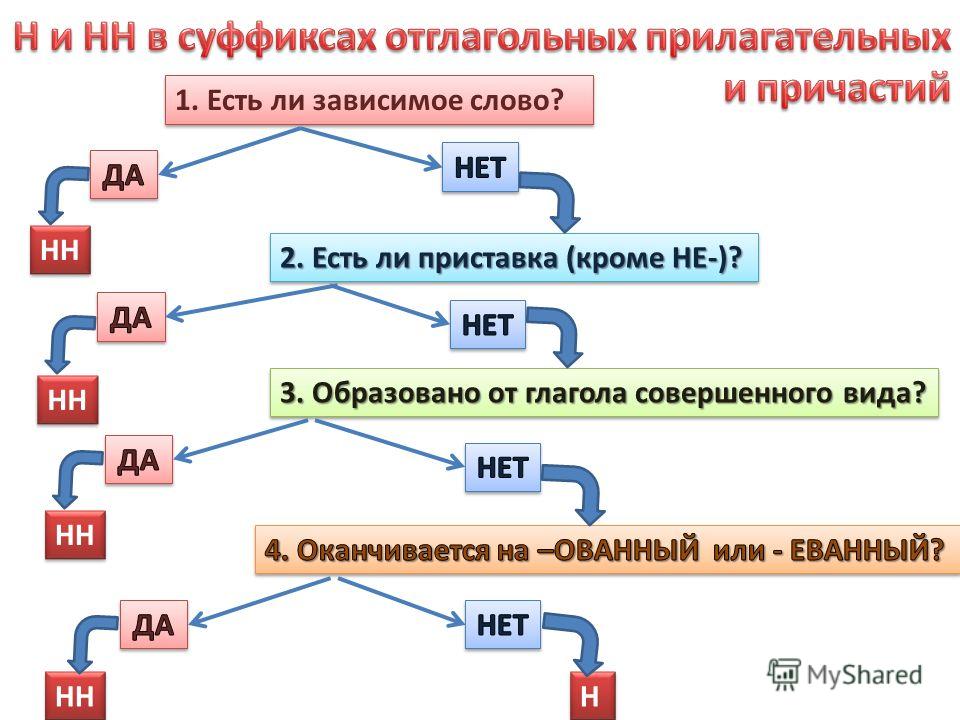

Буквы н — нн в суффиксах прилагательных, причастий и наречий

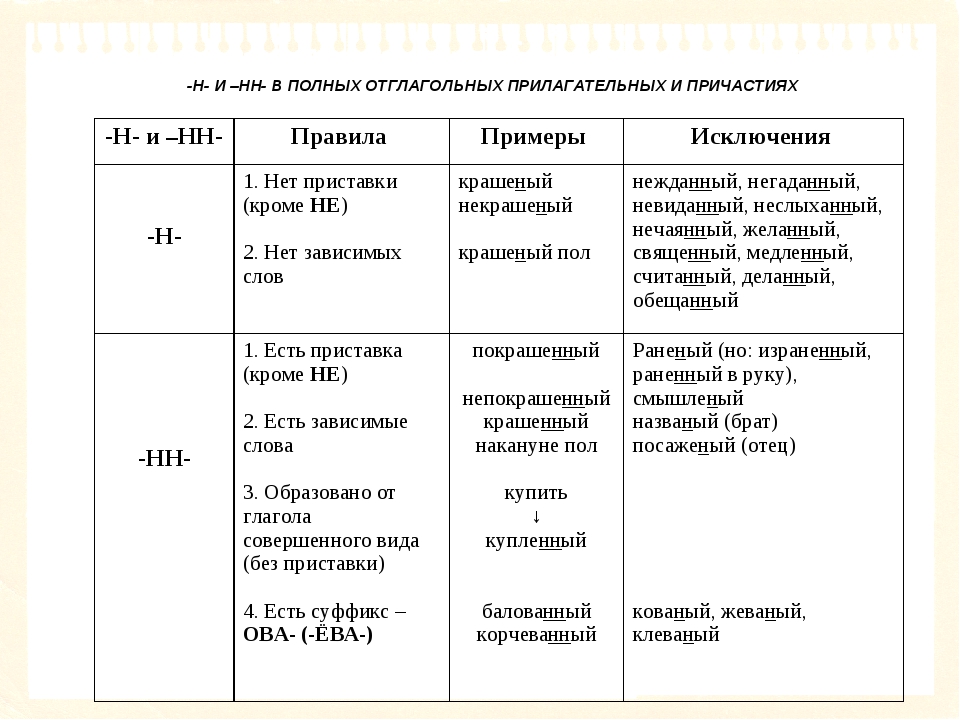

Цели: учить применять правила написания букв н — нн в суффиксах страдательных причастий прошедшего времени и отглагольных прилагательных; формировать умение отличать краткие прилагательные от кратких причастий, наречий и слов категории состояния; воспитывать культуру грамотного письма.

Планируемые результаты: умения применять алгоритм написания букв н — нн в суффиксах прилагательных, причастий и наречий, объяснять языковые явления и процессы, применять пунктуационные и орфографические правила.

Ход урока

I. Организационный момент

II. Лингвистическая разминка

Словарный диктант

(Два ученика работают у доски, остальные — в тетрадях.)

Блестеть, забираю, горит, равнина, вырастить, Ростов, непромокаемый плащ, гореть, располагать, вычесть, посвятить жизнь науке, блистать на балу, сильное возгорание, подровнять чёлку, цветы увядают, разрядить ружьё, лестное сравнение.

(Проверка, анализ ошибок.)

III. Проверка домашнего задания

(Упр. 19 — составление схем предложений на доске.)

IV. Работа по теме урока

1. Работа по карточкам

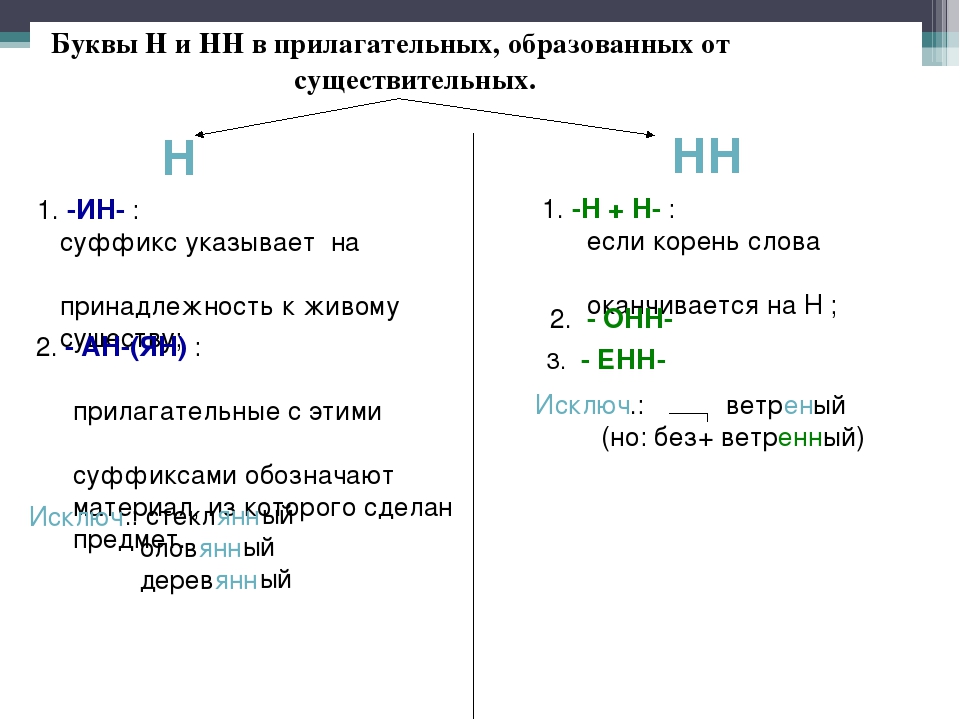

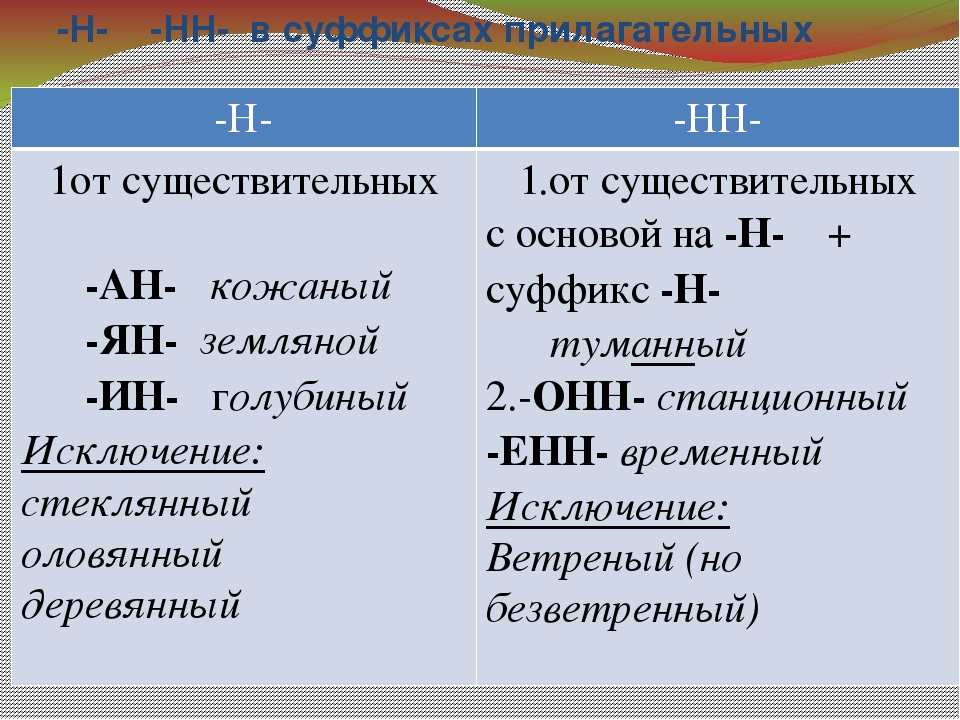

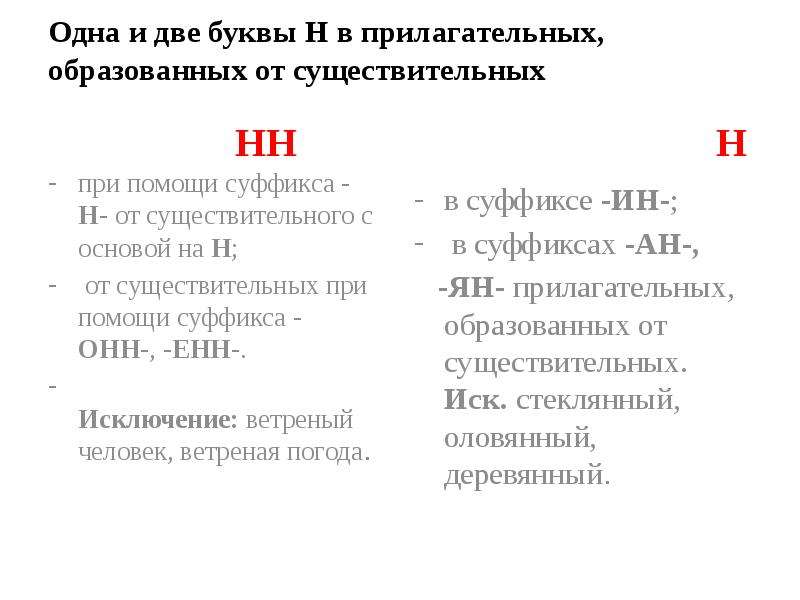

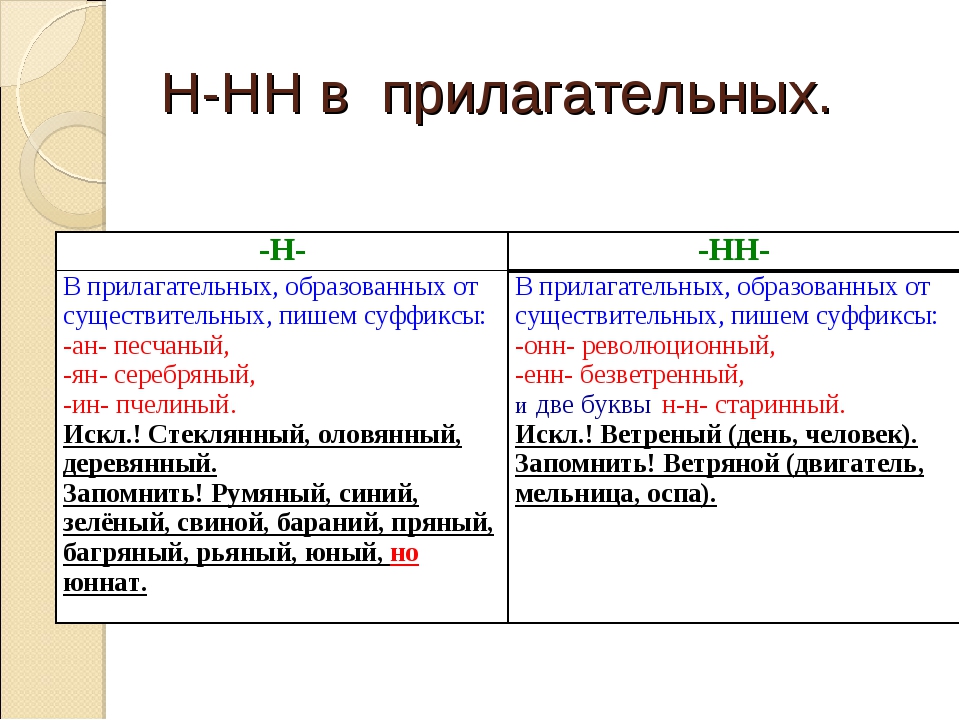

— Образуйте от существительных прилагательные.

Длина, письмо, торжество, сукно, кость, дерево, нефть, тыква, окно, авиация, листва, батальон, ветер.

— Вставьте пропущенные буквы, подчеркните их.

Родстве..ый, серебря..ый, тыкве..ый, ремесле..ый, кожа..ый, оловя..ый, станцио..ый, подли..ый, клюкве..ый, отчая..ый, промышле..ый, сан..ый, пустын..ый, несчаст..ый, петуши..ый.

2. Обсуждение вопроса

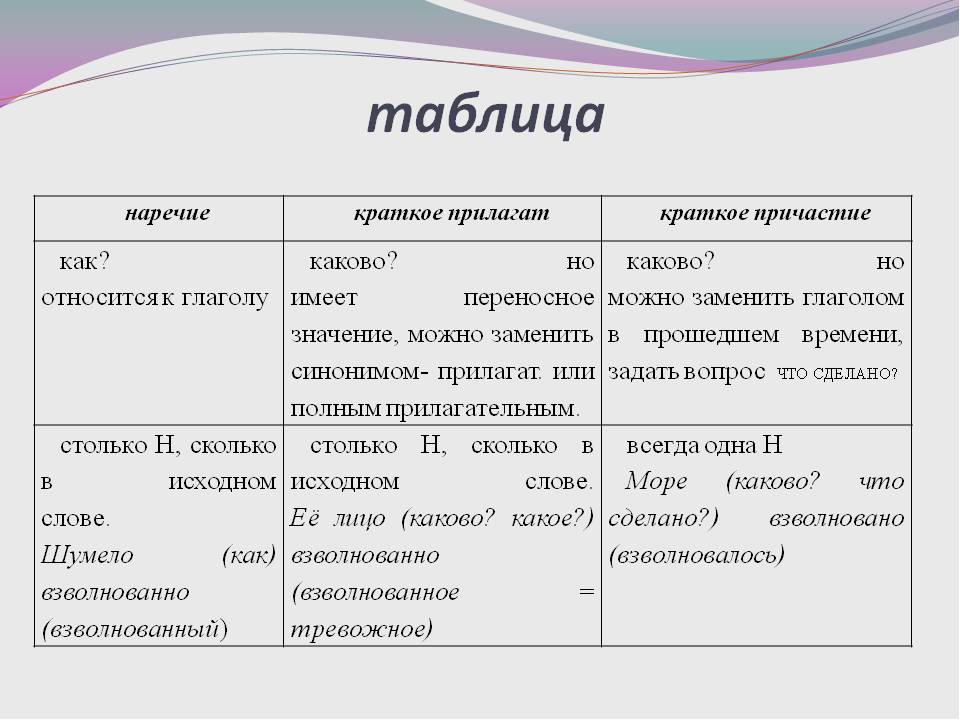

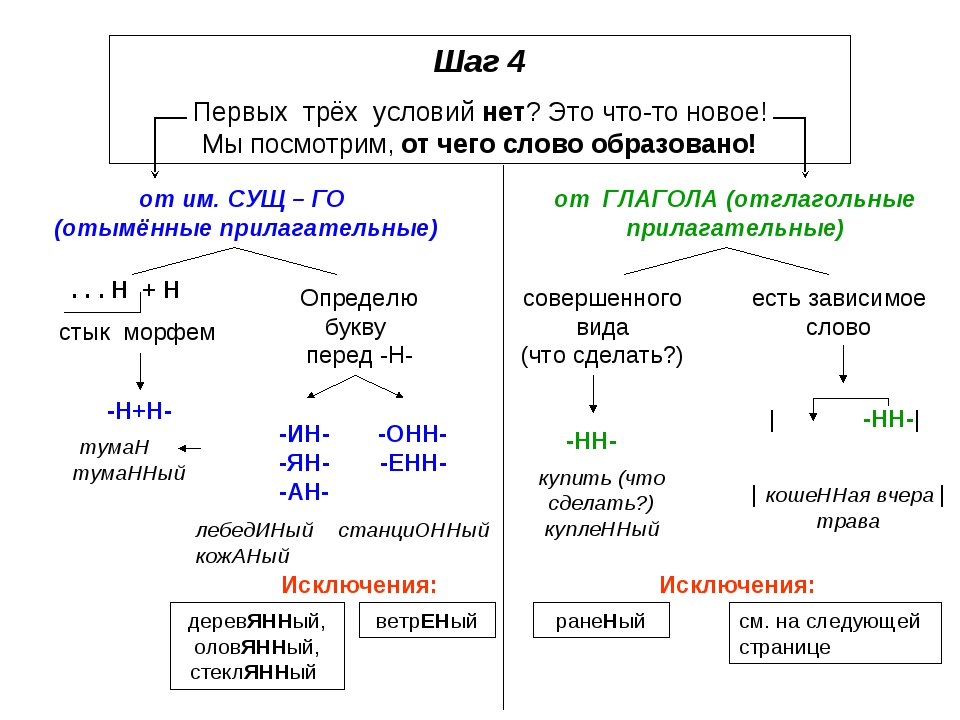

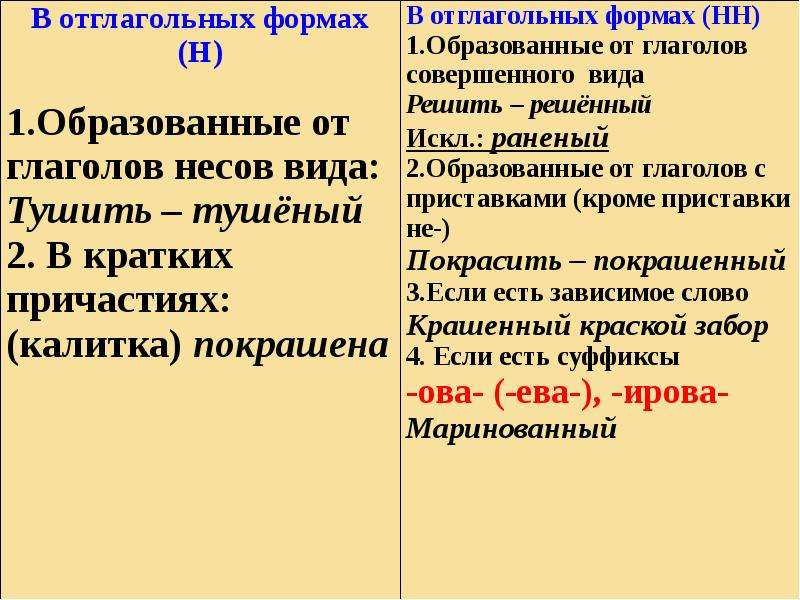

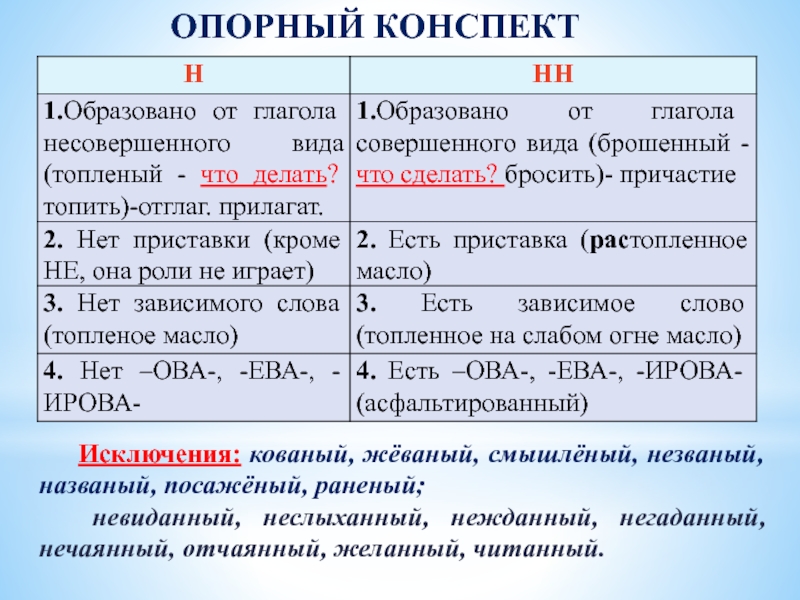

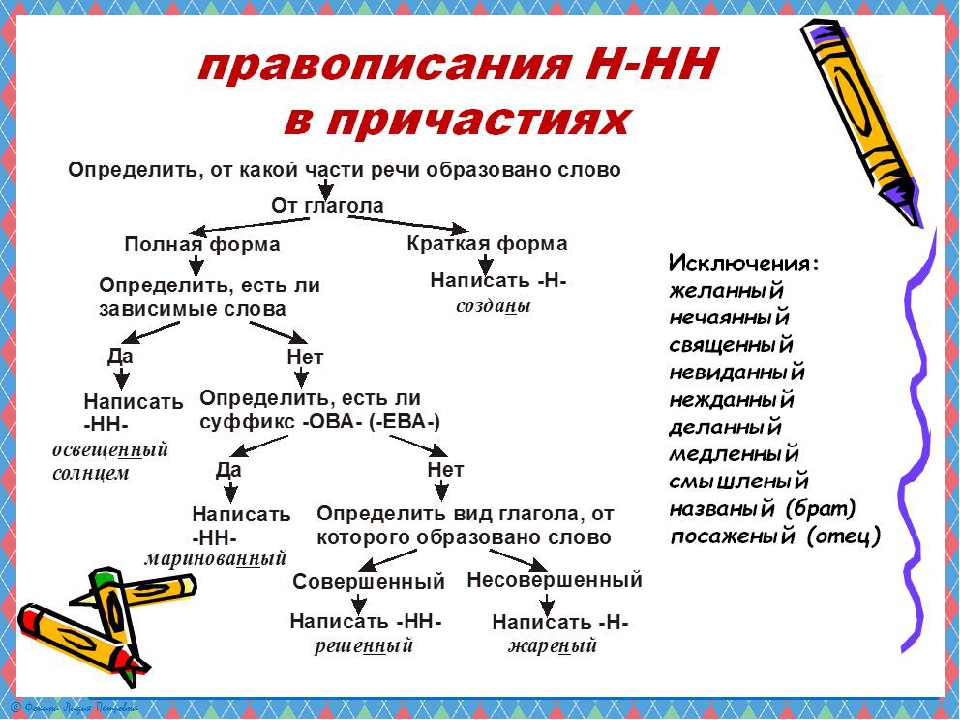

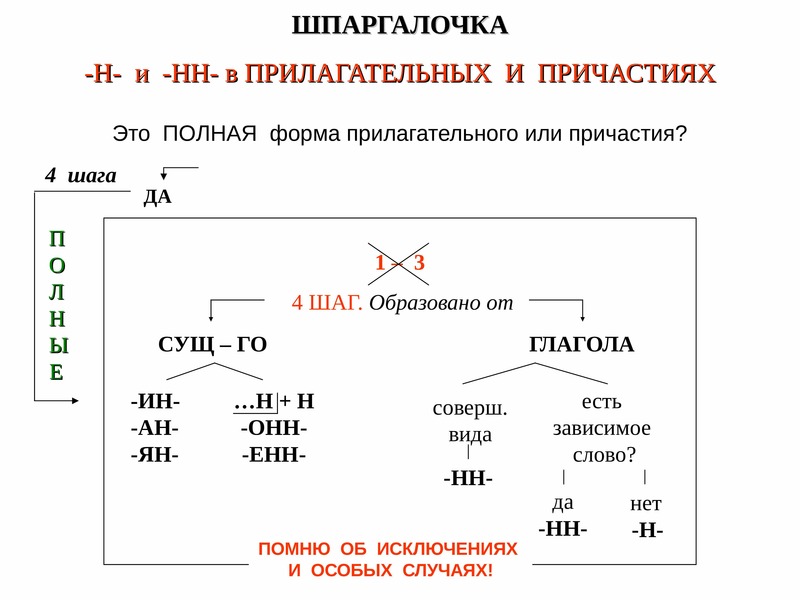

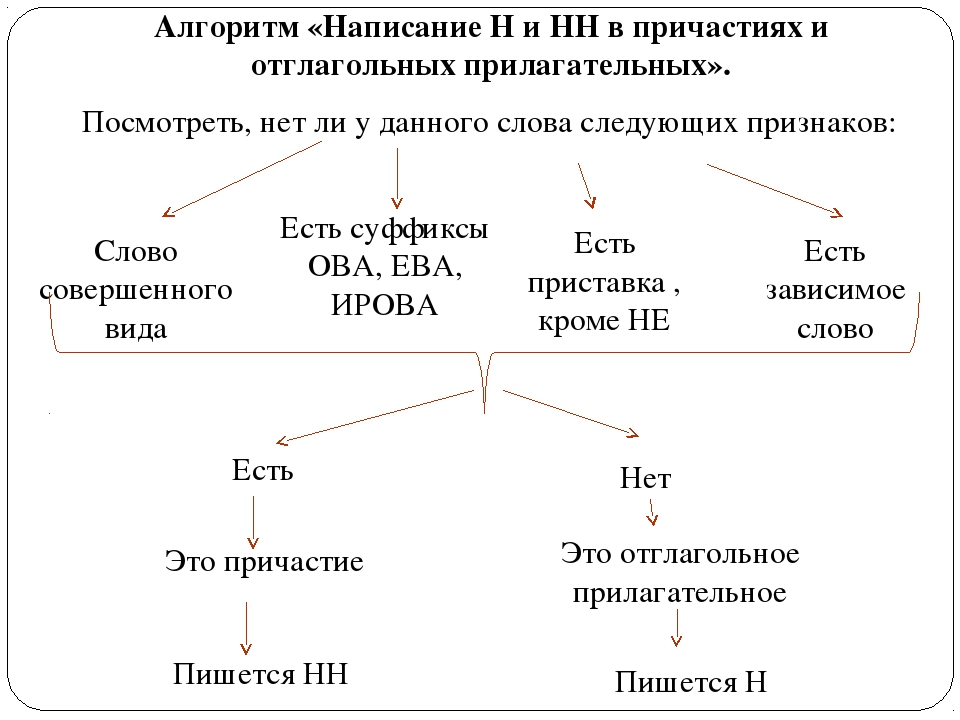

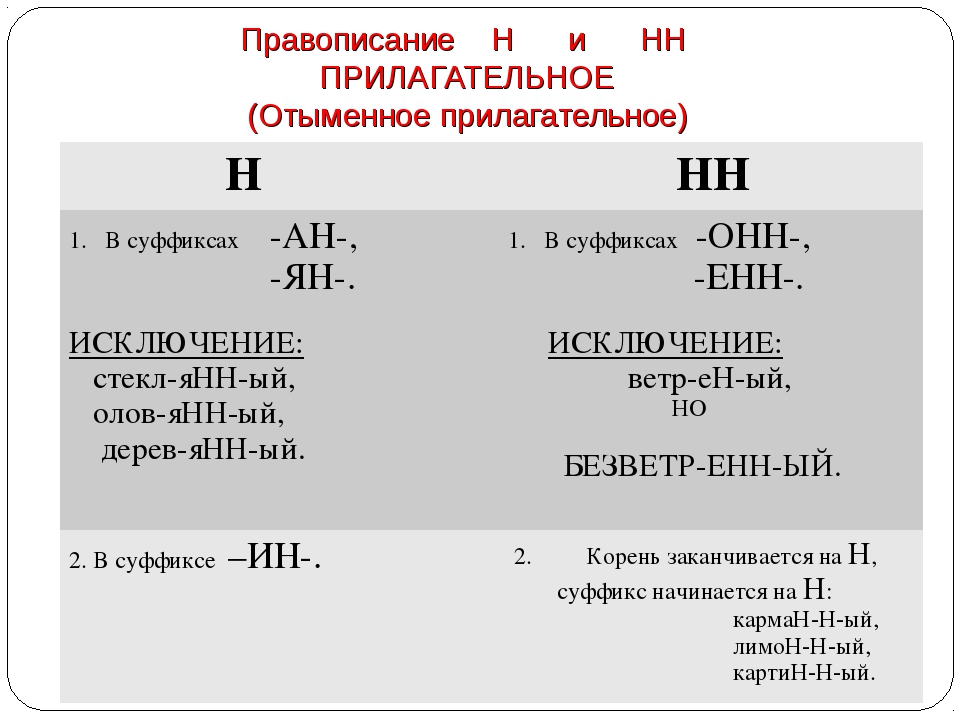

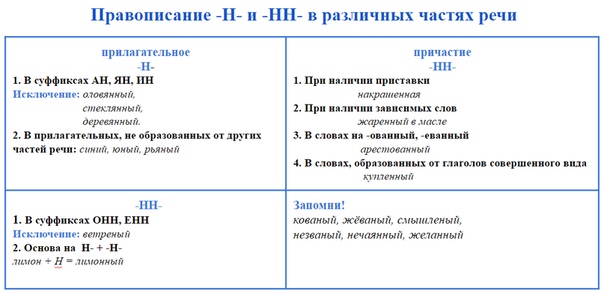

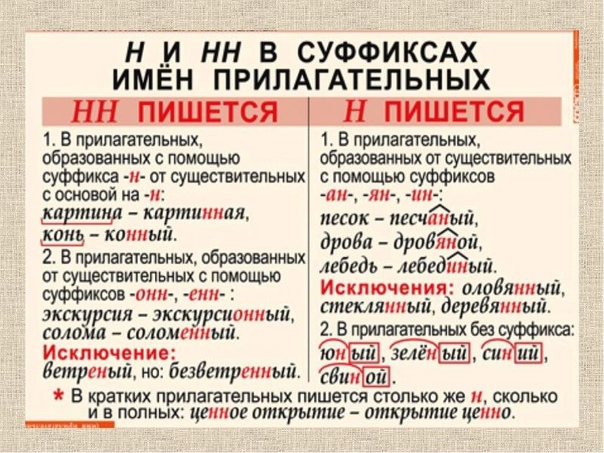

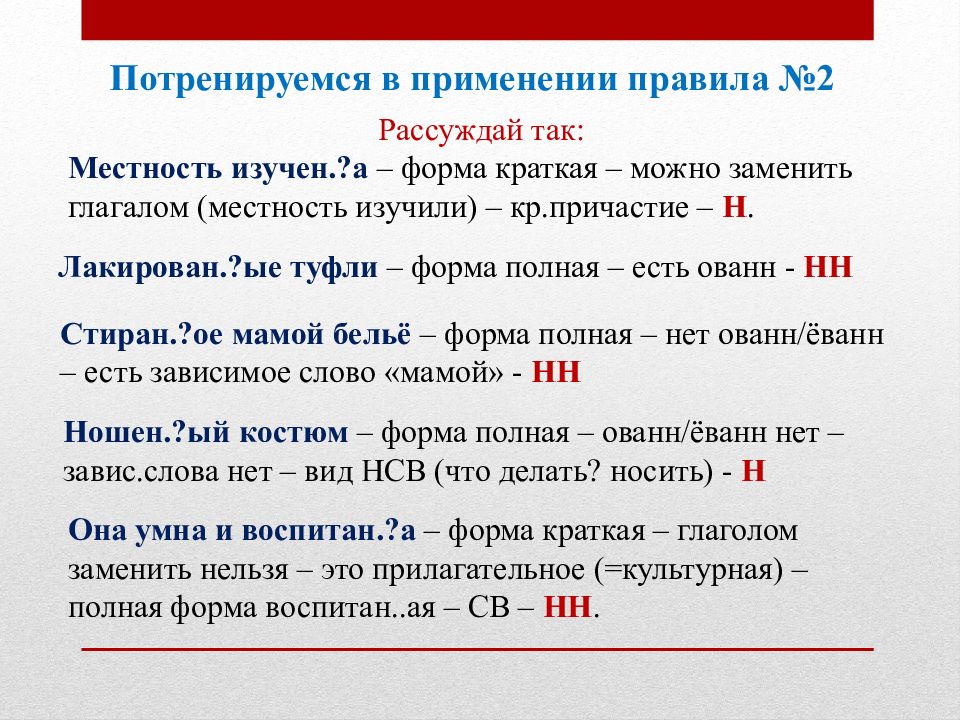

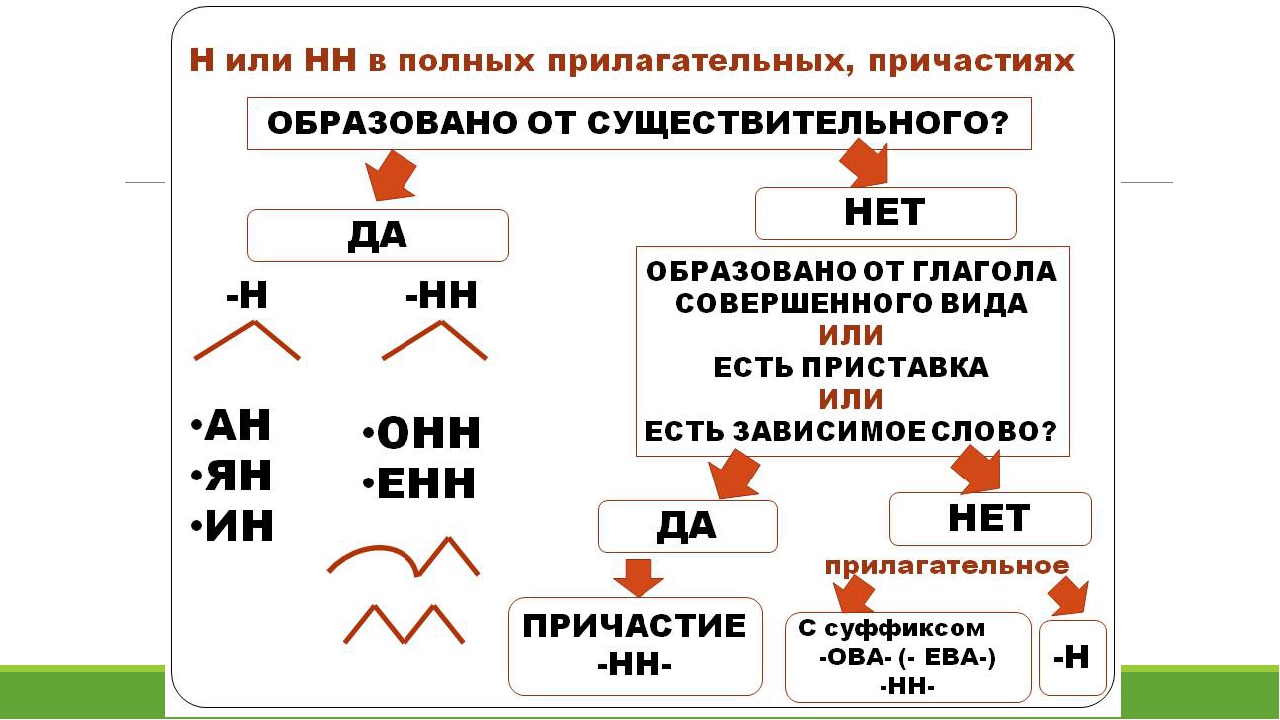

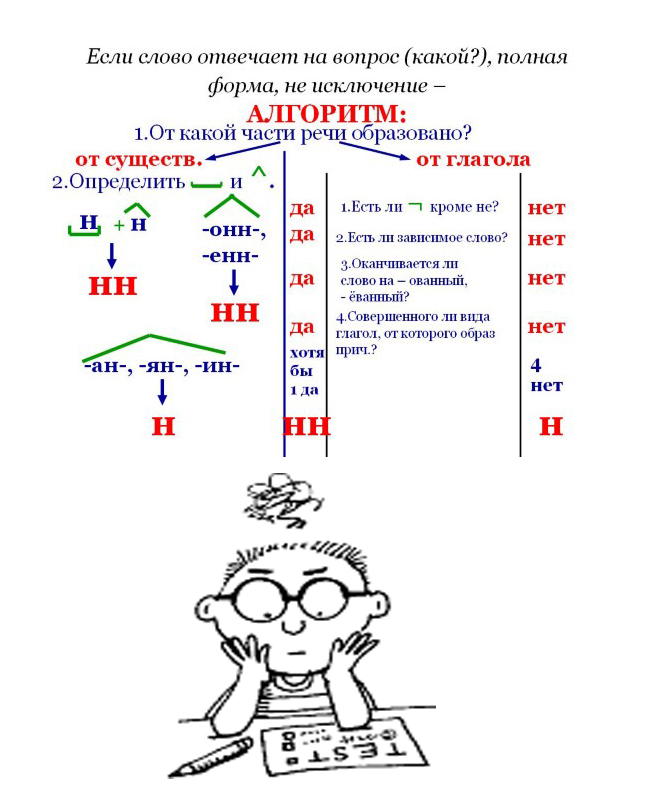

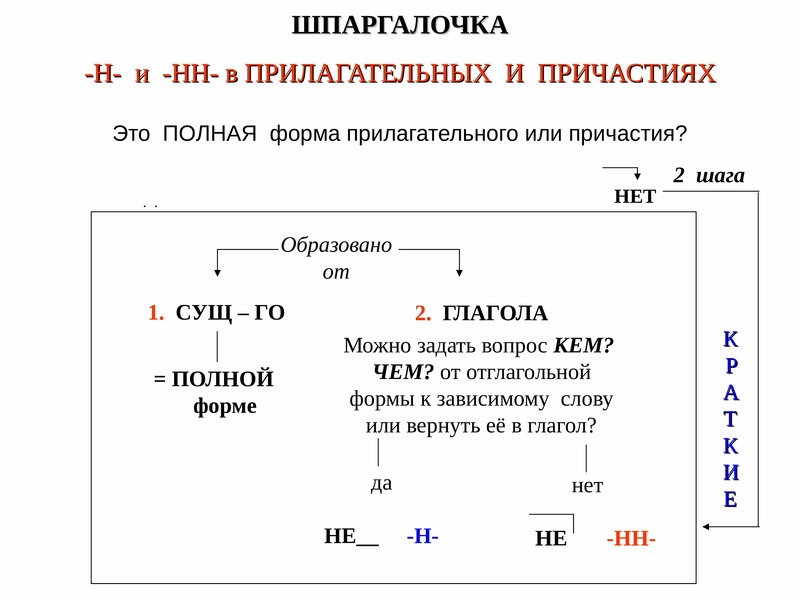

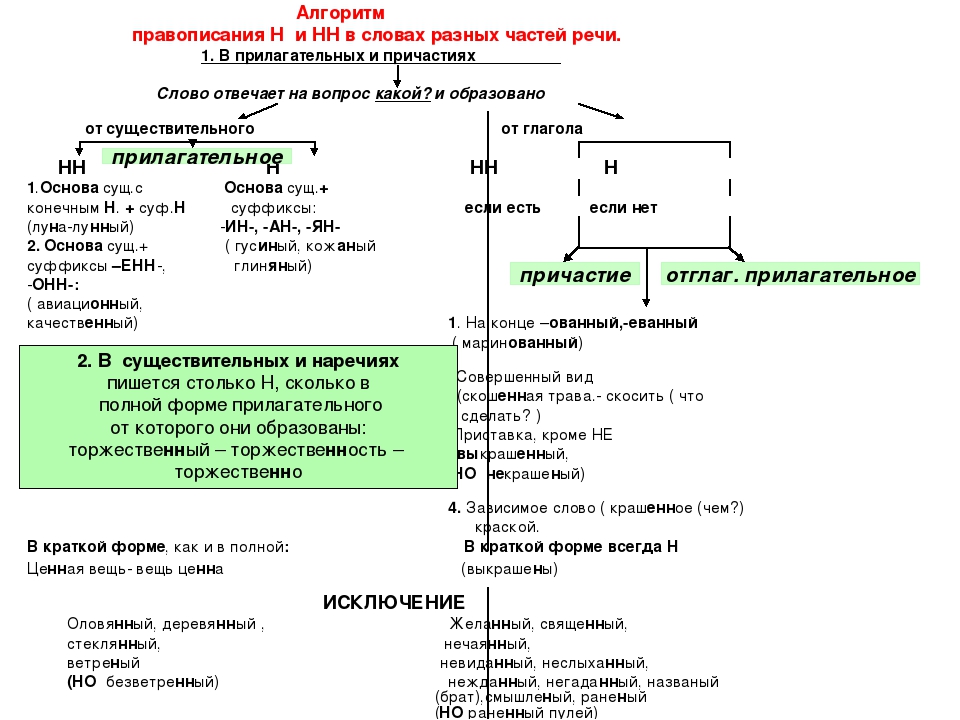

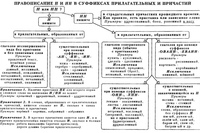

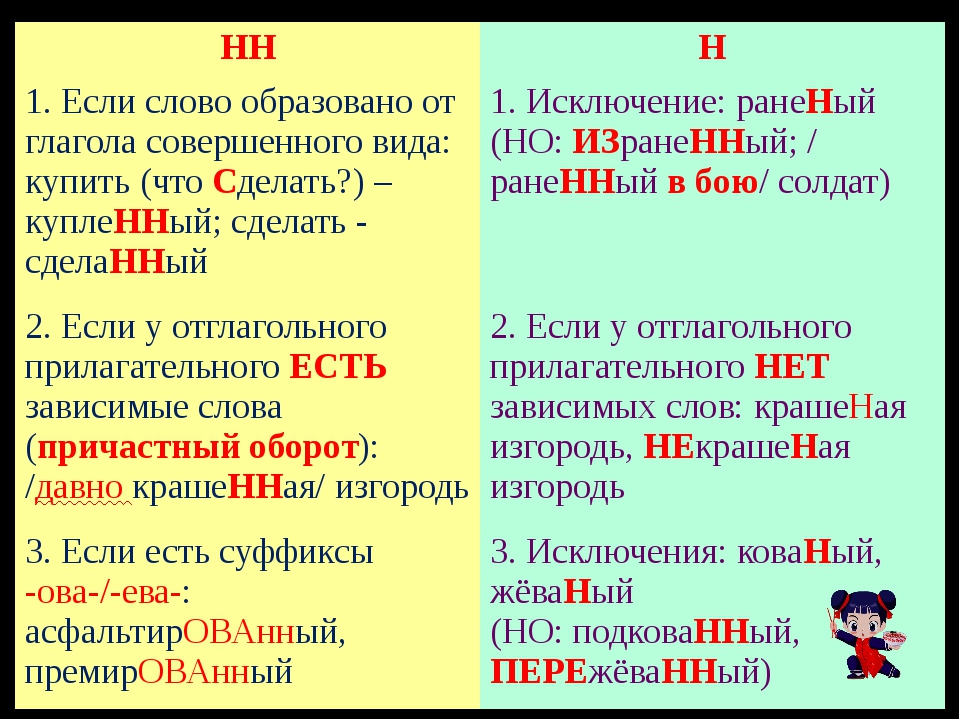

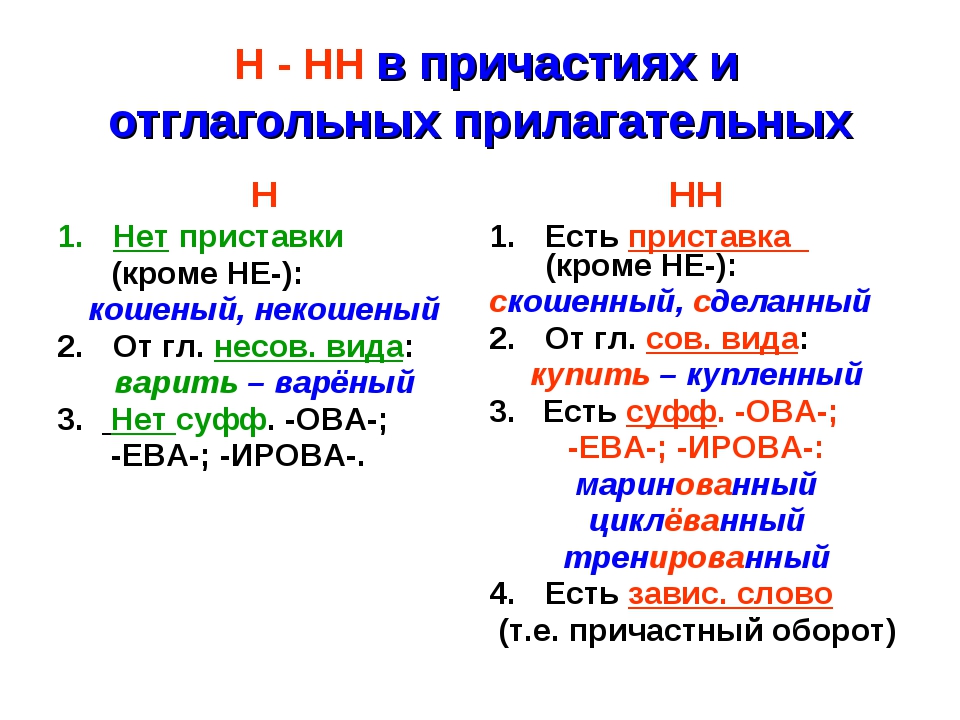

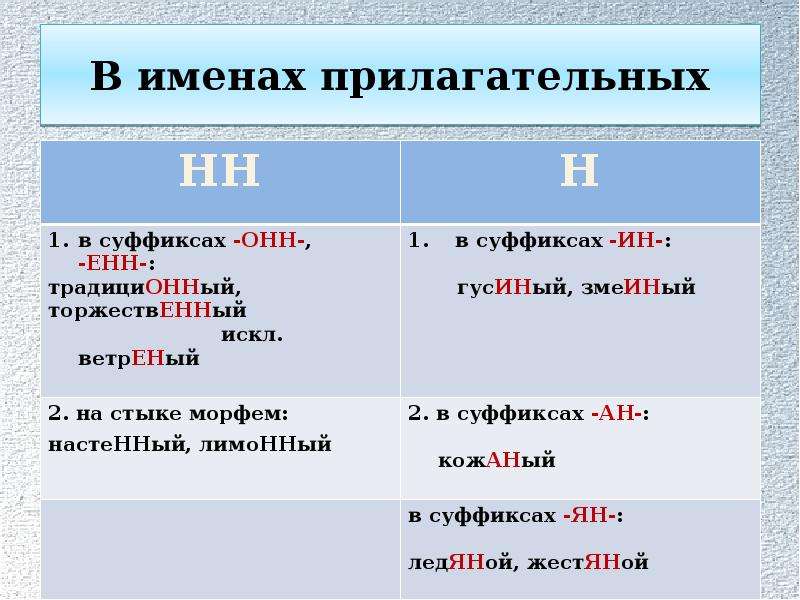

— Почему для написания букв н — нн в суффиксах прилагательных, причастий и наречий важно определить, какой частью речи является слово?

3. Работа по учебнику

1. Чтение и обсуждение материала для самостоятельных наблюдений (с. 18, 19).

2. Упр. 21 — комментированное письмо.

4. Творческий диктант

— Замените словосочетания “сущ. + сущ.” словосочетаниями “сущ. + прил.”, выделите суффиксы. Объясните правописание слов с орфограммами.

+ сущ.” словосочетаниями “сущ. + прил.”, выделите суффиксы. Объясните правописание слов с орфограммами.

Вой зверя, крыша из жести, пробежка по утрам, игрушка из олова, часы для ношения в кармане, погода осенью, шляпка из соломы, забор из камня, статуэтка из глины, напиток из лимона. (Звериный вой, жестяная крыша, утренняя пробежка, оловянная игрушка, карманные часы, осенняя погода, соломенная шляпка, каменный забор, глиняная статуэтка, лимонный напиток.)

5. Работа по учебнику

1. Упр. 22 — обсуждение заданий, самостоятельное выполнение.

2. Упр. 23 — комментированное письмо, выполнение задания.

Комментарии

В упр. 23 нет слов категории состояния, хотя в задании они упоминаются.

6. Тест

(См.: КИМы, тест 4.)

V. Подведение итогов урока

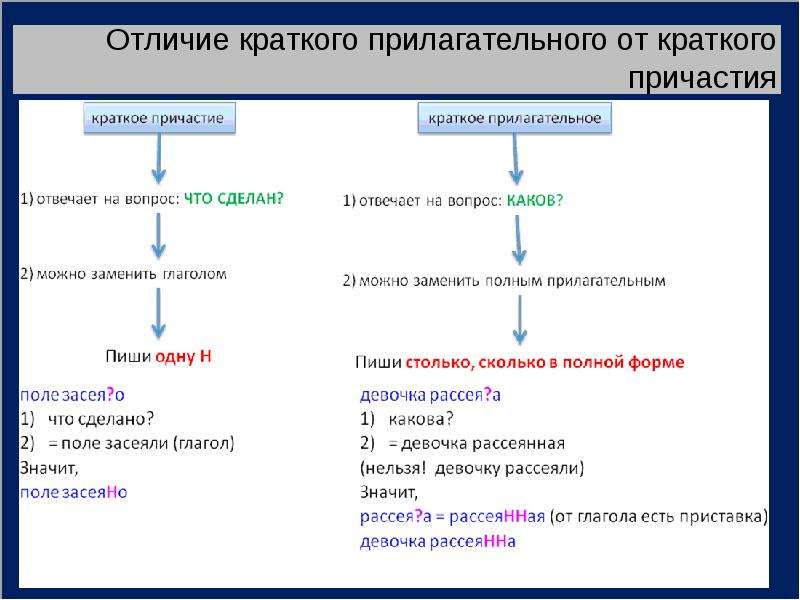

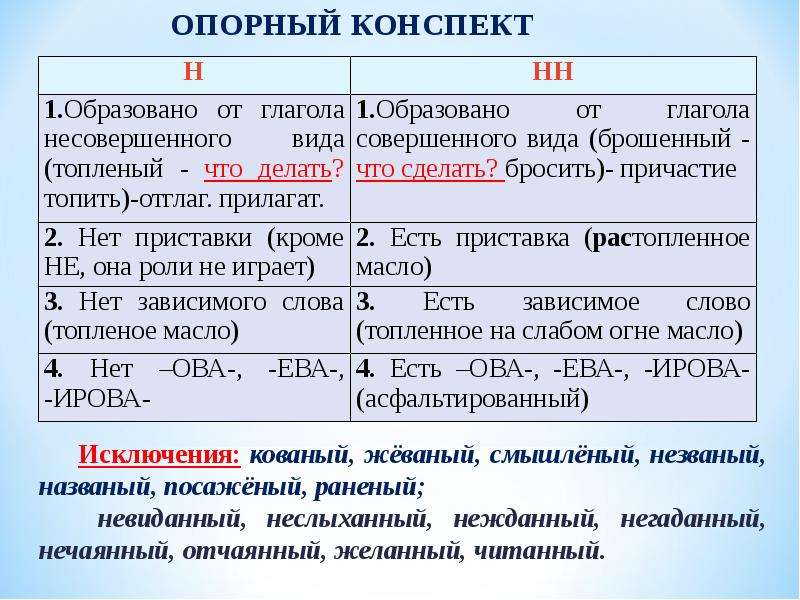

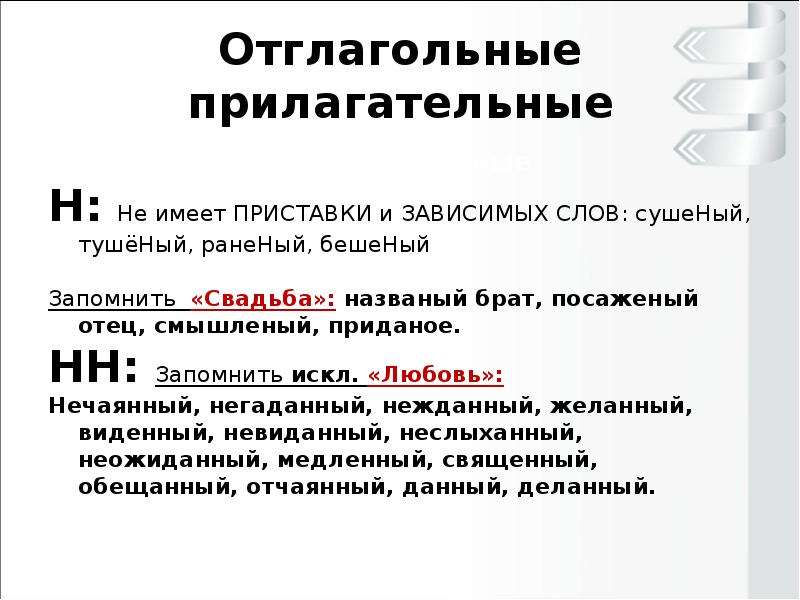

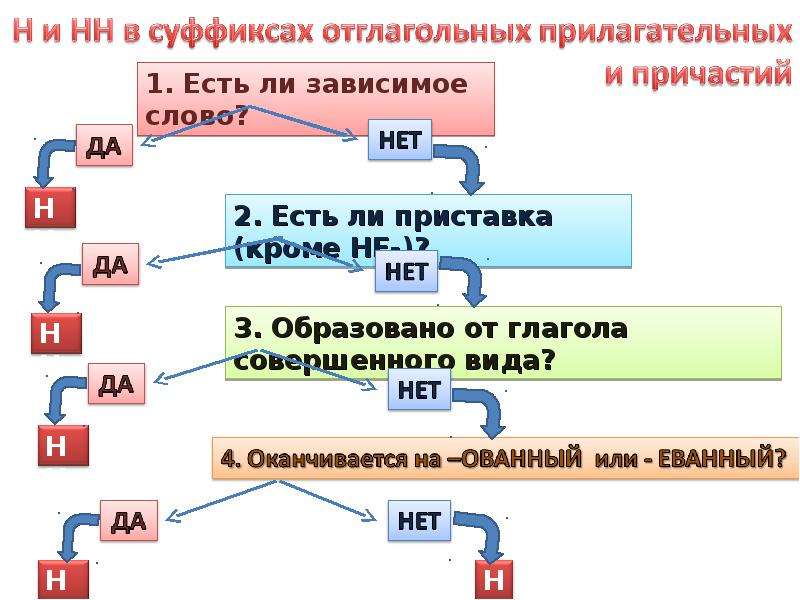

— Как отличить отглагольные прилагательные от страдательных причастий прошедшего времени?

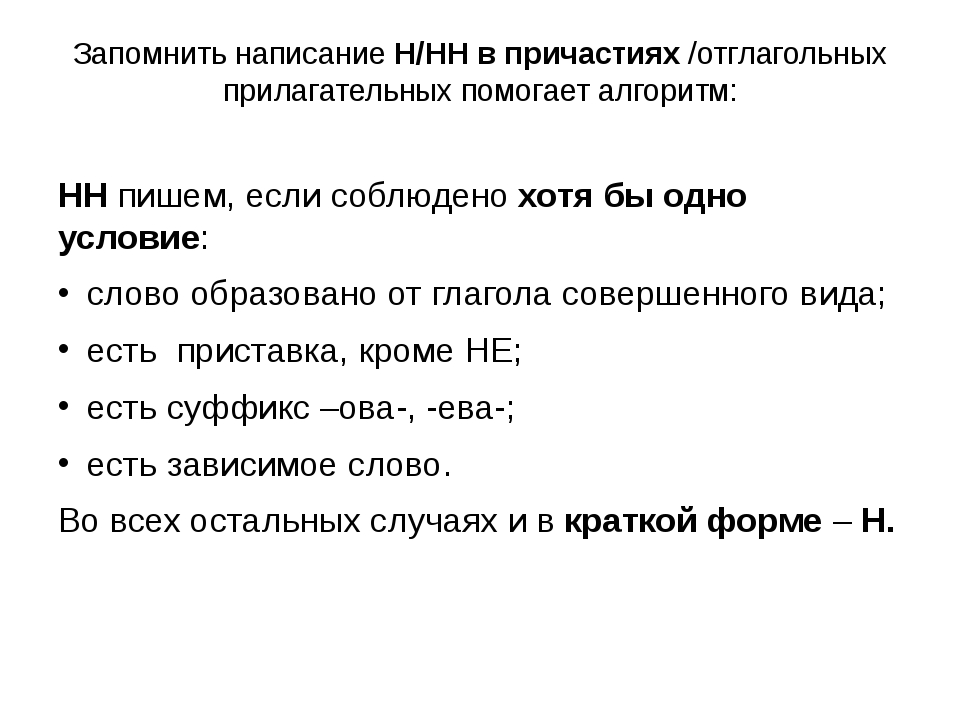

— Сколько н пишется в полных причастиях?

— Сколько н пишется в кратких причастиях?

— В суффиксах каких отглагольных прилагательных пишется две н!

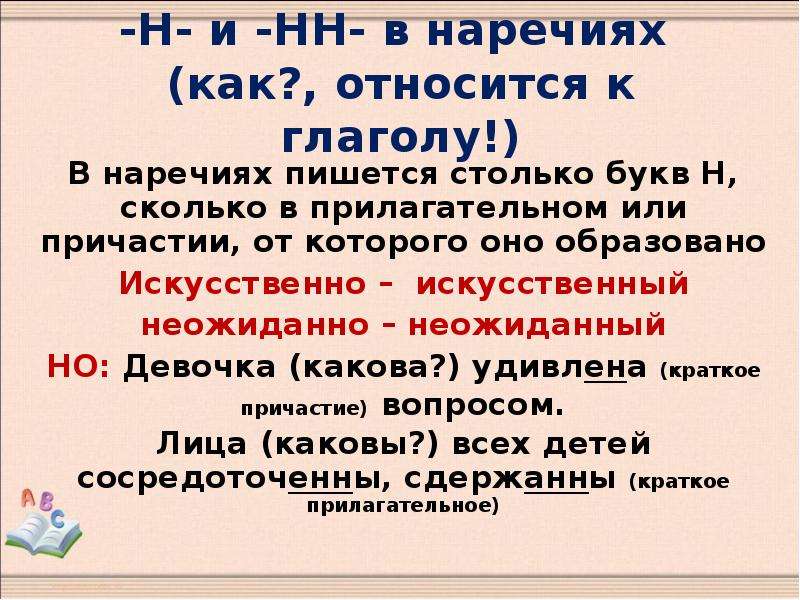

— От чего зависит выбор н и нн в суффиксах наречий?

Домашнее задание

1. Упр. 24.

Упр. 24.

2. Упр. 25, 26 (прочитать тексты).

Подготовка к ЕГЭ по русскому языку

Урок 1. Глагол как часть речи. Правописание глаголов. Разбор заданий ЕГЭ № 11, № 12.

Видео Тест

Урок 2. Причастие как форма глагола. Правописание причастий. Обособление определений. Разбор заданий ЕГЭ № 12, № 17

Видео Тест

Урок 3. Деепричастие как форма глагола. Правописание деепричастий. Обособление обстоятельств. Разбор заданий ЕГЭ № 13, № 17

Видео Тест

Урок 4. Наречие как часть речи. Правописание наречий. Разбор заданий ЕГЭ № 14

Видео Тест

Урок 5. Н и НН во всех частях речи. Разбор заданий ЕГЭ № 15

Видео Тест

Урок 6. Слова категории состояния. Переход одной части речи в другую.

Видео

Урок 7. Служебные части речи. Предлог. Правописание предлогов. Разбор заданий ЕГЭ № 14

Служебные части речи. Предлог. Правописание предлогов. Разбор заданий ЕГЭ № 14

Видео Тест

Урок 8. Союз. Правописание союзов. Разбор заданий ЕГЭ № 14

Видео Тест

Урок 9. Частица. Правописание частиц. Разбор заданий ЕГЭ № 14

Видео Тест

Урок 10. Слитное и раздельное написание НЕ с разными частями речи. Разбор заданий ЕГЭ № 13

Видео Тест

Урок 11. Междометие и звукоподражательные слова. Переход одной части речи в другую

Видео

Урок 12. Вводные и вставные конструкции. Обращения. Разбор заданий ЕГЭ № 18

Видео Тест

Урок 13. Понятие о простом и сложном предложении. Знаки препинания в предложениях с однородными членами. Пунктуация в сложносочинённом предложении. Разбор заданий ЕГЭ № 16

Видео Тест

Урок 14. Знаки препинания в сложноподчинённом предложении и в предложении с разными видами связи. Разбор заданий ЕГЭ № 19,№ 20

Знаки препинания в сложноподчинённом предложении и в предложении с разными видами связи. Разбор заданий ЕГЭ № 19,№ 20

Видео Тест

Урок 15. Знаки препинания в бессоюзном сложном предложении. Разбор заданий ЕГЭ № 21

Видео Тест

Автор и методист

Роман Анатольевич Дощинский, к.п.н., почётный работник образования г. Москвы, автор учебников и методических разработок по русскому языку.Русский язык, 7 класс

Рабочая тетрадь «Русский язык, 7 класс» предназначена для учителей и учащихся 7 классов школ, лицеев, гимназий. Тетрадь представляет собой электронный тренажер, предназначенный для выработки и закрепления знаний и умений по предмету, а также для промежуточной аттестации учащихся в ходе электронных четвертных работ. Рабочая тетрадь состоит из интерактивных заданий, проверка которых производится автоматически – компьютером.

Рабочая тетрадь входит в состав интерактивного мультимедийного учебно-методического комплекса «Облако знаний»; результаты работы с рабочей тетрадью хранятся на облачном сервере проекта.

Содержание рабочей тетради :

-

1. Местоимение

-

1.1. Местоимение как часть речи;

1.2. Разряды местоимений;

1.3. Склонение местоимений разных разрядов;

1.4. Правописание местоимений с частицами «то», «либо», «нибудь», «кое»;

1.5. Правописание «не» и «ни» с отрицательными местоимениями.

2. Наречие

Наречие

-

2.1. Наречие как часть речи;

2.2. Степени сравнения наречий;

2.3. Основные способы образования наречий;

2.4. «НЕ» и «НИ» с наречиями;

2.5. «О», «е» на конце наречий;

2.6. «Н» и «НН» в суффиксах наречий;

2.7. Суффиксы «о», «а» на конце наречий;

2.8. Дефис в наречиях;

2.9. «Ь» после шипящих на конце наречий.

3. Категории состояний-

3.1. Категория состояния как часть речи;

3.2. Группы категорий состояния по значению;

3.3. Синтаксическая роль слов категорий состояния.

4. Причастие-

4.1. Причастие как часть речи;

4.2. Признаки прилагательного и глагола у причастия;

4.3. Словообразование действительных причастий;

4.4. Словообразование страдательных причастий;

4.5. Причастный оборот;

4.6. Гласные перед «Н» и «НН» в причастиях;

4.7. Правописание «Н» и «НН» в причастиях;

4.8. «НЕ» с причастиями.

5. Деепричастие-

5.

1. Деепричастие как часть речи;

1. Деепричастие как часть речи;

5.2. Признаки глагола и наречия у деепричастия;

5.3. Деепричастный оборот;

5.4. Словообразование деепричастий.

6. Служебные части речи-

6.1. Понятие о служебных частях речи;

6.2. Функциональные особенности служебных частей речи;

7. Предлог-

7.1. Предлог как часть речи;

7.2. Правописание предлогов;

7.3. Употребление предлогов.

8. Союз

Союз

-

8.1. Союз как часть речи;

8.2. Сочинительные союзы;

8.3. Подчинительные союзы;

8.4. Правописание союзов;

8.5. Слитные и раздельные написания союзов;

8.6. Правописание союзов «зато», «тоже», «также».

9. Частица-

9.1. Частица как часть речи;

9.2. Значения частиц;

9.3. Различение на письме частиц «не» и «ни»;

9.4. Правописание «не» и «ни» с различными частями речи.

10. Междометие

Междометие

-

10.1. Понятие и синтаксическая роль междометий;

10.2. Знаки препинания при междометьях;

10.3. Звукоподражательные слова;

10.4. Правописание междометий.

11. Переход слов из одной части речи в другую-

11.1. Образование слов путем перехода из самостоятельной речи в другую;

11.2. Образование слов путем перехода из самостоятельной части речи в служебную.

-

1.1. Местоимение как часть речи;

В рабочей тетради по каждому параграфу учебной программы представлены 5–10 интерактивных заданий, например тренажер по деепричастию. Помимо этого тетрадь содержит тематические контрольные работы, в которых обобщается и проверяется материал по разделам, пройденным в течение учебной четверти.

Помимо этого тетрадь содержит тематические контрольные работы, в которых обобщается и проверяется материал по разделам, пройденным в течение учебной четверти.

Тетрадь содержит около 290 разноплановых интерактивных заданий (на установление соответствия, заполнение таблиц, упорядочивание и распределение по группам, выбор варианта ответа, ввод численного или строкового ответа, установление связей, указание объекта на рисунке, синтаксический разбор предложения, морфемный разбор слова), сгруппированных

- в 11 разделов учебной программы 7 класса;

- в 4 контрольные тематические работы в двух вариантах каждая.

Перечень контрольных работ:

- Местоимение. Наречие. Категории состояния,

- Причастие. Деепричастие,

-

Предлог.

Союз,

Союз,

- Частица. Междометие. Переход слов из одной части речи в другую.

Содержание курса соответствует федеральному государственному образовательному стандарту основной школы по русскому языку и примерной программе общеобразовательных учреждений России.

Комплектация продукта:

для ПК:

- приложение для ПК в составе:

- плеер «Облако знаний»,

- рабочая тетрадь по русскому языку для 7 класс,

- индивидуальная лицензия или лицензия на образовательное учреждение.

для СДО:

- рабочая тетрадь по русскому языку для 7 класса в формате SCORM 2004 (ZIP-архив),

- лицензия на образовательное учреждение;

для iPad:

- приложение-плеер «Облако знаний»,

-

рабочая тетрадь по русскому языку для 7 класса.

для Android:

- приложение-плеер «Облако знаний»,

- рабочая тетрадь по русскому языку для 7 класса.

Минимальные системные требования для версии курса для ПК:

Работа с курсом на персональном компьютере возможна как с помощью веб-плеера, функционирующего под управлением веб-браузера, так и с помощью автономного приложения-плеера «Облако знаний». Требования к программному окружению плееров:

Веб-плеер:

Автономный плеер:

- Windows 7/8 + Microsoft Internet Explorer 10/11.

Минимальные требования к видеосистеме: 1024 × 768 пикселей (рекомендуемое разрешение – 1200 × 900 пикселей, цветность системы – не менее 16 миллионов цветов).

Требования по системам ввода: клавиатура и мышь для персонального компьютера.

Ширина интернет канала 64 кБ/с.

Минимальные системные требования для планшетной версии курса:

Плеер для планшетного компьютера функционирует под следующими платформами:

- iOS 6 и выше;

- Android 4.1 и выше.

Минимальные требования к видеосистеме: 1024 × 768 пикселей (рекомендуемое разрешение – 1200 × 900 пикселей).

Требования по системам ввода: сенсорный экран с виртуальной клавиатурой.

Ширина интернет канала 64 кБ/с.

Минимальные системные требования для SCORM-версии курса:

для клиента:

операционная система Microsoft Windows XP/Vista/7/8; процессор Pentium 4 или аналогичный; 512 МБ оперативной памяти; разрешение экрана 1024 × 768 с глубиной цвета 16 бит; Microsoft Internet Explorer 9/10/11;

для сервера: система управления обучением (LMS), соответствующая сертификационным требованиям SCORM 2004 LMS-RTE3, канал связи с пропускной способностью от 1024 кБ/с на пользователя.

Контрольная работа по теме «Деепричастие», «Наречие», «Категория состояния»

kr.docxВариант №1

1. С каким словом НЕ пишется слитно?

а) (не)спится

б) (не)громко

в) (не)прочитав

г) (не)по-летнему

2. В каком наречии на месте пропуска пишется буква А?

а) досрочн..

б) измученн..

в) искос..

г) влев..

3. Определите, какое слово является наречием.

а) дружно

б) кремом

в) боковой

г) убегая

4. В каком слове ударение падает на последний слог?

а) досиня

б) до смерти

в) запросто

г) дотемна

5. В каком наречии на месте пропуска пишется буква и?

а) торопиться н…зачем

б) н…откуда ждать помощи

в) не уйдёшь н…куда

г) н…где остановиться

6. В каком предложении допущена речевая ошибка?

В каком предложении допущена речевая ошибка?

а) Утреннее солнце греет бережно и ласково.

б) В этом месте речка была перегорожена огромным валуном.

в) Сегодня обратно пошел дождь.

г) Кое-где попадается и белый гриб.

7. В какой строке на месте пропуска в каждом слове пишется Ь?

а) рож.., горяч.., береч.., вскач…

б) отреж.., навзнич.., мыш.., невтерпеж…

в) тиш.., печеш.., товарищ.., замуж…

г) реч.., наотмаш.., стрич.., съеш…

8. Укажите, к какой части речи принадлежит слово «лучше»:

а) Мне уже лучше, чем вчера. _______________________________________

б) Положение наше лучше, чем у них. ________________________________

в) Эту работу он сделал лучше. _____________________________________

II. Прочитайте текст и выполните задания.

(1)Ещё нигде не румянилась заря, но уже забелелось на востоке… (2)Кое-где стали раздаваться живые звуки, голоса, и жидкий, ранний ветерок пошёл бродить и порхать над землёю. (3)Я, проворно встав, подошёл к мальчикам.

(3)Я, проворно встав, подошёл к мальчикам.

1. Из предложения (1) выпишите слово категории состояния.

2. Из предложения (2) выпишите наречие.

3. Из предложения (3) выпишите неизменяемые части речи.

III. Напишите сочинение-рассуждение на тему : «Нужно ли читать книги вслух в кругу семьи ?»

Ответы

I.

1 б

2 в

3 а

4 г

5 в

6 в

7 г

8.

КС

КР.ПРИЛ

НАРЕЧ

II.

ЗАБЕЛЕЛОСЬ

КОЕ-ГДЕ

ПРОВОРНО

ВСТАВ

МАОУ «Гимназия № 96 г. Челябинска»

Экзаменационные билеты

по русскому языку

для проведения промежуточной аттестации в 7-х классах

2008 – 2009 учебный год

Билет 1

1. Правописание гласных в корне

— проверяемые безударные гласные;

— непроверяемые гласные в корне;

— чередующиеся гласные в корне слова.

2. Анализ текста.

Билет 2

1. Правописание согласных в корне

Правописание согласных в корне

— непроизносимые согласные;

— звонкие и глухие согласные.

— двойные согласные.

2. Анализ текста.

Билет 3

— неизменяемые приставки;

— приставки на –З и – С;

— приставки ПРЕ- и ПРИ-;

— гласные Ы и И после приставок на согласную.

2. Анализ текста.

Билет 4

2. Анализ текста.

Билет 5

2. Анализ текста.

Билет 6

2. Анализ текста.

Билет 7

2. Анализ текста.

Билет 8

2. Анализ текста.

Билет 9

2. Анализ текста.

Билет 10

1. Имя числительное как часть речи;

— правописание числительных;

— склонение количественных числительных;

— употребление числительных.

2. Анализ текста.

Билет 11

1. Местоимение как часть речи;

— разряды местоимений;

— правописание местоимений.

2. Анализ текста.

Билет 12

2. Анализ текста.

Билет 13

2. Анализ текста.

Билет 14

2. Анализ текста.

Билет 15

Слитное и раздельное написание НЕ с причастиями. Причастный оборот. Выделение причастных оборотов запятыми.

Слитное и раздельное написание НЕ с причастиями. Причастный оборот. Выделение причастных оборотов запятыми. 2. Анализ текста.

Билет 16

2. Анализ текста.

Билет 17

2. Анализ текста.

Билет 18

2. Анализ текста.

Билет 19

2. Анализ текста.

Билет 20

1. Частица как часть речи. Разряды частиц. Правописание частиц.

2. Анализ текста.

Билет 21

1. Отрицательные частицы НЕ и НИ. Частица НИ, Приставка НИ, союз НИ – НИ.

Билет 22

Н-НН в различных частях речи.

Н-НН в различных частях речи.2. Анализ текста.

Билет 23

2. Анализ текста.

Билет 24

2. Анализ текста.

Билет 25

2. Анализ текста.

Презентация «Слово категории состояния»

(С)начала сентября воздух начинает (по)немногу холодеть. Утром вы замечаете, что трава (чуть)чуть побелела. Свеж… Лужи сплош… засыпа(н,нн)ы листьями. (По)осеннему мелкие дожди совсем (не)похожи на летние: они идут бе..преста(н,нн)о, и земля (не)просыхает скоро. Ветер дует

(С)начала сентября воздух начинает (по)немногу холодеть. Утром вы замечаете, что трава (чуть)чуть побелела. Свеж… Лужи сплош… засыпа(н,нн)ы листьями. (По)осеннему мелкие дожди совсем (не)похожи на летние: они идут бе..преста(н,нн)о, и земля (не)просыхает скоро. Ветер дует

(без)устали, разнося (далеко)далеко созревшие сем. .на дерев..ев. Листья на дерев..ях нач..нают (кое)где желтеть. Поля (мало)помалу желтеют, лиш…(по)прежнему зеленеет озимь.

Словарный диктант

.на дерев..ев. Листья на дерев..ях нач..нают (кое)где желтеть. Поля (мало)помалу желтеют, лиш…(по)прежнему зеленеет озимь.

Словарный диктант

Тихо ответили жители, тихо проехал обоз. Тихо ответили жители, тихо проехал обоз. Тихо в темной деревне. Одинакова ли синтаксическая роль?

СТС

Слово категории состояния (СКС) как? каково?

Слово категории состояния (СКС) как? каково?

категория состояния группы по значению состояние природы состояние человека оценка состояния В джунглях было сыро, душно. А на душе необъятно и чудно… Над старостью смеяться грех. Надо жизнь сначала переделать…

И скучно, и грустно, и некому руку подать.

И скучно, и грустно, и некому руку подать.

В минуту душевной невзгоды…

Шалун уж заморозил пальчик:

Ему и больно, и смешно. А мать грозит ему в окно.

Да, можно выжить в зной, в грозу, в морозы,

Да, можно голодать и холодать,

Идти на смерть…

Но эти три березы

При жизни никому нельзя отдать.

Найдите СКС, что они обозначают?

А мать грозит ему в окно.

Да, можно выжить в зной, в грозу, в морозы,

Да, можно голодать и холодать,

Идти на смерть…

Но эти три березы

При жизни никому нельзя отдать.

Найдите СКС, что они обозначают?

2. Морфологические признаки: 1. Постоянные – неизменяемость Стало теплее. В маленькой комнате стало теплее всего.

3. Синтаксическая роль в предложении: Темно. Душно. Светло.

не путать!

Слова категории состояния

Наречия

Краткие прилагательные

Как здесь

тихо!

Он говорил

тихо.

Озеро тихо.

.

как?

каково?

СКС

наречие

кр. прил.

каково?

прил.

каково?

Хоть тяжело подчас в ней бремя, телега на ходу легка… И тяжело Нева дышала, как с битвы прибежавший конь. «Эй! Пошёл, ямщик!..» — «Нет мочи: коням, барин, тяжело…» Задание 1 скс . . наречие кр. прил. (каково?) (как?) (каково?) +

Зимой без снега скучно. Зимой без снега скучно. Это стихотворение длинно и скучно, как и все, что он пишет. Он пишет длинно и скучно.

Сегодняшнее утро как никогда солнечно. Сегодняшнее утро как никогда солнечно. Ее глаза светились радостно и солнечно. С утра было солнечно, но после обеда заморосил холодный и нудный дождь.

1. Деревья слабо шумят, отлитые тенью.

Вам холодно немножко, вы закрываете

лицо воротником шинели, вам дремлется.

3. Голова томно кружится от избытка благоуханий. 4. Вот уже жарко стало, быстро сохнет трава.

5. Кругом ещё ярко светит солнце.

6. Но вот слабо сверкнула молния.

7. Боже мой, как весело сверкает всё кругом!

4. Вот уже жарко стало, быстро сохнет трава.

5. Кругом ещё ярко светит солнце.

6. Но вот слабо сверкнула молния.

7. Боже мой, как весело сверкает всё кругом!

: что это значит?

Марка автомобиля — это марка транспортного средства, а модель относится к названию автомобильного продукта, а иногда и к ряду продуктов.

Например, Toyota — это марка автомобиля, а Camry — модель автомобиля.

Марка, модель, год выпуска, тип кузова и уровень отделки салона — все это влияет на стоимость автомобиля и его страховые тарифы.

Отличия автомобилей одной модели

Автомобили одной и той же модели могут сильно различаться по типу кузова и уровню отделки салона.Часто просто знать модель автомобиля может быть недостаточно, чтобы правильно идентифицировать автомобиль, когда:

Варианты кузова

Автопроизводители могут выпускать определенную модель автомобиля с несколькими вариантами кузова. Например, вы можете купить Honda Civic 2018 года в кузове седан, купе или хэтчбек. Вот некоторые из наиболее распространенных типов кузова:

Например, вы можете купить Honda Civic 2018 года в кузове седан, купе или хэтчбек. Вот некоторые из наиболее распространенных типов кузова:

Тип кузова определяет общую форму автомобиля, количество дверей и механическую настройку, такую как двигатель, трансмиссия и трансмиссия.Форма кузова может быть самым важным отличием автомобиля, потому что он оказывает большое влияние на то, как лучше всего использовать автомобиль.

{«backgroundColor»:»серый»,»content»:»\u003C\/p\u003E\n\n\u003Ch4\u003EСтили кузова\u003C\/h4\u003E\n\n\u003Cp\u003EПроизводители автомобилей могут сделать определенной модели автомобиля с несколькими вариантами кузова. Например, вы можете купить Honda Civic 2018 года в кузове седан, купе или хэтчбек. Вот некоторые из наиболее распространенных типов кузова:\u003C\/p\u003E\n\n \u003Cp\u003E\u003Cdiv class=\»ShortcodeList—root\»\u003E\n\n \u003Cdiv class=\»ShortcodeList—content ShortcodeList—content-margin\»\u003E\n \u003Cdiv class=\» ShortcodeList—column\»\u003E\n \u003Cul class=\»ListUnordered—root ListUnordered—bullet\»\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n Coupe\ n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n Седан\n \u003C\/li\u003E\n \u003C\/ul\u003E\n \ u003C\/div\u003E\n \u003Cdiv class=\»ShortcodeList—column\»\u003E\n \u003Cul class=\»ListUnordered—root ListUnordered—bullet\» \u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n Hatchback\n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E \n Конвертируемый\n \u003C\/li\u003E\n \u003C\/ul\u003E\n \u003C\/div\u003E\n \u003Cdiv class=\»ShortcodeList—столбец\»\u003E\n \u003Cul class=\»ListUnordered—root ListUnordered—bullet\»\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n Вагон\n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n SUV\n \u003C\/li\u003E\n \u003C\/ul\u003E\n \u003C\/div\u003E\n \u003C\/ div\u003E\n\u003C\/div\u003E\n\n\u003C\/p\u003E\n\n\u003Cp\u003EТип кузова сообщает об общей форме автомобиля, количестве дверей и механической настройке, такой как двигатель , трансмиссия и ходовая часть. Форма кузова может быть самым важным отличием автомобиля, поскольку от него зависит, как лучше всего использовать автомобиль.\n»,»padding»:»double»}

Форма кузова может быть самым важным отличием автомобиля, поскольку от него зависит, как лучше всего использовать автомобиль.\n»,»padding»:»double»}

Комплектация

Помимо вариантов кузова, производитель автомобилей может предложить несколько вариантов отделки для данной модели. Уровни отделки салона относятся к оборудованию и стилю конкретного автомобиля.

Например, седан Honda Civic 2018 года имеет шесть различных комплектаций:

Общие уровни отделки салона:

- Стандарт: без обновлений.

- Sport: улучшенные характеристики двигателя и управляемость.

- Luxury: модернизированный салон и более плавная подвеска.

Некоторые автомобили имеют буквенно-цифровые обозначения, которые могут затруднить определение разницы между названием модели и комплектацией автомобиля. BMW, Mercedes и Lexus практикуют эти соглашения об именах.

BMW, Mercedes и Lexus практикуют эти соглашения об именах.

Для этих автомобилей необходимо расшифровать название автомобиля, чтобы найти название модели и пакет отделки салона.

Например, рассмотрим BMW 540i 2018 года. В «540i» первая цифра указывает на то, что модель относится к 5-й серии, а 40i указывает на уровень отделки салона.

{«backgroundColor»:»серый»,»content»:»\u003C\/p\u003E\n\n\u003Ch4\u003EУровни обрезки\u003C\/h4\u003E\n\n\u003Cp\u003EВ дополнение к стилям кузова , производитель автомобилей может предложить несколько вариантов отделки для данной модели. Уровни отделки салона зависят от оборудования и стиля конкретного автомобиля.\u003C\/p\u003E\n\n\u003Cp\u003EНапример, Honda Civic седан 2018 года имеет шесть различных параметров уровня отделки: \ u003C\/p\u003E\n\n\u003Cp\u003E\u003Cdiv class=\»ShortcodeList—root\»\u003E\n\n \u003Cdiv class=\»ShortcodeList— content ShortcodeList—content-margin\»\u003E\n \u003Cdiv class=\»ShortcodeList—column\»\u003E\n \u003Cul class=\»ListUnordered—root ListUnordered—bullet\»\u003E\n \ u003Cli class=\»ListUnordered—list-item\»\u003E\n LX\n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n EX\n \u003C\/li\u003E\n \u003C\/ul\u003E\n \u003C\/div\u003E\n \u003Cdiv class=\»ShortcodeList—column\»\u003E\n \ u003Cul class=\»ListUnordered—root ListUnordered—bullet\»\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n EX-T\n \u003C\/li\u003E\ n \u003Cli class=\»ListUnordered—list-item\»\u003E\n EX-L\n \u003C\/li\u003E\n \u003C\/ul\u003E\n \u003C\/div\u003E\ n \u003Cdiv class=\»ShortcodeList—column\»\u003E\n \u003Cul class=\»ListUnordered—root ListUnordered—bullet\»\u003E\n \u003Cli class=\»ListUnordered—list-item\ «\u003E\n Si\n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n Touring\n \u003C\/li\u003E\n \u003C\ /ul\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\n\u003C\/p\u003E\n\n\u003Cp\u003ECommon уровни отделки салона:\u003C\/p\u003E\n\n\u003Cp\u003E\u003Cdiv class=\»ShortcodeList—root\»\u003E\n\n \u003Cdiv class=\»ShortcodeList—content\»\ u003E\n \u003Cdiv class=\»ShortcodeList—column\»\u003E\n \u003Cul class=\» ListUnordered—root ListUnordered—bullet\»\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n \u003Cstrong\u003EStandard:\u003C\/strong\u003E без обновлений. \n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n \u003Cstrong\u003ESport:\u003C\/strong\u003E повышена производительность и управляемость двигателя.\n \ u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n \u003Cstrong\u003ELuxury:\u003C\/strong\u003E модернизированный интерьер и более плавная подвеска.\n \u003C\/ li\u003E\n\u003C\/ul\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\n\u003C\/p\u003E \n\n\u003Cp\u003E\u003Cdiv class=\»ShortcodeBorder—root ShortcodeBorder—with-padding\»\u003E\u003C\/p\u003E\n\n\u003Cp\u003EНекоторые транспортные средства имеют буквенно-цифровые соглашения об именах, которые могут затрудняют определение разницы между названием модели и комплектацией автомобиля.BMW, Mercedes и Lexus практикуют эти соглашения об именах. p\u003E\n\n\u003Cp\u003EНапример, рассмотрим BMW 540i 2018 года. В «540i» первая цифра указывает на то, что модель относится к 5-й серии, а 40i указывает на уровень отделки салона. \n\u003C\/div\u003E\n»,»padding»:»двойной»}

\n \u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n \u003Cstrong\u003ESport:\u003C\/strong\u003E повышена производительность и управляемость двигателя.\n \ u003C\/li\u003E\n \u003Cli class=\»ListUnordered—list-item\»\u003E\n \u003Cstrong\u003ELuxury:\u003C\/strong\u003E модернизированный интерьер и более плавная подвеска.\n \u003C\/ li\u003E\n\u003C\/ul\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\u003C\/div\u003E\n\n\u003C\/p\u003E \n\n\u003Cp\u003E\u003Cdiv class=\»ShortcodeBorder—root ShortcodeBorder—with-padding\»\u003E\u003C\/p\u003E\n\n\u003Cp\u003EНекоторые транспортные средства имеют буквенно-цифровые соглашения об именах, которые могут затрудняют определение разницы между названием модели и комплектацией автомобиля.BMW, Mercedes и Lexus практикуют эти соглашения об именах. p\u003E\n\n\u003Cp\u003EНапример, рассмотрим BMW 540i 2018 года. В «540i» первая цифра указывает на то, что модель относится к 5-й серии, а 40i указывает на уровень отделки салона. \n\u003C\/div\u003E\n»,»padding»:»двойной»}

Модельный год

Модельный год автомобиля является одним из основных способов дифференциации автомобилей одной марки и модели. Однако год выпуска автомобиля не обязательно совпадает с годом его выпуска. Важно отметить, что стоимость автострахования меняется с возрастом автомобиля.

Однако год выпуска автомобиля не обязательно совпадает с годом его выпуска. Важно отметить, что стоимость автострахования меняется с возрастом автомобиля.

Обычно вы можете приобрести автомобиль определенного модельного года за несколько месяцев до фактического начала календарного года. Например, Honda Civic 2018 года была доступна для покупки с конца лета 2017 года.

{«backgroundColor»:»серый»,»content»:»\u003C\/p\u003E\n\n\u003Ch4\u003EМодельный год\u003C\/h4\u003E\n\n\u003Cp\u003EМодельный год Автомобиль является одним из основных способов дифференциации автомобилей одной марки и модели.Однако год выпуска автомобиля не обязательно совпадает с годом его выпуска. Важно отметить, что \u003Cspan\u003E\u003Ca class=\»ShortcodeLink—root ShortcodeLink—black\» title=\»Как стоимость автострахования меняется с возрастом автомобиля\» href=\»https:\ //www.valuepenguin.com\/how-cost-of-car-insurance-changes-with-age-of-car\»\u003Стоимость автострахования меняется с возрастом автомобиля\u003C\/a\u003E \u003C\/span\u003E. \u003C\/p\u003E\n\n\u003Cp\u003EКак правило, вы можете приобрести автомобиль для данного модельного года за несколько месяцев до фактического начала календарного года.Например, Honda Civic 2018 года была доступна для покупки с конца лета 2017 года.\n»,»padding»:»double»}

\u003C\/p\u003E\n\n\u003Cp\u003EКак правило, вы можете приобрести автомобиль для данного модельного года за несколько месяцев до фактического начала календарного года.Например, Honda Civic 2018 года была доступна для покупки с конца лета 2017 года.\n»,»padding»:»double»}

Как узнать марку и модель автомобиля?

Марка, модель и комплектация автомобиля часто обозначаются значками, эмблемами или наклейками, расположенными на задней части автомобиля.

Это самый простой способ определить марку и модель вашего автомобиля. Если у вас возникли проблемы с определением марки или модели вашего автомобиля путем осмотра автомобиля снаружи, вы можете найти его в свидетельстве о регистрации автомобиля или в руководстве по эксплуатации.

Вы можете использовать свой идентификационный номер автомобиля (VIN), чтобы найти информацию о своем автомобиле, такую как характеристики оборудования, модельный год и даже завод, на котором он был изготовлен. Найдите свой VIN на приборной панели со стороны водителя.

- С 1981 модельного года они были 17-значными.

- Затем вы можете использовать инструмент отслеживания VIN для поиска информации о вашем автомобиле.

Различия между марками автомобилей одного производителя

У производителей может быть несколько разных марок — или марок — автомобилей, которые они производят.Toyota Motor Corp., например, имеет несколько различных марок автомобилей, включая Toyota, Scion и Lexus.

Когда вас спросят о марке вашего автомобиля, вы должны указать марку автомобиля.

Таким образом, хотя ваш Scion может быть произведен Toyota Motor Corp., было бы неверным сказать, что это Toyota.

Автомобильные компании иногда имеют разные бренды, потому что они купили или объединились с другими производителями автомобилей. Например, General Motors Corp.с годами приобрела Chevrolet, Buick и Cadillac. Все они когда-то были автономными производителями автомобилей.

Все они когда-то были автономными производителями автомобилей.

Производители также могут создавать отдельные бренды для разных рынков. Например, Toyota Motor Corp. создала Lexus, чтобы сосредоточиться на рынке роскошных автомобилей.

Когда марка и модель вашего автомобиля имеют значение?

Модель транспортного средства влияет на стоимость вашего автомобиля, поэтому вам следует это знать, если вы планируете продать свой автомобиль или купить новый.

Автомобили одной марки с одним и тем же типом кузова могут иметь совершенно разную стоимость, поэтому просто знать, что у вас есть седан Toyota или вы ищете его, недостаточно.

Например, ниже мы указываем рекомендованную производителем розничную цену на два седана Toyota 2018 года выпуска.

Помимо модели, на стоимость автомобиля влияет тип кузова и комплектация. Рекомендованная производителем розничная цена (MSRP) автомобилей одной и той же марки и модели может отличаться на тысячи долларов в зависимости от типа кузова и уровня отделки салона.

Как вы можете видеть ниже, Honda Civics с одинаковыми уровнями отделки салона могут отличаться на 1950 долларов в зависимости от типа кузова. Кроме того, Civic с одинаковым типом кузова, но разными уровнями отделки салона, различались на целых 8600 долларов.

| 2018 Honda Civic LX | SEDAN | $ 18 840104 | $ 1,6840104 | $ 1,688 | $ 1,688 |

| 2018 Honda Civic LX | 20050 | 1 727 | |||

| 2018 Honda Civic EX | SEDAN | 21,240 | 1,727 | ||

| 2018 Honda Civic ex | Hatchbob | 23,150 | 1,762 | ||

| 2018 Honda Civic Touring | Sedan | 26 700 | |||

| 2018 Honda Civic Sport Touring | Hatchback | 28 650 | 1 850 |

Как марка автомобиля влияет на стоимость автострахования?

Марка и модель вашего автомобиля также влияют на тарифы автострахования. Отчасти это связано с тем, что тарифы на комплексное покрытие и страховое покрытие основаны на стоимости вашего автомобиля.

Отчасти это связано с тем, что тарифы на комплексное покрытие и страховое покрытие основаны на стоимости вашего автомобиля.

Ниже мы приводим среднегодовые ставки страховых расходов по маркам автомобилей, ранжированные от самых дешевых до самых дорогих.

| 1 | Хонда | $ 2736 | ||

| 2 | GMC | $ 2785 | ||

| 3 | Chrysler | $ 2842 | ||

| 4 | Шевроле | $ 2890 | ||

| 5 | KIA | $ 2,907 | $ 2,907 | |

| Toyota | $ 2913 | $ 2913 | 7 | $ 2 998|

| 8 | Dodge | $ 3,006 | ||

| 9 | Ford | $ 3,036 | ||

| 10 | Volkswagen | $ 3,109 | $ 3,109 | |

| 11 | Nissan | $ 3,153 | ||

| 12 | Jeep | $ 3,347 |

- При установлении премий страховщики также учитывают, как часто водители с моделью и типом кузова вашего автомобиля подают заявления о страховании ответственности.

- Чем больше претензий подается к конкретному автомобилю, тем более рискованным он представляется в глазах страховщика.

- Ваш страховщик также посмотрит, насколько безопасен ваш автомобиль для вас и ваших пассажиров. Дополнительные функции безопасности обычно снижают страховые взносы.

Быстрые и роскошные автомобили, которые, вероятно, будут иметь более высокий уровень требований об ответственности, такие как Chevrolet Corvette, часто будут стоить дороже, чем скромные автомобили с более низким уровнем требований об ответственности, такие как Chevrolet Malibu.

{«backgroundColor»:»ice»,»content»:»\u003C\/p\u003E\n\n\u003Cp\u003EБыстрые и яркие автомобили, которые, вероятно, будут иметь более высокий уровень требований об ответственности, например, \u003Cspan\ u003E\u003Ca class=\»ShortcodeLink—root ShortcodeLink—black\» title=\»Сколько стоит застраховать Chevrolet Corvette\» href=\»https:\/\/www. valuepenguin.com\/ corvette-car-insurance \»\u003EChevrolet Corvette\u003C\/a\u003E\u003C\/span\u003E, часто будет стоить дороже, чем покрытие скромных автомобилей с более низким уровнем ответственности, таких как Chevrolet Malibu.\n»,»padding»:»двойной»}

valuepenguin.com\/ corvette-car-insurance \»\u003EChevrolet Corvette\u003C\/a\u003E\u003C\/span\u003E, часто будет стоить дороже, чем покрытие скромных автомобилей с более низким уровнем ответственности, таких как Chevrolet Malibu.\n»,»padding»:»двойной»}

Методология

Мы собрали цитаты из State Farm для 40-летнего мужчины с чистым водительским стажем, проживающего в Нью-Йорке. Полис включал скидки на антиблокировочную систему тормозов, противоугонную сигнализацию и дневные ходовые огни.

У него были следующие пределы покрытия:

- 50 000 долларов США на человека и 100 000 долларов США за несчастный случай за телесные повреждения

- $50 000 ответственности за материальный ущерб

- Комплексный (со стеклом) и столкновение с франшизами в размере 1000 долларов США.

Одеяла для защиты от эрозии – одобренные/сертифицированные продукты

Одеяла для защиты от эрозии

Книга стандартных спецификаций 2018 г. , Спецификация 3885

, Спецификация 3885

Категория 0

ASTM D 4329 Цикл A — 50 часов.0%-25%*

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| Curlex NetFree | Американ Эксельсиор Ко. | 651-783-6320 | 6-2018 |

Категория 3P-солома

ASTM D 4329 Цикл A — 50 часов. 0%-65%*

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| КЭП-С2 | Канзас Эрозия | 919-480-5616 | 6-2018 |

| ЭКС-2 | Противоэрозионные покрытия Восточного побережья | 800-582-4005 | 4-2018 |

| ЭГ-2сРД | Эро-защита | 651-917-0939 | 3-2018 |

| С32 УВД | противоэрозионное покрытие. ком ком | 360-910-4800 | 4-2018 |

| SFP-2sRD (Маг 500) | Продукты соломенной фермы | 612-723-5409 | 7-2018 |

| SS-S2 | Silt Sock Inc. | 320-333-6485 | 4-2018 |

| Эронет S150 | Тенсар Североамериканский Зеленый | 800-772-2040 | 5-2018 |

| Excel SS-2 | Вестерн Эксельсиор | 866-540-9810 | 5-2018 |

| С2000 | Enviroscape ЕСМ | 419-278-2000 | 11-2018 |

| С2000Д | Enviroscape ЕСМ | 419-278-2000 | 11-2018 |

Категория 3N-солома

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| KEP-S2 Натуральный | Канзас Эрозия | 919-480-5616 | 6-2018 |

| AEC Premier Straw, Dbl Net, FibreNet | Американ Эксельсиор Ко. | 651-783-6320 | 6-2018 |

| ЭКС-2Б | Противоэрозионные покрытия Восточного побережья | 800-582-4005 | 4-2018 |

| ЭГ-2с НН | Эро-защита | 651-917-0939 | 3-2018 |

| СФП-2сБД | Продукты соломенной фермы | 612-723-5409 | 7-2018 |

| СС-С2-БД | Силт Сок Инк. | 320-333-6485 | 4-2018 |

| С32 БД | эрозияcontrolblanket.com | 360-910-4800 | 4-2018 |

| Эронет S150BN | Тенсар Североамериканский Зеленый | 800-772-2040 | 5-2018 |

| Excel СС-2 Вся натуральная сетка | Вестерн Эксельсиор | 866-540-9810 | 5-2018 |

| С2000БН | Enviroscape ЕСМ | 419-278-2000 | 11-2018 |

Категория 3P-древесина

ASTM D 4329 Цикл A — 50 часов.

0%-65%*

0%-65%*| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| EG-2xRD | Эро-защита | 651-917-0939 | 3-2018 |

| Excel S-2 | Вестерн Эксельсиор | 866-540-9810 | 5-2018 |

Категория 3N-древесина

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| Curlex II FibreNet | Американ Эксельсиор Ко. | 651-783-6320 | 6-2018 |

| ЭГ-2x НН | Эро-защита | 651-917-0939 | 3-2018 |

| Excel S-2 Вся натуральная сетка | Вестерн Эксельсиор | 866-540-9810 | 5-2018 |

Категория 4P-солома/кокос

ASTM D 4329 Цикл A — 50 часов.

75%-120%*

75%-120%*| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| СС-СК2-МН | Silt Sock Inc. | 320-333-6485 | 4-2018 |

| ЭГ-2 п/к (MNCAT 4P) | Эро-защита | 651-917-0939 | 3-2018 |

| SC3000 | Enviroscape ЕСМ | 419-278-2000 | 11-2018 |

Категория 4N-солома/кокос

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| KEP-SC2 натуральный | Канзас Эрозия | 919-480-5616 | 7-2018 |

| AEC Premier Straw/Coconut FibreNet | Американ Эксельсиор Ко. | 651-783-6320 | 6-2018 |

| ECSC-2B | Противоэрозионные покрытия Восточного побережья | 800-582-4005 | 4-2018 |

| ЭГ-2с/к НН | Эро-защита | 651-917-0939 | 3-2018 |

| Эронет SC150BN | Тенсар Североамериканский Зеленый | 800-772-2040 | 5-2018 |

| Excel CS-3 Вся натуральная сетка | Вестерн Эксельсиор | 866-540-9810 | 5-2018 |

| СС-СК2-БД | Силт Сок Инк. | 320-333-6485 | 4-2018 |

| SC32 БД | эрозияcontrolblanket.com | 360-910-4800 | 4-2018 |

| SC3000BD | Enviroscape ЕСМ | 419-278-2000 | 11-2018 |

Категория 4P-древесина

ASTM D 4329 Цикл A — 50 часов.75%-120%*

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| EG-2x HD | Эро-защита | 651-917-0939 | 3-2018 |

Категория 4N-древесина

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| Curlex III FibreNet | Американ Эксельсиор Ко. | 651-783-6320 | 6-2018 |

| EG-2x NN HD | Эро-защита | 651-917-0939 | 3-2018 |

Категория 6

| Название марки/модели | Производитель | Контактная информация | Дата утверждения |

|---|---|---|---|

| EG-3xtreme-wood EG-3xtreme S/C | Эро-защита | 651-917-0939 | 3-2018 |

| Инфорсер Curlex (натуральный цвет) | Американ Эксельсиор Ко. | 800-777-7645 | 4-2018 |

| ЕСУС-3 | Противоэрозионные одеяла Восточного побережья, ООО | 800-582-4005 | 4-2018 |

| Вмакс SC250 | Тенсар Североамериканский Зеленый | 800-772-2040 | 4-2018 |

* Этот ASTM приблизительно соответствует срокам, указанным в Стандартных спецификациях.

Примечание. Сертификационное письмо от производителя сетки должно сопровождать одеяло при его использовании в проекте.

Примечание. Начиная с ноября 2018 г., представьте результаты испытаний в соответствии со стандартом NTPEP ASTM D 6460, допустимая нагрузка на сдвиг без вегетации для соответствия критериям напряжения сдвига MnDOT. Срок действия списка утвержденных продуктов будет зависеть от истечения этого тестового цикла.

Архив

CS231n Сверточные нейронные сети для визуального распознавания

Содержание:

Сверточные нейронные сети (CNN/ConvNets)

Сверточные нейронные сети очень похожи на обычные нейронные сети из предыдущей главы: они состоят из нейронов, которые имеют обучаемые веса и смещения. Каждый нейрон получает некоторые входные данные, выполняет скалярное произведение и, возможно, следует за ним с нелинейностью. Вся сеть по-прежнему выражает единую дифференцируемую функцию оценки: от необработанных пикселей изображения на одном конце до оценок класса на другом. И у них все еще есть функция потерь (например, SVM/Softmax) на последнем (полностью подключенном) слое, и все советы/рекомендации, которые мы разработали для изучения обычных нейронных сетей, по-прежнему применимы.

Каждый нейрон получает некоторые входные данные, выполняет скалярное произведение и, возможно, следует за ним с нелинейностью. Вся сеть по-прежнему выражает единую дифференцируемую функцию оценки: от необработанных пикселей изображения на одном конце до оценок класса на другом. И у них все еще есть функция потерь (например, SVM/Softmax) на последнем (полностью подключенном) слое, и все советы/рекомендации, которые мы разработали для изучения обычных нейронных сетей, по-прежнему применимы.

Так что же изменилось? Архитектуры ConvNet делают явное предположение, что входные данные являются изображениями, что позволяет нам кодировать определенные свойства в архитектуре.Затем они делают функцию прямой передачи более эффективной для реализации и значительно уменьшают количество параметров в сети.

Обзор архитектуры

Отзыв: Обычные нейронные сети. Как мы видели в предыдущей главе, нейронные сети получают входные данные (один вектор) и преобразуют их через серию из скрытых слоев . Каждый скрытый слой состоит из набора нейронов, где каждый нейрон полностью связан со всеми нейронами предыдущего слоя, а нейроны одного слоя функционируют совершенно независимо и не имеют общих связей.Последний полносвязный слой называется «выходным слоем» и в настройках классификации представляет баллы класса.

Каждый скрытый слой состоит из набора нейронов, где каждый нейрон полностью связан со всеми нейронами предыдущего слоя, а нейроны одного слоя функционируют совершенно независимо и не имеют общих связей.Последний полносвязный слой называется «выходным слоем» и в настройках классификации представляет баллы класса.

Обычные нейронные сети плохо масштабируются до полных изображений . В CIFAR-10 изображения имеют размер только 32x32x3 (32 ширины, 32 высоты, 3 цветовых канала), поэтому один полносвязный нейрон в первом скрытом слое обычной нейронной сети будет иметь 32 * 32 * 3 = 3072 веса. . Это количество все еще кажется управляемым, но ясно, что эта полностью связанная структура не масштабируется для больших изображений.Например, изображение более солидного размера, т.е. 200x200x3 приведет к нейронам, имеющим 200*200*3 = 120 000 весов. Более того, нам почти наверняка хотелось бы иметь несколько таких нейронов, чтобы параметры быстро складывались! Ясно, что такая полная связность расточительна, а огромное количество параметров быстро приведет к переоснащению.

3D объемы нейронов . Сверточные нейронные сети используют тот факт, что входные данные состоят из изображений, и они более разумно ограничивают архитектуру.В частности, в отличие от обычной нейронной сети, слои ConvNet имеют нейроны, расположенные в 3-х измерениях: ширина , высота, глубина . (Обратите внимание, что слово , глубина здесь относится к третьему измерению объема активации, а не к глубине полной нейронной сети, которая может относиться к общему количеству слоев в сети.) Например, входные изображения в ЦИФАР-10 является входным томом активаций, причем объем имеет размеры 32х32х3 (ширина, высота, глубина соответственно).Как мы вскоре увидим, нейроны в слое будут связаны только с небольшой областью слоя перед ним, а не со всеми нейронами полносвязным образом. Более того, окончательный выходной слой для CIFAR-10 будет иметь размеры 1x1x10, потому что к концу архитектуры ConvNet мы сократим полное изображение в единый вектор оценок классов, расположенных по измерению глубины. Вот визуализация:

Вот визуализация:

Слева: обычная трехслойная нейронная сеть. Справа: ConvNet размещает свои нейроны в трех измерениях (ширина, высота, глубина), как показано на одном из слоев.Каждый слой ConvNet преобразует трехмерный входной объем в трехмерный выходной объем активаций нейронов. В этом примере красный входной слой содержит изображение, поэтому его ширина и высота будут размерами изображения, а глубина будет равна 3 (красный, зеленый, синий каналы).

ConvNet состоит из слоев. У каждого слоя есть простой API: он преобразует входной 3D-объем в выходной 3D-объем с помощью некоторой дифференцируемой функции, которая может иметь или не иметь параметров.

Уровни, используемые для построения ConvNets

Как мы описали выше, простая ConvNet представляет собой последовательность слоев, и каждый слой ConvNet преобразует один объем активаций в другой с помощью дифференцируемой функции.Мы используем три основных типа слоев для построения архитектур ConvNet: Convolutional Layer , Pooling Layer и Fully-Connected Layer (точно так же, как это видно в обычных нейронных сетях). Мы объединим эти слои, чтобы сформировать полную архитектуру ConvNet .

Мы объединим эти слои, чтобы сформировать полную архитектуру ConvNet .

Пример архитектуры: обзор . Мы рассмотрим более подробно ниже, но простая ConvNet для классификации CIFAR-10 может иметь архитектуру [INPUT — CONV — RELU — POOL — FC].Подробнее:

- INPUT [32x32x3] будет содержать необработанные значения пикселей изображения, в данном случае изображение шириной 32, высотой 32 и с тремя цветовыми каналами R,G,B. Слой

- CONV будет вычислять выходные данные нейронов, которые подключены к локальным областям во входных данных, каждый из которых вычисляет скалярное произведение между их весами и небольшой областью, с которой они связаны во входном объеме. Это может привести к такому объему, как [32x32x12], если мы решили использовать 12 фильтров. Уровень

- RELU применит поэлементную функцию активации, такую как пороговое значение \(max(0,x)\) в нуле.Это оставляет размер тома без изменений ([32x32x12]). Слой

- POOL выполнит операцию понижения дискретизации по пространственным измерениям (ширина, высота), в результате чего получится объем, например [16x16x12].

Уровень

Уровень - FC (т. е. полносвязный) будет вычислять баллы класса, в результате чего получится объем размером [1x1x10], где каждое из 10 чисел соответствует баллу класса, например, среди 10 категорий CIFAR-10. Как и в случае с обычными нейронными сетями и как следует из названия, каждый нейрон в этом слое будет связан со всеми числами в предыдущем томе.

Таким образом, ConvNets трансформируют исходное изображение слой за слоем из исходных значений пикселей в окончательные оценки класса. Обратите внимание, что некоторые слои содержат параметры, а другие нет. В частности, слои CONV/FC выполняют преобразования, которые являются функцией не только активаций во входном объеме, но и параметров (весов и смещений нейронов). С другой стороны, слои RELU/POOL реализуют фиксированную функцию. Параметры в слоях CONV/FC будут обучаться с помощью градиентного спуска, чтобы оценки классов, вычисляемые ConvNet, соответствовали меткам в обучающем наборе для каждого изображения.

Итого:

- Архитектура ConvNet в простейшем случае представляет собой список слоев, которые преобразуют объем изображения в выходной объем (например, хранят оценки класса)

- Существует несколько различных типов слоев (например, CONV/FC/RELU/POOL, безусловно, самые популярные)

- Каждый слой принимает входной 3D-объем и преобразует его в выходной 3D-объем с помощью дифференцируемой функции

- Каждый уровень может иметь или не иметь параметры (например,CONV/FC можно, RELU/POOL нельзя)

- Каждый уровень может иметь или не иметь дополнительные гиперпараметры (например, CONV/FC/POOL имеют, RELU нет)

В начальном томе хранятся необработанные пиксели изображения (слева), а в последнем томе хранятся оценки класса (справа). Каждый объем активаций на пути обработки отображается в виде столбца. Поскольку визуализировать 3D-объемы сложно, мы располагаем срезы каждого объема рядами. Том последнего слоя содержит баллы для каждого класса, но здесь мы визуализируем только отсортированные 5 лучших баллов и печатаем метки каждого из них.Полная демо-версия показана в шапке нашего веб-сайта. Показанная здесь архитектура представляет собой крошечную сеть VGG, которую мы обсудим позже.

В начальном томе хранятся необработанные пиксели изображения (слева), а в последнем томе хранятся оценки класса (справа). Каждый объем активаций на пути обработки отображается в виде столбца. Поскольку визуализировать 3D-объемы сложно, мы располагаем срезы каждого объема рядами. Том последнего слоя содержит баллы для каждого класса, но здесь мы визуализируем только отсортированные 5 лучших баллов и печатаем метки каждого из них.Полная демо-версия показана в шапке нашего веб-сайта. Показанная здесь архитектура представляет собой крошечную сеть VGG, которую мы обсудим позже.Теперь мы опишем отдельные слои и детали их гиперпараметров и их связей.

Сверточный слой

Слой Conv является основным строительным блоком сверточной сети, который выполняет большую часть тяжелой вычислительной работы.

Обзор и интуиция без мозгов. Давайте сначала обсудим, что вычисляет слой CONV без аналогий с мозгом/нейроном.Параметры слоя CONV состоят из набора обучаемых фильтров. Каждый фильтр мал в пространстве (по ширине и высоте), но распространяется на всю глубину входного объема. Например, типичный фильтр на первом слое ConvNet может иметь размер 5x5x3 (т. е. 5 пикселей в ширину и высоту и 3, поскольку изображения имеют глубину 3, цветовые каналы). Во время прямого прохода мы перемещаем (точнее, сворачиваем) каждый фильтр по ширине и высоте входного объема и вычисляем скалярные произведения между элементами фильтра и входными данными в любой позиции.Когда мы перемещаем фильтр по ширине и высоте входного объема, мы создаем двумерную карту активации, которая дает ответы этого фильтра в каждой пространственной позиции. Интуитивно сеть будет изучать фильтры, которые активируются, когда они видят какой-либо тип визуальной функции, такой как край какой-либо ориентации или пятно определенного цвета на первом слое, или, в конечном итоге, целые соты или колесоподобные узоры на более высоких слоях сети. . Теперь у нас будет полный набор фильтров в каждом слое CONV (т.

Каждый фильтр мал в пространстве (по ширине и высоте), но распространяется на всю глубину входного объема. Например, типичный фильтр на первом слое ConvNet может иметь размер 5x5x3 (т. е. 5 пикселей в ширину и высоту и 3, поскольку изображения имеют глубину 3, цветовые каналы). Во время прямого прохода мы перемещаем (точнее, сворачиваем) каждый фильтр по ширине и высоте входного объема и вычисляем скалярные произведения между элементами фильтра и входными данными в любой позиции.Когда мы перемещаем фильтр по ширине и высоте входного объема, мы создаем двумерную карту активации, которая дает ответы этого фильтра в каждой пространственной позиции. Интуитивно сеть будет изучать фильтры, которые активируются, когда они видят какой-либо тип визуальной функции, такой как край какой-либо ориентации или пятно определенного цвета на первом слое, или, в конечном итоге, целые соты или колесоподобные узоры на более высоких слоях сети. . Теперь у нас будет полный набор фильтров в каждом слое CONV (т. г. 12 фильтров), и каждый из них создаст отдельную 2-мерную карту активации. Мы сложим эти карты активации по измерению глубины и создадим выходной объем.

г. 12 фильтров), и каждый из них создаст отдельную 2-мерную карту активации. Мы сложим эти карты активации по измерению глубины и создадим выходной объем.

Вид мозга . Если вам нравятся аналогии между мозгом и нейроном, то каждая запись в выходном 3D-объеме также может быть интерпретирована как вывод нейрона, который смотрит только на небольшую область на входе и разделяет параметры со всеми нейронами слева и справа. правильно пространственно (поскольку все эти числа являются результатом применения одного и того же фильтра).

Теперь мы обсудим детали соединений нейронов, их расположение в пространстве и схему совместного использования их параметров.

Локальное подключение. При работе с многомерными входными данными, такими как изображения, как мы видели выше, нецелесообразно соединять нейроны со всеми нейронами в предыдущем объеме. Вместо этого мы будем подключать каждый нейрон только к локальной области входного объема. Пространственная протяженность этой связи представляет собой гиперпараметр, называемый рецептивным полем нейрона (что эквивалентно размеру фильтра).Степень связности по оси глубины всегда равна глубине входного объема. Важно еще раз подчеркнуть эту асимметрию в том, как мы относимся к пространственным измерениям (ширине и высоте) и измерению глубины: связи локальны в двумерном пространстве (по ширине и высоте), но всегда полны по всей глубине входного объема. .

Пространственная протяженность этой связи представляет собой гиперпараметр, называемый рецептивным полем нейрона (что эквивалентно размеру фильтра).Степень связности по оси глубины всегда равна глубине входного объема. Важно еще раз подчеркнуть эту асимметрию в том, как мы относимся к пространственным измерениям (ширине и высоте) и измерению глубины: связи локальны в двумерном пространстве (по ширине и высоте), но всегда полны по всей глубине входного объема. .

Пример 1 . Например, предположим, что входной объем имеет размер [32x32x3] (например, изображение RGB CIFAR-10). Если рецептивное поле (или размер фильтра) составляет 5×5, то каждый нейрон в Conv Layer будет иметь веса для области [5x5x3] во входном объеме, всего 5*5*3 = 75 весов (и +1 параметр смещения).Обратите внимание, что экстент связности по оси глубины должен быть равен 3, так как это глубина входного объема.

Пример 2 . Предположим, входной том имеет размер [16x16x20]. Затем, используя пример рецептивного поля размером 3×3, каждый нейрон в Conv Layer теперь будет иметь в общей сложности 3 * 3 * 20 = 180 соединений с входным объемом. Обратите внимание, что, опять же, связность является локальной в 2D-пространстве (например, 3×3), но полной по входной глубине (20).

Затем, используя пример рецептивного поля размером 3×3, каждый нейрон в Conv Layer теперь будет иметь в общей сложности 3 * 3 * 20 = 180 соединений с входным объемом. Обратите внимание, что, опять же, связность является локальной в 2D-пространстве (например, 3×3), но полной по входной глубине (20).

Слева: Пример ввода красного цвета (напр.г. изображение CIFAR-10 размером 32x32x3) и примерный объем нейронов в первом сверточном слое. Каждый нейрон в сверточном слое пространственно связан только с локальной областью входного объема, но на всю глубину (т.е. со всеми цветовыми каналами). Обратите внимание, что по глубине расположено несколько нейронов (5 в этом примере), и все они смотрят на одну и ту же область во входных данных: линии, соединяющие этот столбец из 5 нейронов, не представляют веса (т. е. эти 5 нейронов не имеют одного и того же значения). веса, но они связаны с 5 разными фильтрами), они просто указывают на то, что эти нейроны подключены или смотрят на одно и то же рецептивное поле или область входного объема, т. е.е. они имеют одно и то же рецептивное поле, но разный вес. Справа: Нейроны из главы «Нейронная сеть» остались без изменений: они по-прежнему вычисляют скалярное произведение своих весов с входными данными, за которыми следует нелинейность, но их связность теперь ограничена локальной пространственной связью.

е.е. они имеют одно и то же рецептивное поле, но разный вес. Справа: Нейроны из главы «Нейронная сеть» остались без изменений: они по-прежнему вычисляют скалярное произведение своих весов с входными данными, за которыми следует нелинейность, но их связность теперь ограничена локальной пространственной связью.

Пространственное расположение . Мы объяснили связь каждого нейрона в Conv Layer с входным объемом, но еще не обсудили, сколько нейронов находится в выходном объеме или как они расположены.Три гиперпараметра управляют размером выходного тома: глубина , шаг и заполнение нулями . Мы обсудим это далее:

- Во-первых, глубина выходного объема является гиперпараметром: он соответствует количеству фильтров, которые мы хотели бы использовать, каждый из которых учится искать что-то другое во входных данных. Например, если первый сверточный слой принимает в качестве входных данных необработанное изображение, то разные нейроны по измерению глубины могут активироваться при наличии различных ориентированных краев или цветовых пятен.

Мы будем ссылаться на набор нейронов, которые смотрят на одну и ту же область входных данных, как на столбец глубины (некоторые люди также предпочитают термин волокно ).

Мы будем ссылаться на набор нейронов, которые смотрят на одну и ту же область входных данных, как на столбец глубины (некоторые люди также предпочитают термин волокно ). - Во-вторых, мы должны указать шаг , с которым мы перемещаем фильтр. Когда шаг равен 1, мы перемещаем фильтры по одному пикселю за раз. Когда шаг равен 2 (или редко 3 или более, хотя на практике это редкость), то фильтры прыгают на 2 пикселя за раз, когда мы перемещаем их. Это позволит производить меньшие объемы продукции в пространственном отношении.

- Как мы вскоре увидим, иногда бывает удобно дополнить входной объем нулями вокруг границы. Размер этого заполнения нулями является гиперпараметром. Хорошая особенность нулевого заполнения заключается в том, что оно позволяет нам контролировать пространственный размер выходных объемов (чаще всего, как мы скоро увидим, мы будем использовать его для точного сохранения пространственного размера входного объема, поэтому входная и выходная ширина и высота одинаковая).

Мы можем вычислить пространственный размер выходного объема как функцию размера входного объема (\(W\)), размера рецептивного поля нейронов конв. слоя (\(F\)), шага, с которым они применяются (\(S\)), и количество используемых нулевых отступов (\(P\)) на границе.Вы можете убедиться в том, что правильная формула для подсчета количества «подходящих» нейронов имеет вид \((W — F + 2P)/S + 1\). Например, для ввода 7×7 и фильтра 3×3 с шагом 1 и пэдом 0 мы получим вывод 5×5. С шагом 2 мы получим вывод 3×3. Давайте также посмотрим еще один графический пример:

. Иллюстрация пространственного расположения. В этом примере есть только одно пространственное измерение (ось X), один нейрон с размером рецептивного поля F = 3, размер входного сигнала W = 5 и заполнение нулями P = 1. Слева: Нейрон прошел через вход с шагом S = 1, давая результат размером (5 — 3 + 2)/1+1 = 5. Справа: Нейрон использует шаг S = 2, давая результат размера (5 — 3 + 2)/2+1 = 3. Обратите внимание, что шаг S = 3 нельзя использовать, так как он не будет аккуратно вписываться в объем. С точки зрения уравнения это можно определить, поскольку (5 — 3 + 2) = 4 не делится на 3.

Обратите внимание, что шаг S = 3 нельзя использовать, так как он не будет аккуратно вписываться в объем. С точки зрения уравнения это можно определить, поскольку (5 — 3 + 2) = 4 не делится на 3.

В этом примере веса нейронов равны [1,0,-1] (показаны справа), а его смещение равно нулю.Эти веса являются общими для всех желтых нейронов (см. совместное использование параметров ниже).

Использование заполнения нулями . В приведенном выше примере слева обратите внимание, что входное измерение было равно 5, а выходное измерение было равно: также 5. Это сработало, потому что наши рецептивные поля были 3, и мы использовали заполнение нулями 1. Если бы не использовалось заполнение нулями , то выходной объем имел бы пространственную размерность всего 3, потому что именно столько нейронов «поместилось бы» на исходном входе.В общем, установка нулевого заполнения в \(P = (F — 1)/2\), когда шаг равен \(S = 1\), гарантирует, что входной объем и выходной объем будут иметь одинаковый размер в пространстве. Таким образом очень часто используется заполнение нулями, и мы обсудим все причины, когда будем больше говорить об архитектуре ConvNet.

Таким образом очень часто используется заполнение нулями, и мы обсудим все причины, когда будем больше говорить об архитектуре ConvNet.

Ограничения по шагам . Обратите внимание еще раз, что гиперпараметры пространственного расположения имеют взаимные ограничения. Например, когда вход имеет размер \(W = 10\), не используется заполнение нулями \(P = 0\) и размер фильтра равен \(F = 3\), тогда было бы невозможно использовать шаг \(S = 2\), так как \((W — F + 2P)/S + 1 = (10 — 3 + 0) / 2 + 1 = 4.5\), т. е. не целое число, что указывает на то, что нейроны не «укладываются» аккуратно и симметрично по входным данным. Следовательно, эта настройка гиперпараметров считается недопустимой, и библиотека ConvNet может выдать исключение или дополнить нулями остальные, чтобы они соответствовали, или обрезать входные данные, чтобы они соответствовали, или что-то в этом роде. Как мы увидим в разделе архитектуры ConvNet, правильное определение размера ConvNet, чтобы все измерения «работали», может стать настоящей головной болью, которую значительно облегчит использование заполнения нулями и некоторых рекомендаций по проектированию.

Реальный пример . Крижевский и др. Архитектура, победившая в конкурсе ImageNet в 2012 году, принимала изображения размером [227x227x3]. На первом сверточном слое использовались нейроны с размером рецептивного поля \(F = 11\), шагом \(S = 4\) и без заполнения нулями \(P = 0\). Так как (227 — 11)/4 + 1 = 55 и поскольку слой Conv имел глубину \(K = 96\), выходной объем слоя Conv имел размер [55x55x96]. Каждый из 55*55*96 нейронов в этом объеме был связан с областью размером [11x11x3] во входном объеме.Более того, все 96 нейронов в каждом столбце глубины подключены к одной и той же области [11x11x3] входа, но, конечно, с разными весами. В качестве забавы, если вы читаете настоящую статью, в ней утверждается, что входные изображения были 224×224, что, безусловно, неверно, потому что (224 — 11)/4 + 1 явно не является целым числом. Это сбило с толку многих людей в истории ConvNets, и мало что известно о том, что произошло. Мое личное предположение состоит в том, что Алекс использовал заполнение нулями трех дополнительных пикселей, о которых он не упоминает в статье.

Совместное использование параметров. Схема совместного использования параметров используется в сверточных слоях для управления количеством параметров. Используя приведенный выше реальный пример, мы видим, что в первом Conv Layer 55 * 55 * 96 = 290 400 нейронов, и каждый имеет 11 * 11 * 3 = 363 веса и 1 смещение. Вместе это составляет 2

Оказывается, мы можем значительно сократить количество параметров, сделав одно разумное предположение: если один признак полезно вычислять в некоторой пространственной позиции (x, y), то его также полезно вычислять в другой позиции ( х2,у2).Другими словами, обозначив один двумерный срез глубины как срезов глубины (например, том размером [55x55x96] имеет 96 срезов глубины, каждый размером [55×55]), мы собираемся ограничить нейроны в каждом из них. срез глубины, чтобы использовать те же веса и смещение. С этой схемой совместного использования параметров первый Conv Layer в нашем примере теперь будет иметь только 96 уникальных наборов весов (по одному для каждого среза глубины), всего 96 * 11 * 11 * 3 = 34 848 уникальных весов или 34 944 параметра ( +96 смещений). Альтернативно, все 55*55 нейронов в каждом глубинном срезе теперь будут использовать одни и те же параметры.На практике во время обратного распространения каждый нейрон в объеме будет вычислять градиент для своих весов, но эти градиенты будут суммироваться по каждому срезу глубины и обновлять только один набор весов на срез.

С этой схемой совместного использования параметров первый Conv Layer в нашем примере теперь будет иметь только 96 уникальных наборов весов (по одному для каждого среза глубины), всего 96 * 11 * 11 * 3 = 34 848 уникальных весов или 34 944 параметра ( +96 смещений). Альтернативно, все 55*55 нейронов в каждом глубинном срезе теперь будут использовать одни и те же параметры.На практике во время обратного распространения каждый нейрон в объеме будет вычислять градиент для своих весов, но эти градиенты будут суммироваться по каждому срезу глубины и обновлять только один набор весов на срез.

Обратите внимание, что если все нейроны в одном срезе глубины используют один и тот же вектор веса, то прямой проход слоя CONV может быть вычислен в каждом срезе глубины как свертка весов нейрона с входным объемом (отсюда и название : сверточный слой).Вот почему наборы весов принято называть фильтром (или ядром ), который свернут с входными данными.

Примеры фильтров, изученных Крижевским и др. Каждый из 96 показанных здесь фильтров имеет размер [11x11x3], и каждый из них используется 55*55 нейронами в одном срезе глубины. Обратите внимание, что предположение о совместном использовании параметров относительно разумно: если обнаружение горизонтального края важно в каком-то месте изображения, оно должно быть интуитивно полезным и в каком-то другом месте из-за трансляционно-инвариантной структуры изображений.Поэтому нет необходимости заново учиться обнаруживать горизонтальный край в каждом из 55*55 различных мест выходного объема Conv-слоя.

Обратите внимание, что иногда предположение о совместном использовании параметров может не иметь смысла. Это особенно актуально, когда входные изображения в ConvNet имеют определенную центрированную структуру, где мы должны ожидать, например, что совершенно разные функции должны быть изучены на одной стороне изображения, чем на другой. Одним из практических примеров является случай, когда входными данными являются лица, расположенные по центру изображения. Вы можете ожидать, что различные особенности, характерные для глаз или волос, могут (и должны) изучаться в разных пространственных положениях. В этом случае принято ослаблять схему совместного использования параметров и вместо этого просто называть уровень Locally-Connected Layer .

Вы можете ожидать, что различные особенности, характерные для глаз или волос, могут (и должны) изучаться в разных пространственных положениях. В этом случае принято ослаблять схему совместного использования параметров и вместо этого просто называть уровень Locally-Connected Layer .

Примеры Numpy. Чтобы сделать обсуждение выше более конкретным, давайте выразим те же идеи, но в коде и на конкретном примере. Предположим, что входной объем представляет собой массив X numpy. Тогда:

- Столбец глубины (или волокно ) в позиции

(x,y)будет активациейX[x,y,:]. - Срез глубины или эквивалентная карта активации на глубине

dбудет активациямиX[:,:,d].

Пример слоя конверсии . Предположим, что входной объем X имеет форму X.shape: (11,11,4) . Предположим далее, что мы не используем заполнение нулями (\(P = 0\)), что размер фильтра равен \(F = 5\) и что шаг равен \(S = 2\). Таким образом, выходной объем будет иметь пространственный размер (11-5)/2+1 = 4, что дает объем с шириной и высотой 4.Карта активации в выходном томе (назовем ее

Таким образом, выходной объем будет иметь пространственный размер (11-5)/2+1 = 4, что дает объем с шириной и высотой 4.Карта активации в выходном томе (назовем ее V ) будет выглядеть следующим образом (в этом примере вычисляются только некоторые элементы):

-

V[0,0,0] = np.sum(X[:5,:5,:] * W0) + b0 -

V[1,0,0] = np.sum(X[2:7,:5,:] * W0) + b0 -

V[2,0,0] = np.sum(X[4:9,:5,:] * W0) + b0 -

V[3,0,0] = np.sum(X[6:11,:5,:] * W0) + b0

Помните, что в numpy операция * выше обозначает поэлементное умножение между массивами.Заметьте также, что весовой вектор W0 — это весовой вектор этого нейрона, а b0 — это смещение. Здесь предполагается, что W0 имеет форму W0.shape: (5,5,4) , поскольку размер фильтра равен 5, а глубина входного объема равна 4. Обратите внимание, что в каждой точке мы вычисляем скалярный продукт, как это было показано ранее в обычных нейронных сетях. Кроме того, мы видим, что используем тот же вес и смещение (из-за совместного использования параметров), и где размеры по ширине увеличиваются с шагом 2 (т.е. шаг). Чтобы построить вторую карту активации в выходном томе, у нас будет:

Кроме того, мы видим, что используем тот же вес и смещение (из-за совместного использования параметров), и где размеры по ширине увеличиваются с шагом 2 (т.е. шаг). Чтобы построить вторую карту активации в выходном томе, у нас будет:

-

V[0,0,1] = np.sum(X[:5,:5,:] * W1) + b1 -

V[1,0,1] = np.sum(X[2:7,:5,:] * W1) + b1 -

V[2,0,1] = np.sum(X[4:9,:5,:] * W1) + b1 -

V[3,0,1] = np.sum(X[6:11,:5,:] * W1) + b1 -

V[0,1,1] = np.sum(X[:5,2:7,:] * W1) + b1(пример прохождения по y) -

V[2,3,1] = np.sum(X[4:9,6:11,:] * W1) + b1(или по обоим)

, где мы видим, что мы индексируем второе измерение глубины в V (по индексу 1), потому что мы вычисляем вторую карту активации, и что теперь используется другой набор параметров ( W1 ). В приведенном выше примере мы для краткости опускаем некоторые другие операции, которые Conv Layer будет выполнять для заполнения других частей выходного массива V . Кроме того, вспомните, что эти карты активации часто следуют по элементам через функцию активации, такую как ReLU, но здесь это не показано.

Кроме того, вспомните, что эти карты активации часто следуют по элементам через функцию активации, такую как ReLU, но здесь это не показано.

Сводка . Подводя итог, Conv Layer:

- Принимает том размером \(W_1 \x H_1 \x D_1\)

- Требуется четыре гиперпараметра:

- Количество фильтров \(K\),

- их пространственная протяженность \(F\),

- шаг \(S\),

- количество заполнения нулями \(P\).

- Создает том размером \(W_2 \times H_2 \times D_2\), где:

- \(W_2 = (W_1 — F + 2P)/S + 1\)

- \(H_2 = (H_1 — F + 2P)/S + 1\) (т.е. ширина и высота вычисляются одинаково по симметрии)

- \(Д_2 = К\)

- При совместном использовании параметров он вводит \(F \cdot F \cdot D_1\) весов для каждого фильтра, всего \((F \cdot F \cdot D_1) \cdot K\) весов и \(K\) смещений .

- В выходном объеме \(d\)-й срез глубины (размером \(W_2 \times H_2\)) является результатом корректной свертки \(d\)-го фильтра над входным объемом с шагом \(S\), а затем со смещением на \(d\)-й уклон.

Общая настройка гиперпараметров: \(F = 3, S = 1, P = 1\). Однако существуют общие соглашения и эмпирические правила, которые мотивируют эти гиперпараметры. См. раздел архитектуры ConvNet ниже.

Демонстрация свертки . Ниже приведена работающая демонстрация слоя CONV. Поскольку 3D-объемы трудно визуализировать, все объемы (входной объем (синий), весовые объемы (красный), выходной объем (зеленый)) визуализируются с каждым срезом глубины, сложенным в строки.Входной объем имеет размер \(W_1 = 5, H_1 = 5, D_1 = 3\), а параметры слоя CONV: \(K = 2, F = 3, S = 2, P = 1\). То есть у нас есть два фильтра размера \(3 \times 3\), и они применяются с шагом 2. Следовательно, размер выходного объема имеет пространственный размер (5 — 3 + 2)/2 + 1 = 3 Кроме того, обратите внимание, что к входному объему применяется отступ \(P = 1\), что делает внешнюю границу входного объема нулевой. Визуализация ниже повторяет активацию вывода (зеленый) и показывает, что каждый элемент вычисляется путем поэлементного умножения выделенного ввода (синий) на фильтр (красный), суммирования и последующего смещения результата на смещение.

Реализация как умножение матриц . Обратите внимание, что операция свертки по существу выполняет скалярные произведения между фильтрами и локальными областями ввода. Обычный шаблон реализации слоя CONV состоит в том, чтобы воспользоваться этим фактом и сформулировать прямой проход сверточного слоя как одну большую матрицу, умноженную следующим образом:

- Локальные области входного изображения растягиваются в столбцы в ходе операции, обычно называемой im2col .Например, если входные данные имеют размер [227x227x3] и должны быть свернуты с фильтрами 11x11x3 на шаге 4, тогда мы возьмем [11x11x3] блоков пикселей во входных данных и растянем каждый блок в вектор-столбец размером 11*11*. 3 = 363. Повторение этого процесса на входе с шагом 4 дает (227-11)/4+1 = 55 местоположений как по ширине, так и по высоте, что приводит к выходной матрице

X_colиз im2col размером [363 x 3025], где каждый столбик представляет собой вытянутое рецептивное поле, а всего их 55*55 = 3025. Обратите внимание, что, поскольку рецептивные поля перекрываются, каждое число во входном объеме может дублироваться в нескольких отдельных столбцах.

Обратите внимание, что, поскольку рецептивные поля перекрываются, каждое число во входном объеме может дублироваться в нескольких отдельных столбцах. - Вес слоя CONV аналогичным образом растягивается в строки. Например, если есть 96 фильтров размером [11x11x3], это даст матрицу

W_rowразмера [96 x 363]. - Результат свертки теперь эквивалентен выполнению одной большой матрицы, умноженной на

np.dot(W_row, X_col), которая оценивает скалярное произведение между каждым фильтром и каждым местоположением восприимчивого поля.В нашем примере выход этой операции будет [96 x 3025], что даст результат скалярного произведения каждого фильтра в каждом месте. - Наконец, результат должен быть преобразован обратно в правильный выходной размер [55x55x96].

Недостатком этого подхода является то, что он может использовать много памяти, поскольку некоторые значения во входном томе реплицируются несколько раз в X_col . Однако преимущество заключается в том, что существует множество очень эффективных реализаций умножения матриц, которыми мы можем воспользоваться (например, в широко используемом API BLAS).Более того, ту же идею im2col можно повторно использовать для выполнения операции объединения, которую мы обсудим далее.

Однако преимущество заключается в том, что существует множество очень эффективных реализаций умножения матриц, которыми мы можем воспользоваться (например, в широко используемом API BLAS).Более того, ту же идею im2col можно повторно использовать для выполнения операции объединения, которую мы обсудим далее.

Обратное распространение. Обратный проход для операции свертки (как для данных, так и для весов) также является сверткой (но с пространственно-перевернутыми фильтрами). Это легко вывести в одномерном случае на игрушечном примере (пока не расширяемом).

1×1 свертка . Кроме того, в нескольких статьях используются свертки 1×1, впервые исследованные Network in Network.Некоторые люди сначала сбиты с толку, увидев извилины 1×1, особенно когда они исходят из фона обработки сигналов. Обычно сигналы являются двумерными, поэтому свертки 1×1 не имеют смысла (это просто точечное масштабирование). Однако в ConvNets это не так, потому что нужно помнить, что мы работаем с трехмерными объемами и что фильтры всегда распространяются на всю глубину входного объема. Например, если ввод [32x32x3], то выполнение сверток 1×1 будет эффективно выполнять 3-мерные скалярные произведения (поскольку глубина ввода составляет 3 канала).

Например, если ввод [32x32x3], то выполнение сверток 1×1 будет эффективно выполнять 3-мерные скалярные произведения (поскольку глубина ввода составляет 3 канала).