Н-нн в различных частях речи. (11 класс)

1. А14 н-нн в различных частях речи

Занятие элективного курса в 11классе

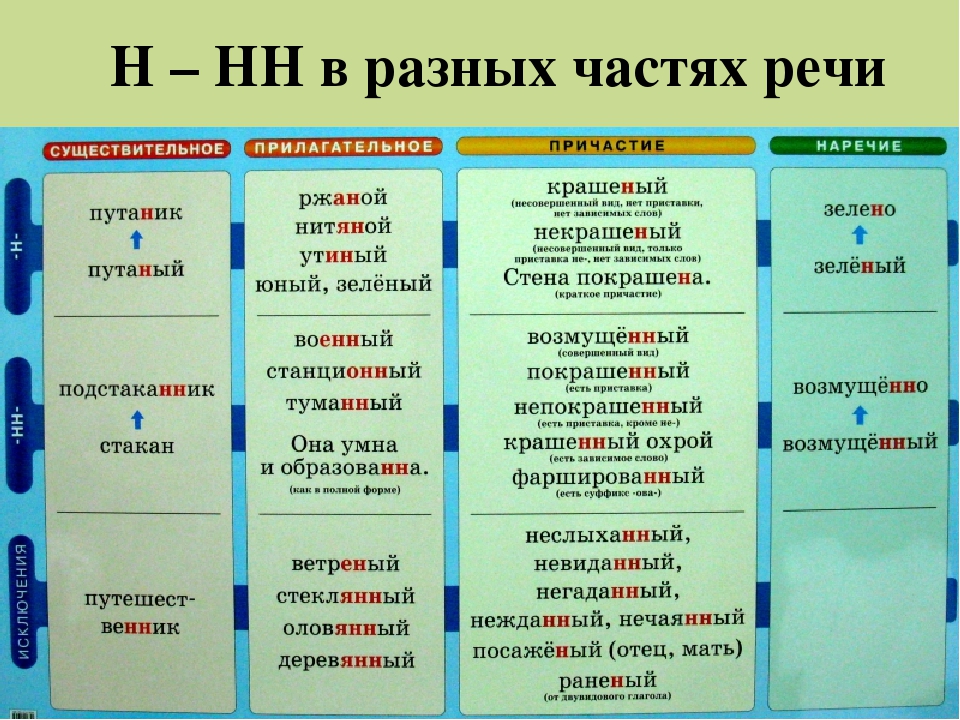

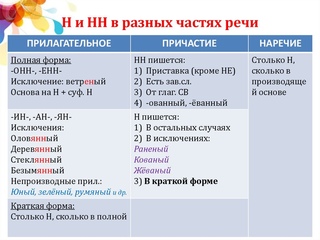

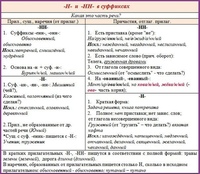

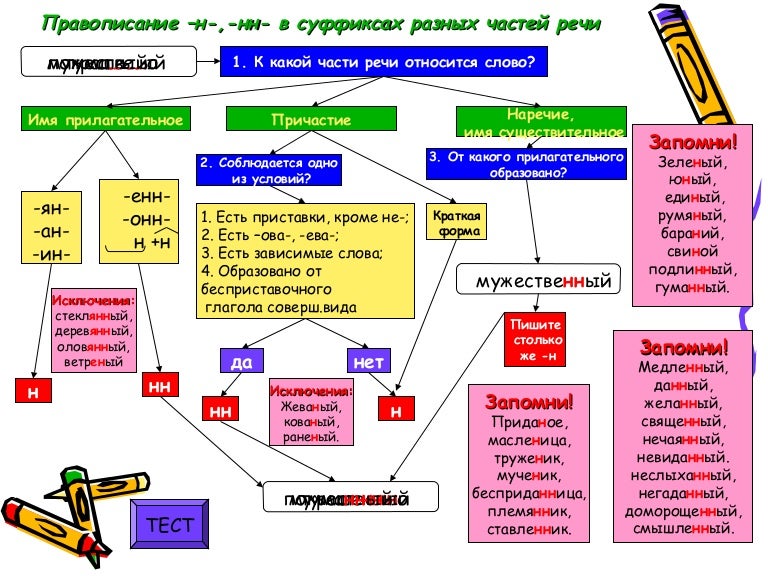

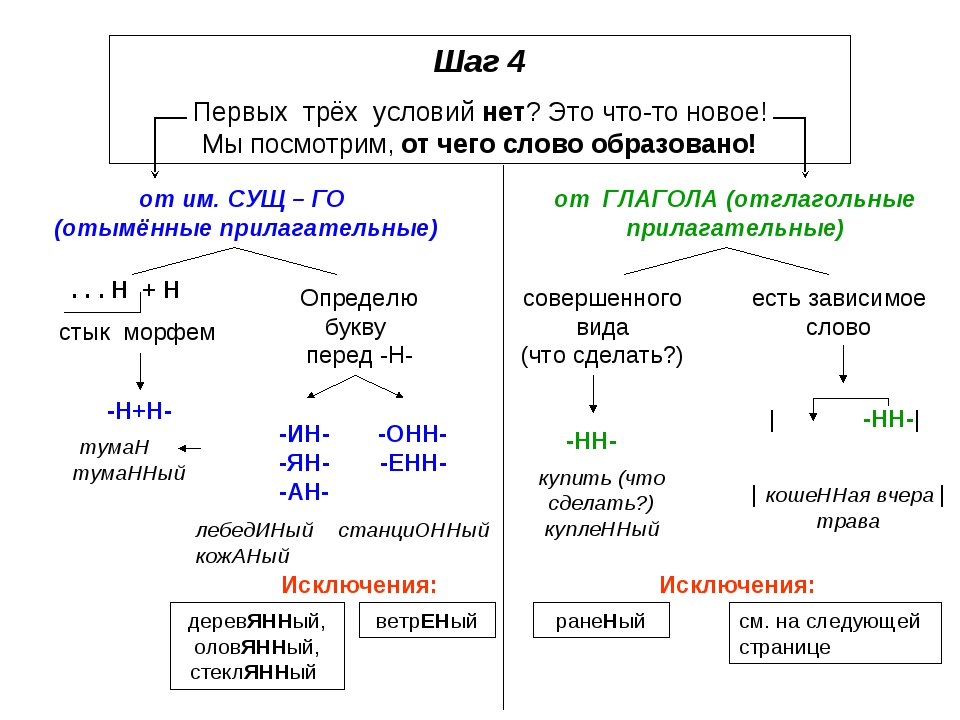

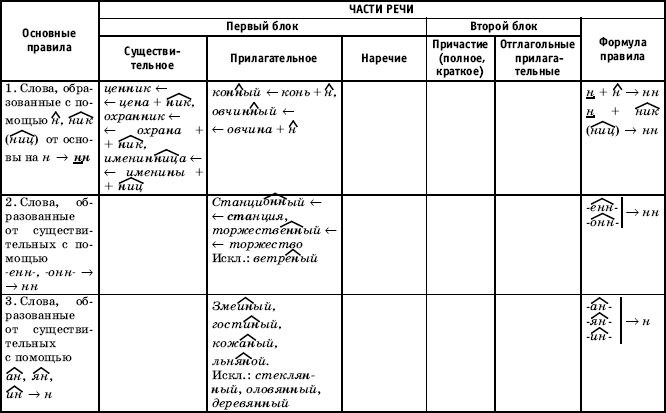

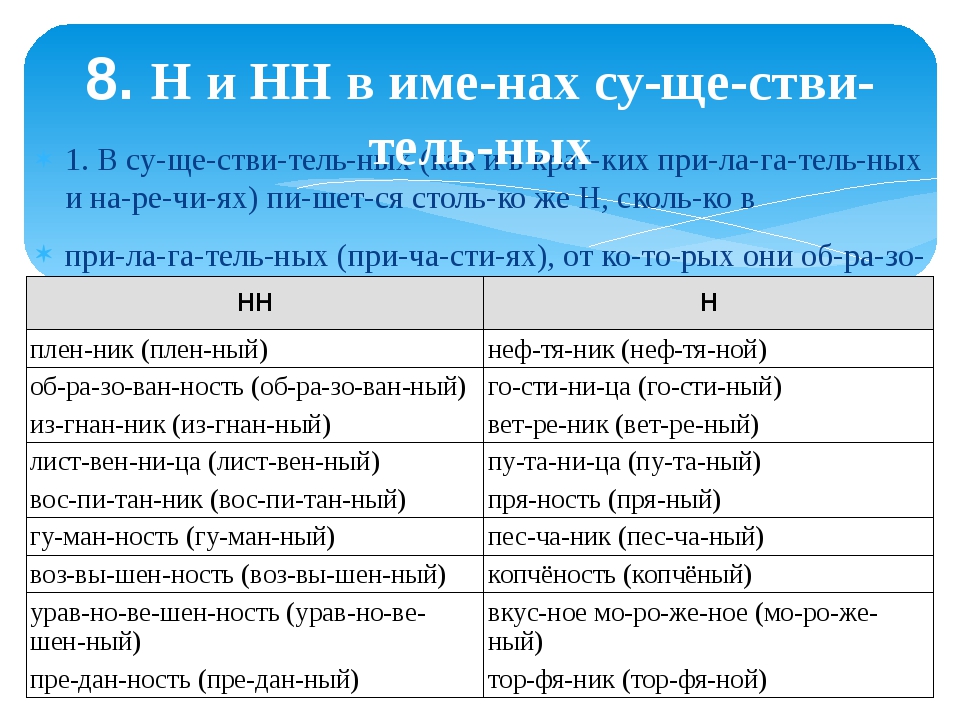

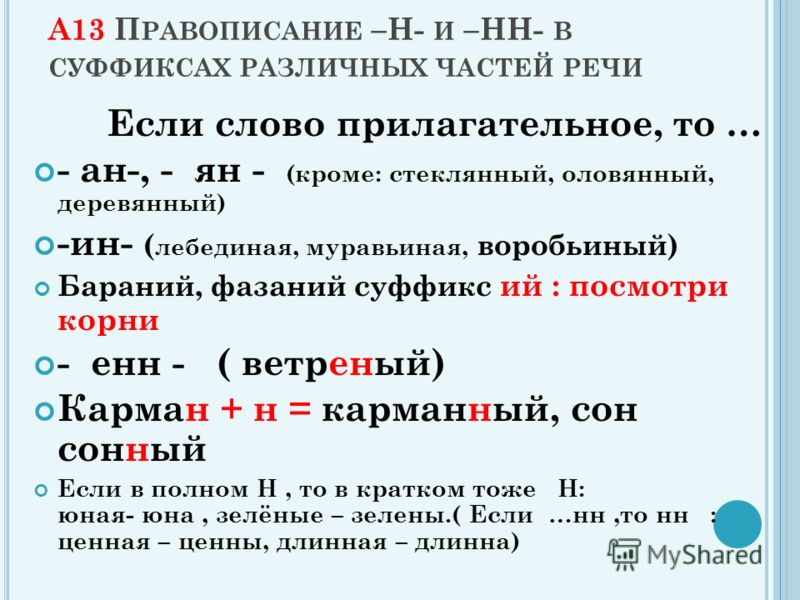

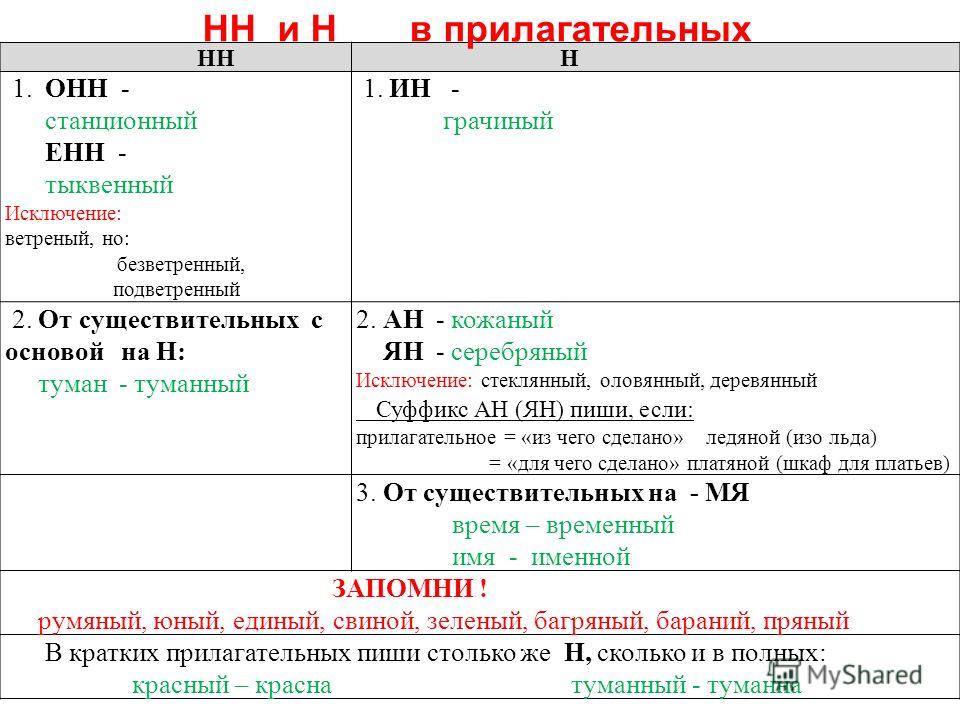

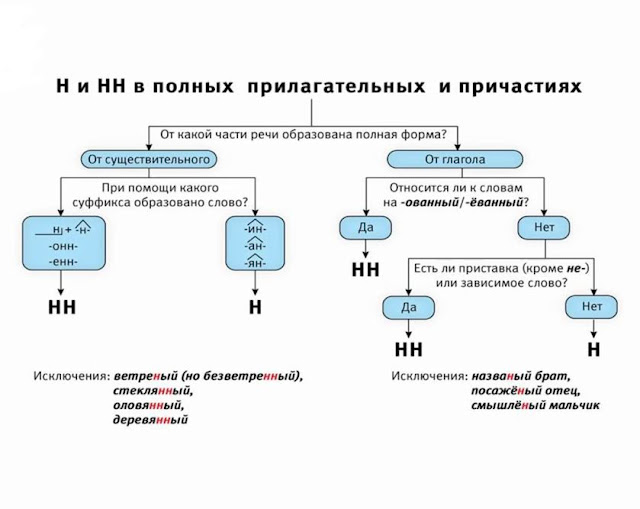

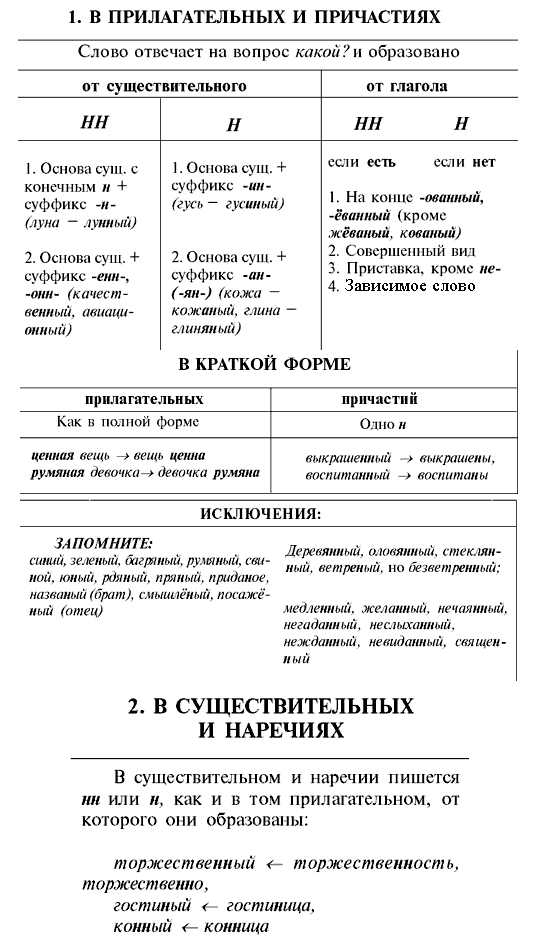

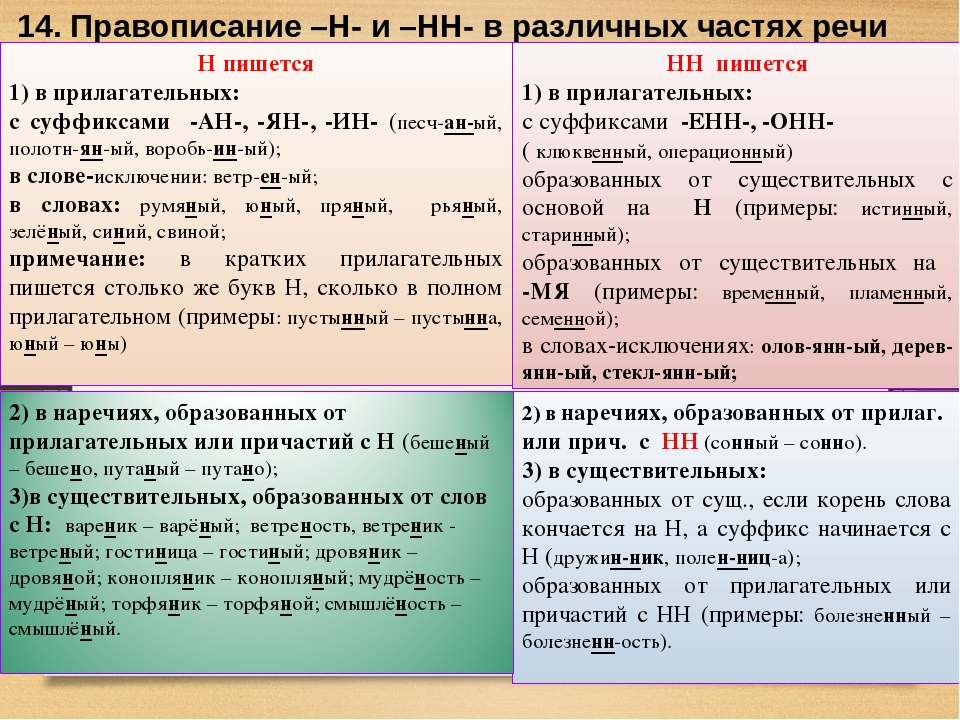

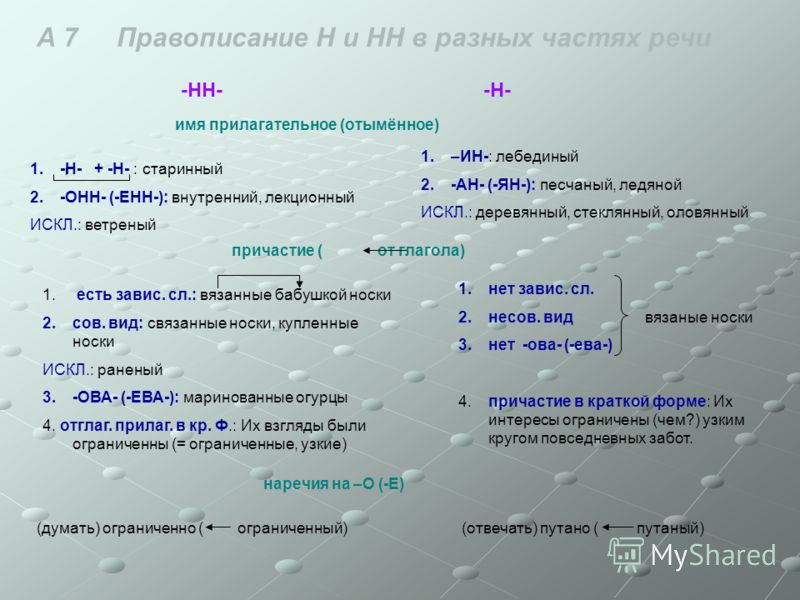

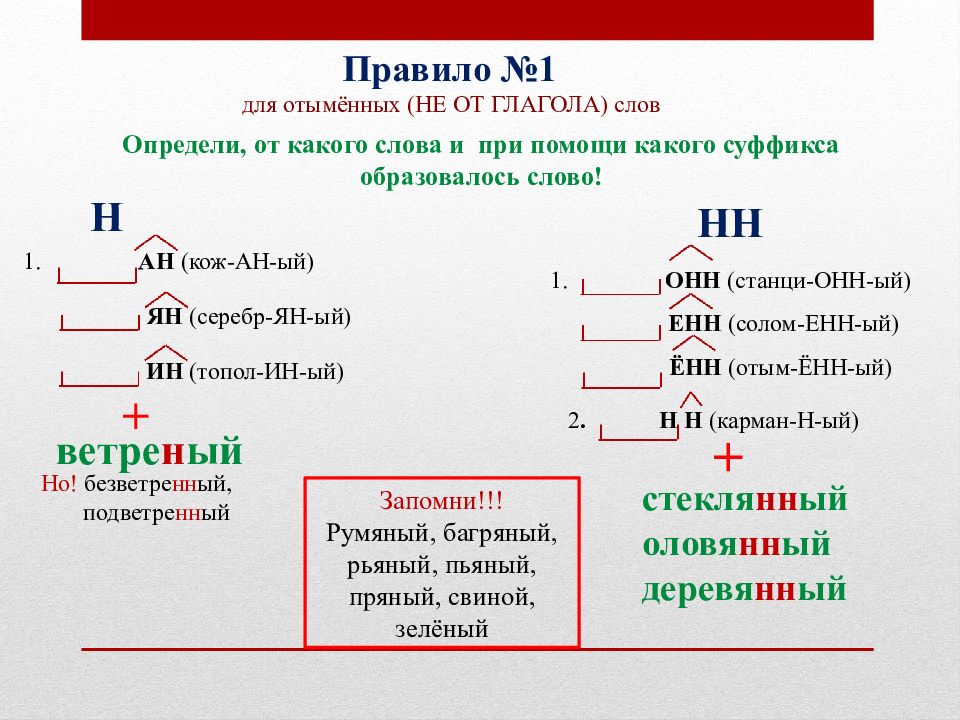

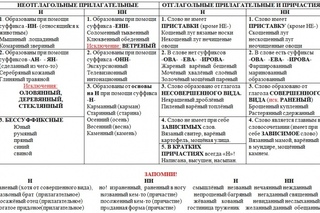

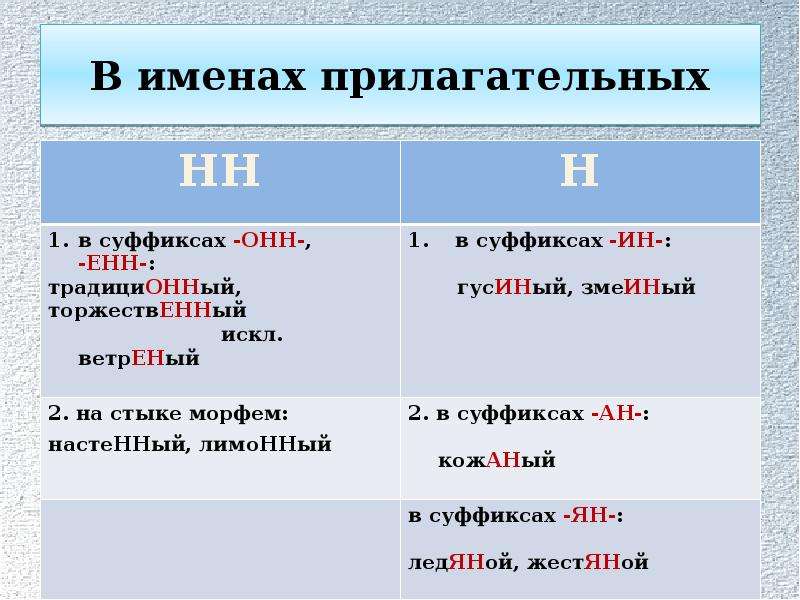

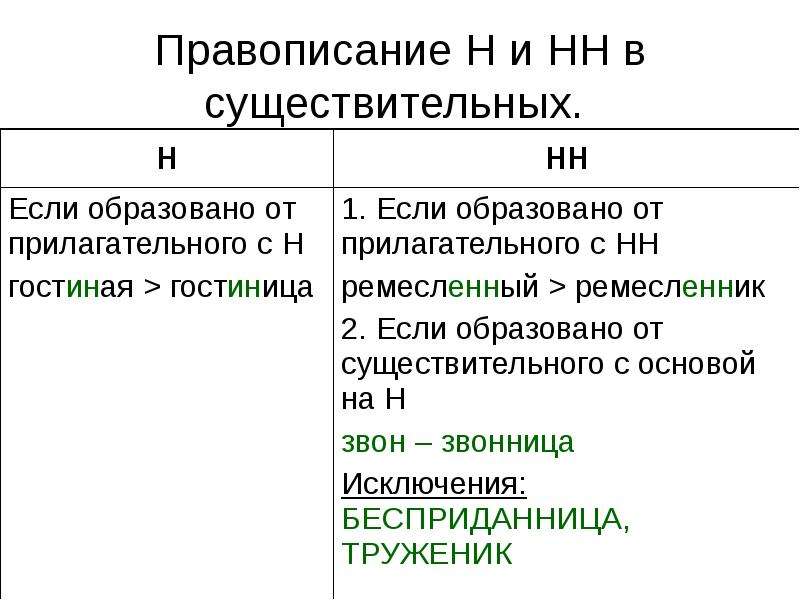

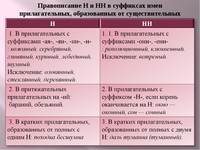

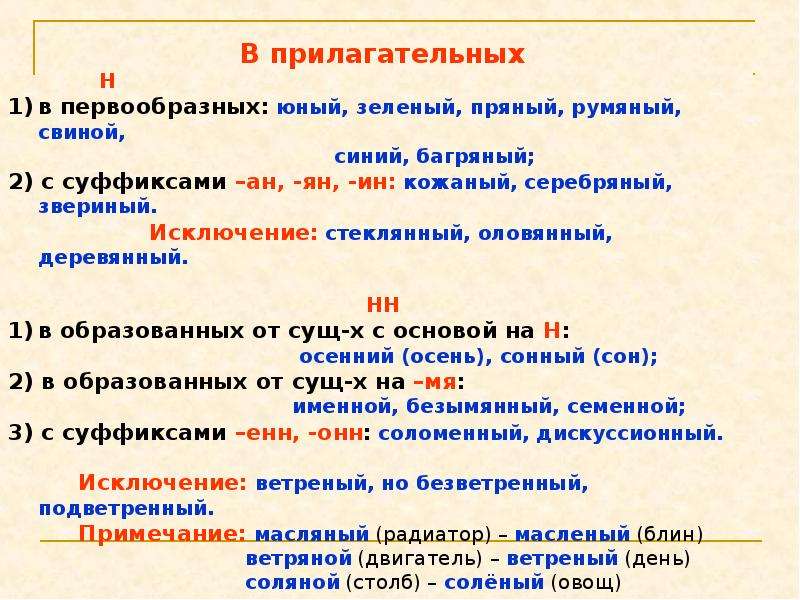

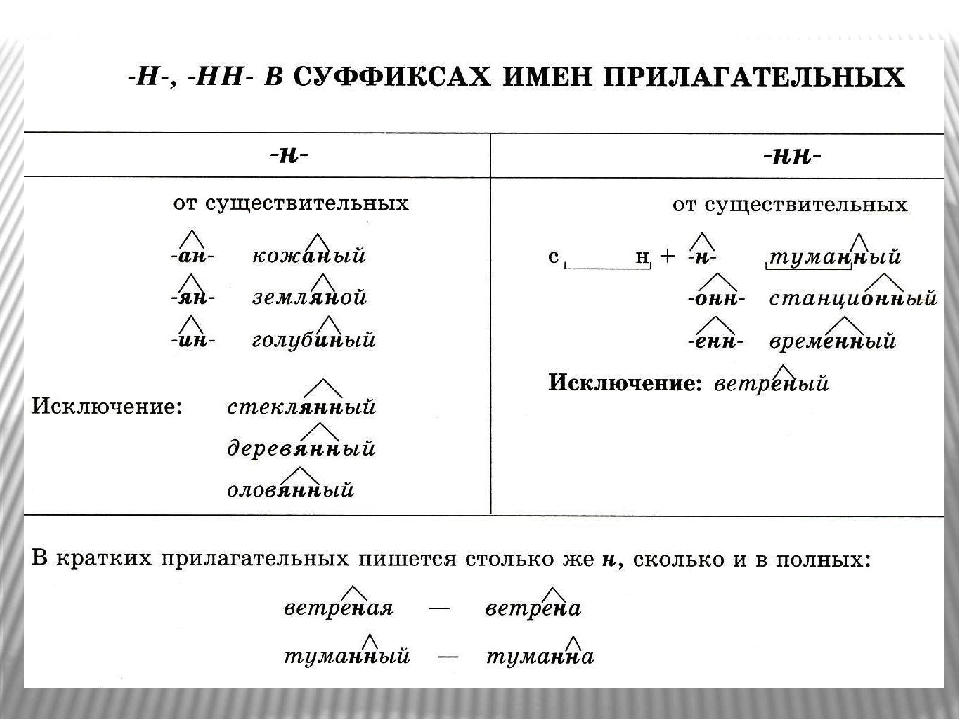

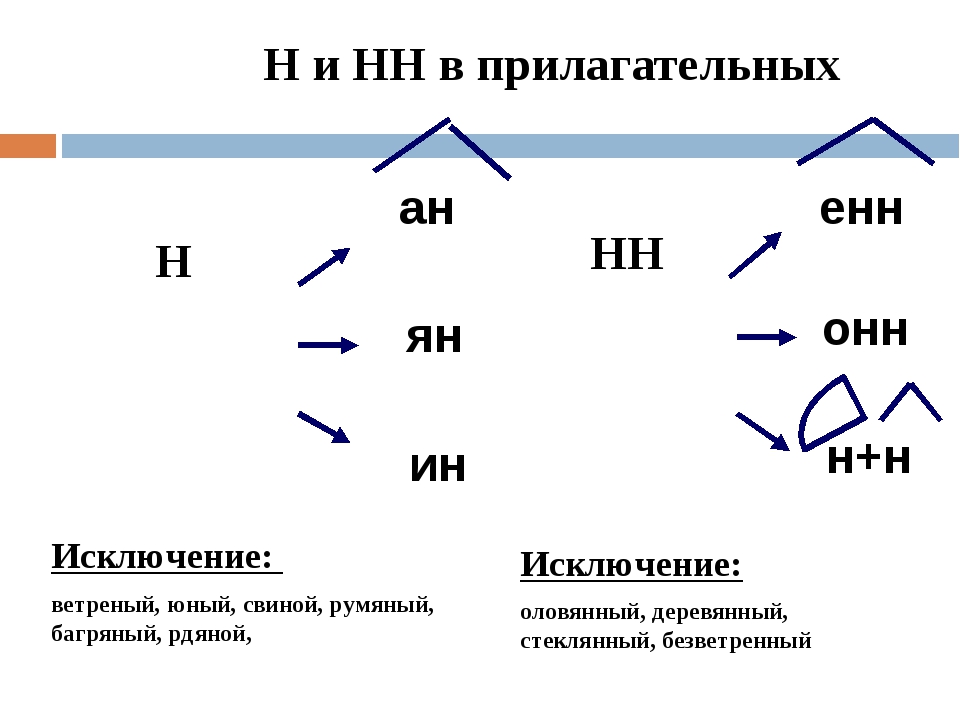

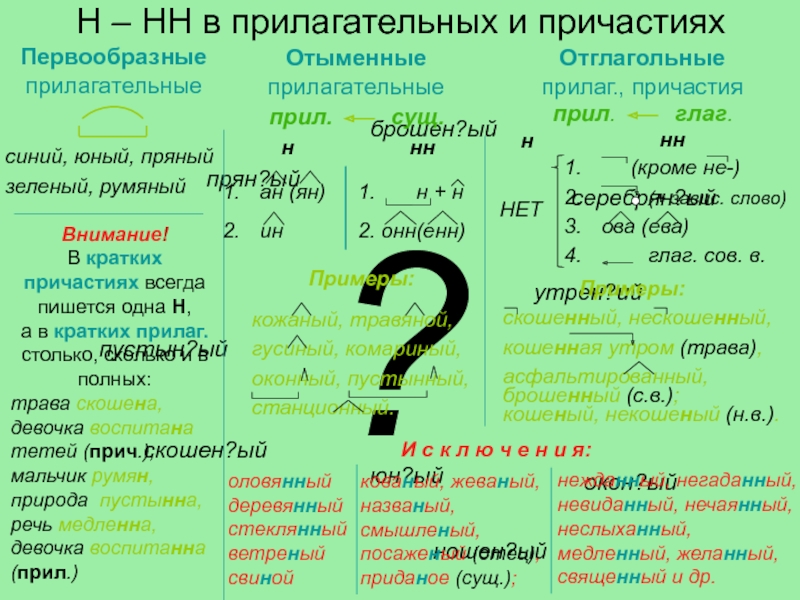

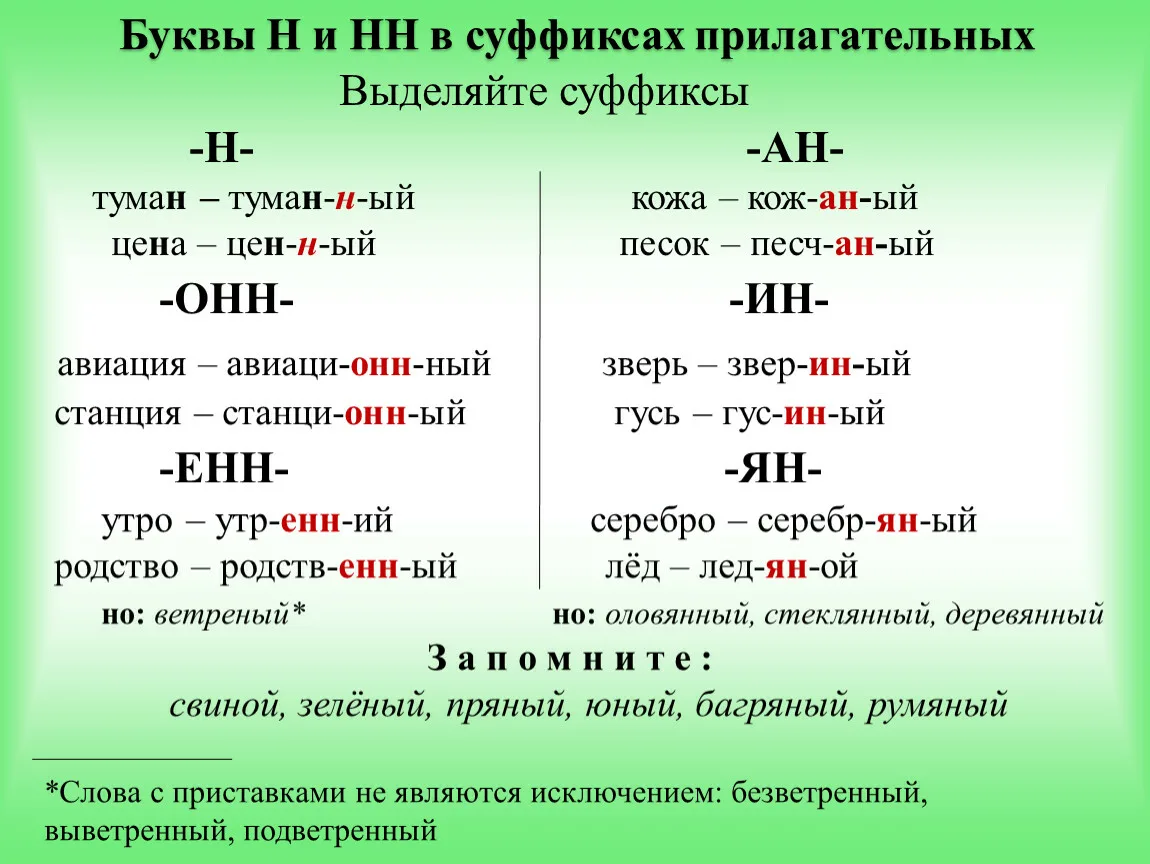

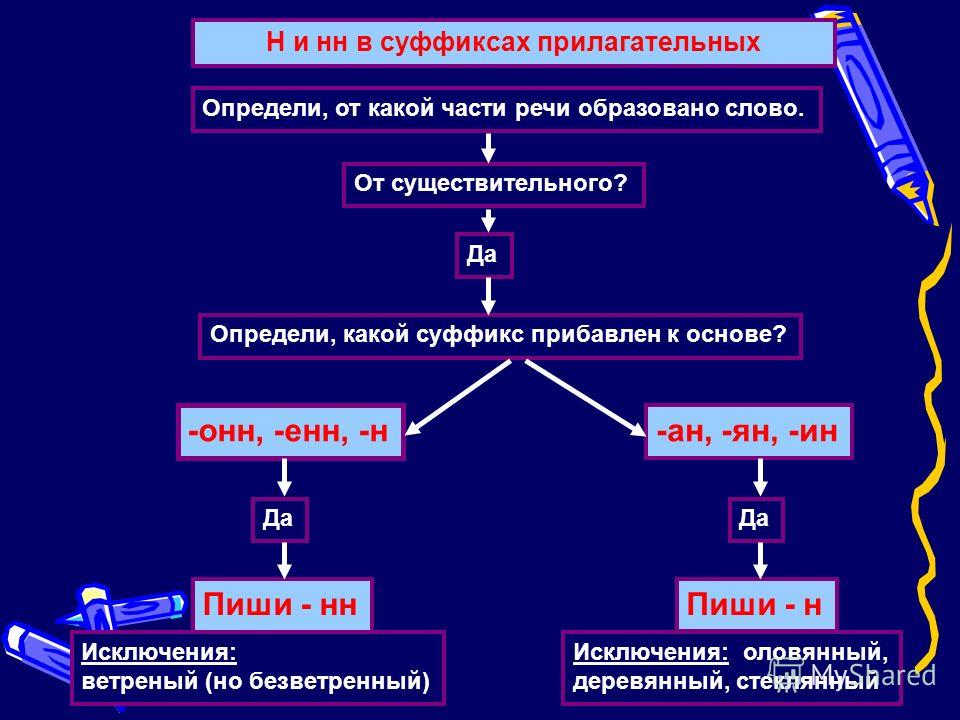

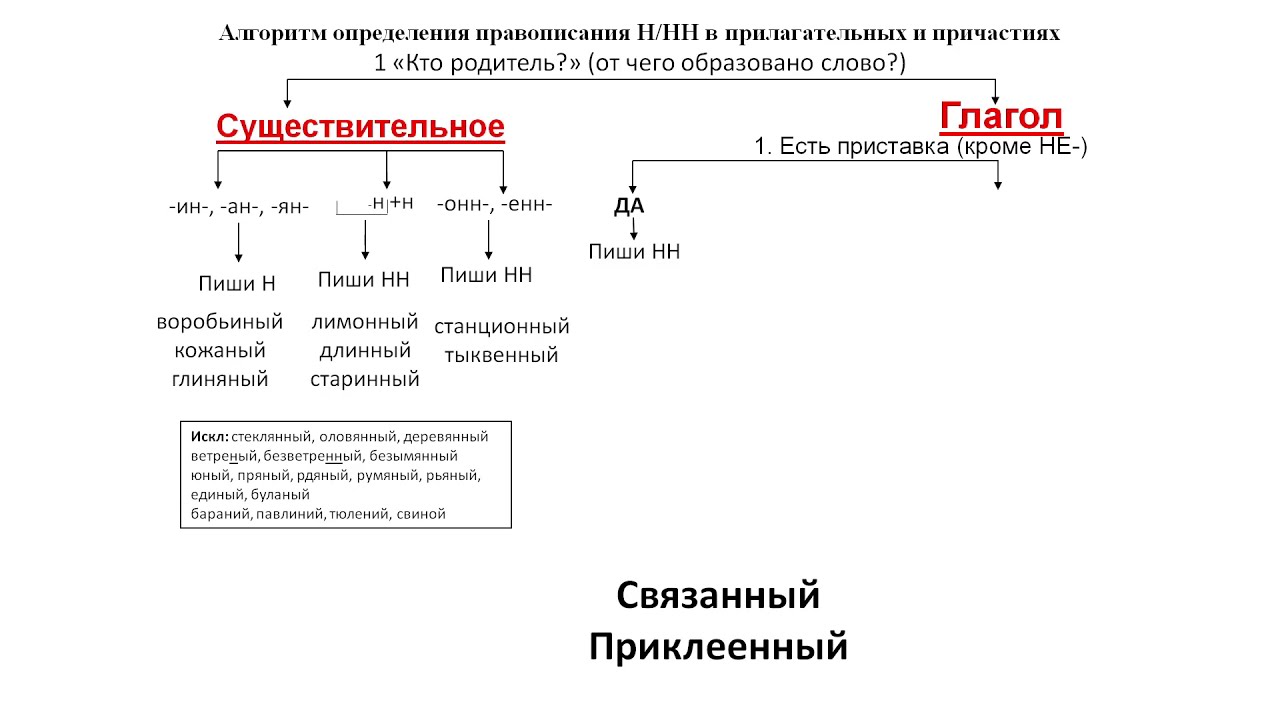

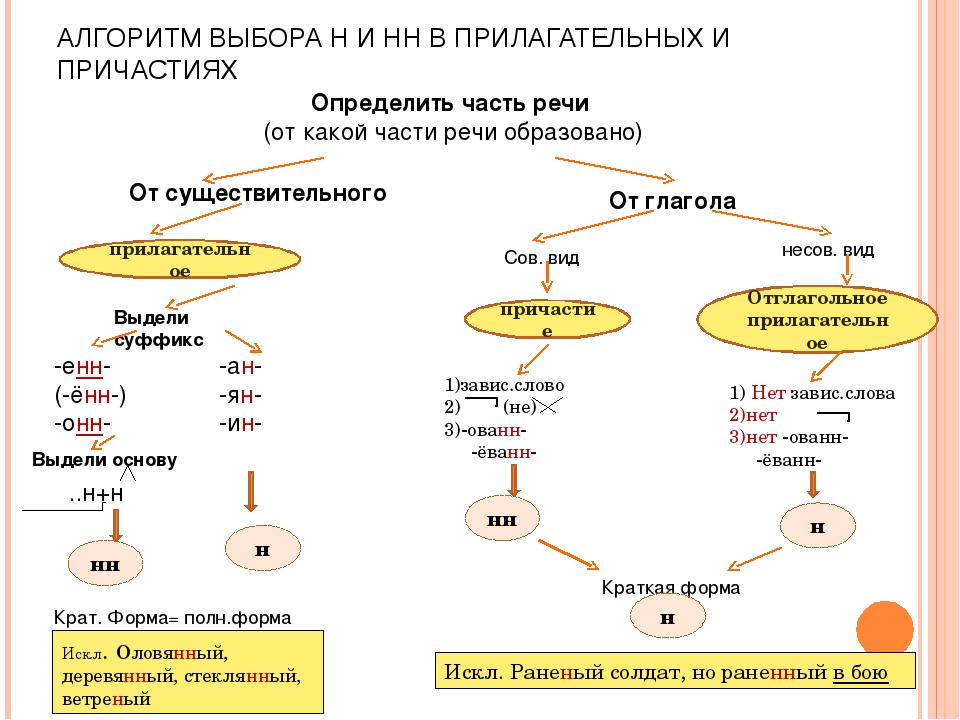

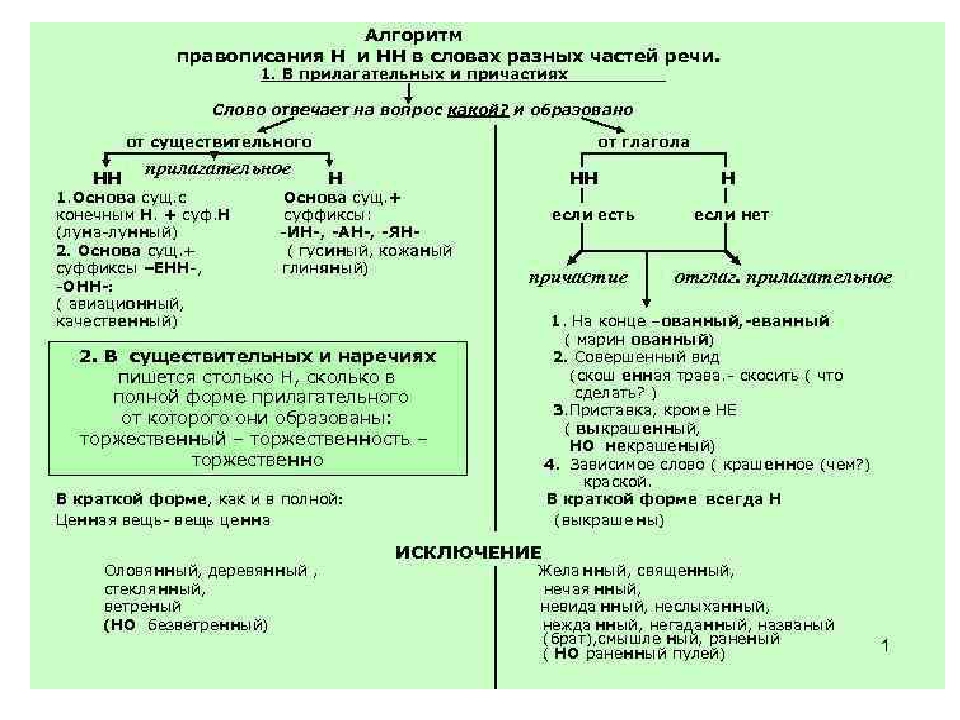

2. Н-НН в отымённых прилагательных

НВ прилагательных, образованных

от существительных

-ан- песчаный

-ян- серебряный

-ин- пчелиный

В притяжательных

прилагательных (олений, кабаний)

Искл! Стеклянный, оловянный,

деревянный

Зап! Румяный, синий, зелёный,

рдяный, свиной, пряный,багряный,

рьяный, юный, но юннат

НН

В прилагательных, образованных

от существительных

-онн- революционный

-енн- безветренный

…нн- старинный

Искл! Ветреный (день, человек)

Зап! Ветряной (двигатель,

мельница, оспа)

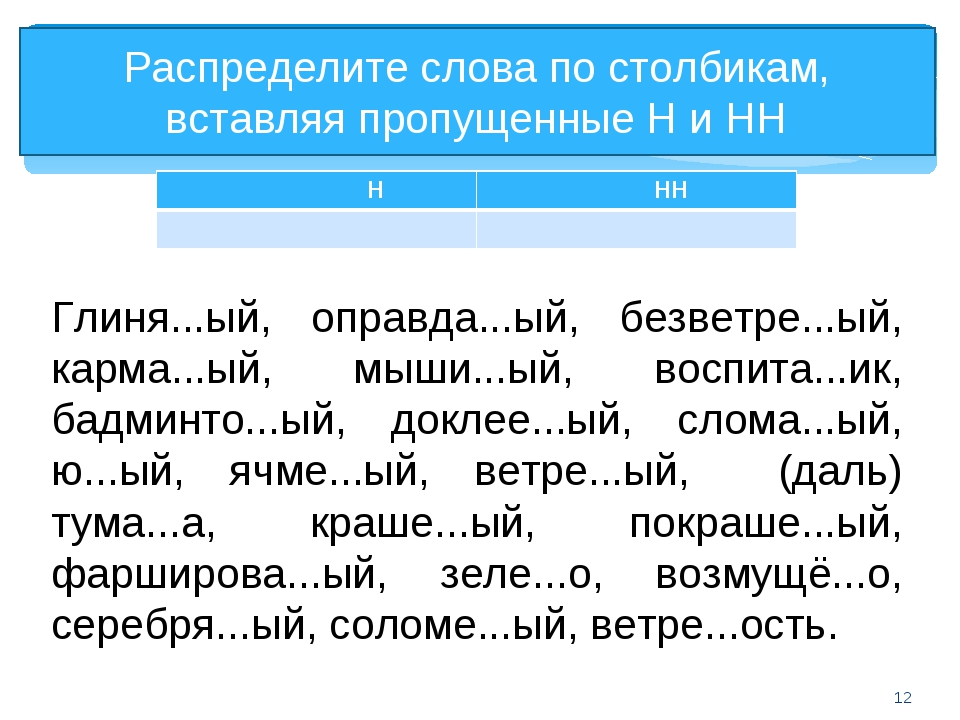

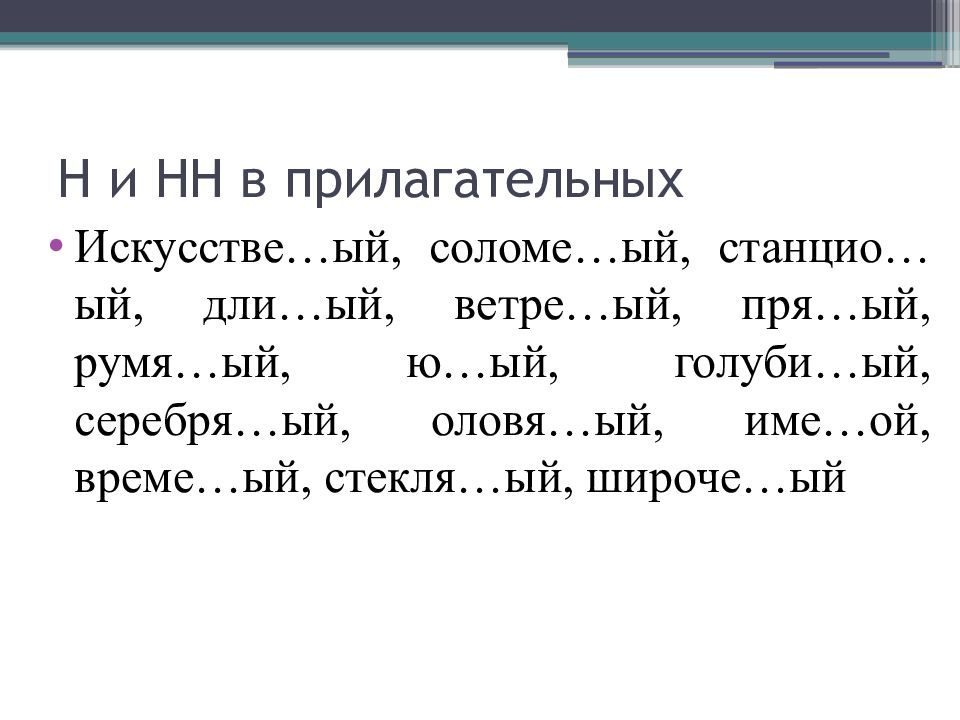

3. Объясните написание Н-НН

Багряный цвет, бесчисленное множество, глиняныйкувшин, дискуссионный вопрос, длинная дорога,

дровяной склад, деревянный дом, журавлиное гнездо,

зеленый фонарь, земляной пол, каменная труба,

картинная галерея, клюквенный морс, кожаное пальто,

конный клуб, ледяной покров, монотонный голос,

недюжинной силы, оловянные пуговицы, осенняя пора,

полотняная рубашка, революционный подъем, румяные

щеки, серебряная цепочка, соломенная крыша,

туманное утро, ураганный ветер, юные изобретатели.

Объясните написание Н-НН

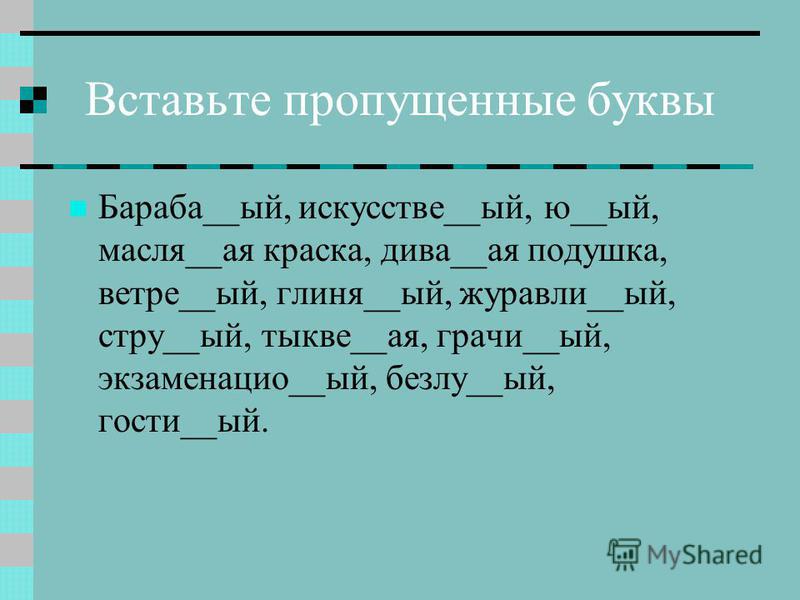

4. Вставить пропущенные буквы

Юн..ый участник, песчан..ые дорожки, гостин..ая,свин..ой, гостин..ица, трав..н..ое покрытие, бедствен..ое

положение, серебр..н..ый кулон, машин..ое масло,

ветр..н..ый день, солом..н..ые крыши, умствен..ая

работа, революцион..ый шаг, наш современ..ик,

истин..ые ценности, подлин..ый смысл, мышин..ая нора,

оловян..ый солдатик, лимон..ая кислота, врем..н..ое

отсутствие, безветр..н..ый полдень, сем..н..ой фонд,

кож..н..ый шлем, деревян..ый щит, весен..ий свет,

плем..н..ой скот, дров..н..ой сарай, крысин..ая

мордочка, баран..ий бок, станцион..ый смотритель,

лошадин..ая голова,

Вставить пропущенные буквы

5. Вставить пропущенные буквы

агитацион..ый плакат, сибирская листвен..ица, сезон..ый рабочий,широкий подокон..ик, смелый дружин..ик, кост..н..ой нож,

былин..ый герой, равнин..ый ландшафт, туман..ый вечер,

шерст..н..ой шарф, льн..н..ой комплект, масл.

.н..ые краски,

.н..ые краски,производствен..ый план, картин..ая галерея, глин..н..ый сосуд,

бесчислен..ые ошибки, ураган..ый ветер, румян..ый малыш,

бесцен..ый экземпляр, кон..ый спорт, петушин..ые бои,

Вставить пропущенные буквы

6. Вставить пропущенные буквы

ответствен..ый подход, прян..ость для борща,карман..ый фонарь, камен..ый дом,

невежествен..ый ученик, фанатичный

поклон..ик, поздравить именин..ика,

искусствен..ый шелк, книга бесцен..а, девочка

юн..а и ветрен..а, ошибки несомнен..ы,

высказывания стран..ы, гора величествен..а,

это свойствен..о всем детям, руки красн..ы и

далекая юн..сть.

Вставить пропущенные буквы

7. Спишите, раскрыв скобки, вставив пропущенные буквы

(Стари…ий) картина, (листве…ый) лес, (традицио…ий)встреча, (кожа…ый) диван, (кожев…ий) промышленность,

(дивизи..ий) артиллерия, (гума..ый) законы, (исти..ий)

гуманизм, (коре..ой) противоречия, (лебеди…ый) стая,

(стекля…ый) витрина, (укоризне…ый) взгляды, (песча…

ый) равнина, (серебря…ый) гнездо, (торжестве…ый)

заседания, (параллель…ый) прямые, (искусстве…ый)

водоемы, (цели…ый) земля, (отечестве…ый)

производство, (муравьи…ый) кислота, (комиссио…ый)

магазин, (оккупацио…ый) войска, (пламе…ый) сердце,

(революцио…ый) теория, (румя.

.ый) щека, (сенсацио..ый)

.ый) щека, (сенсацио..ый)известие, (масл..ый) трансформатор, (масл…ый) лаки,

(безветр..ый) ночь, (ветр…ый) люди, (ветр..ый) насосы.

Спишите, раскрыв скобки,

вставив пропущенные буквы

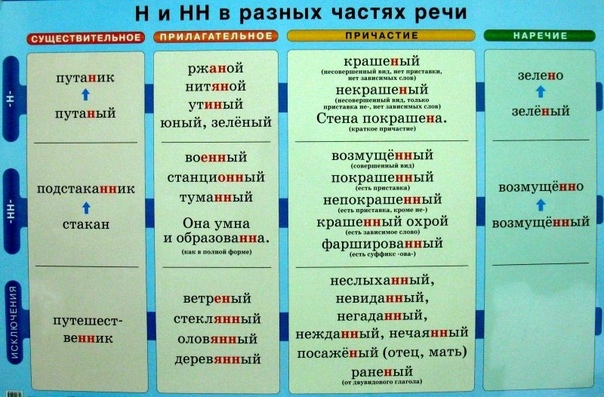

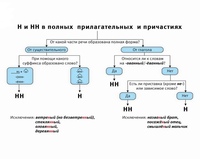

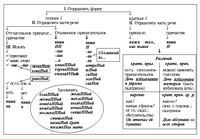

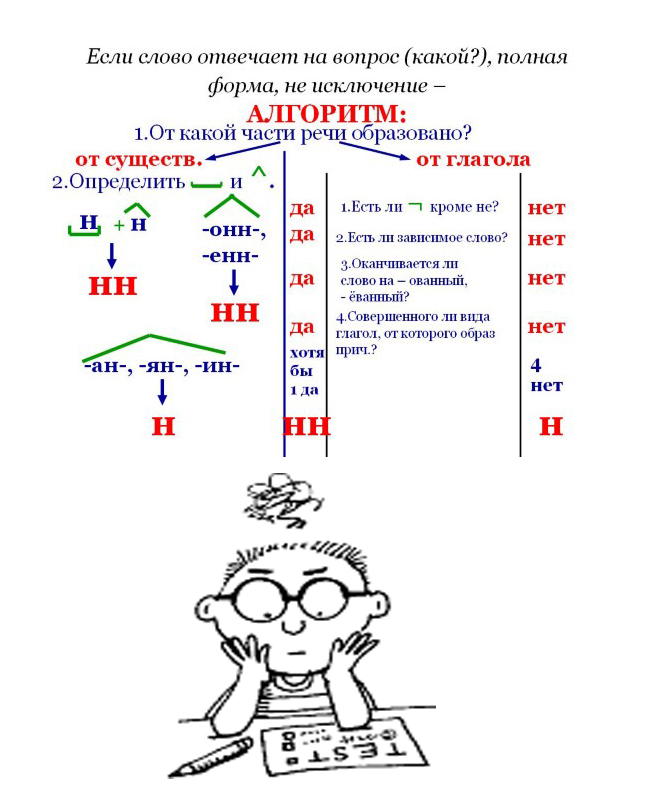

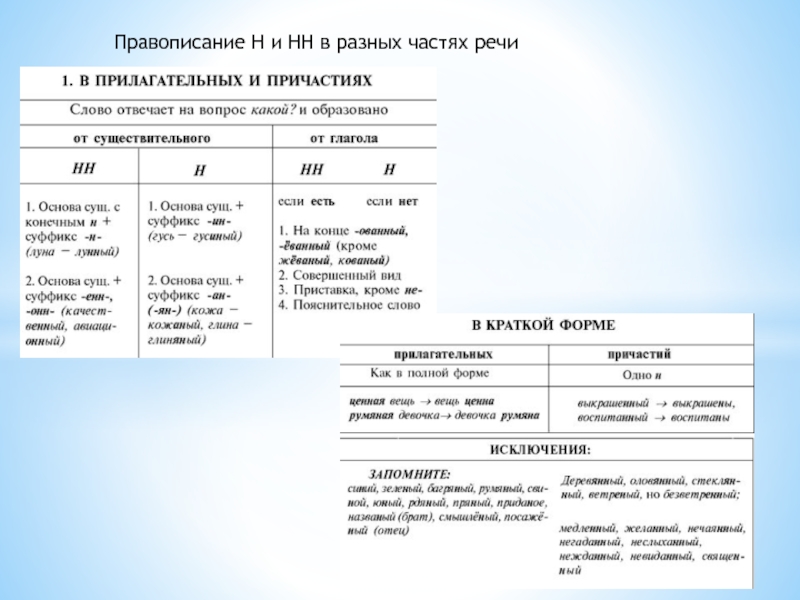

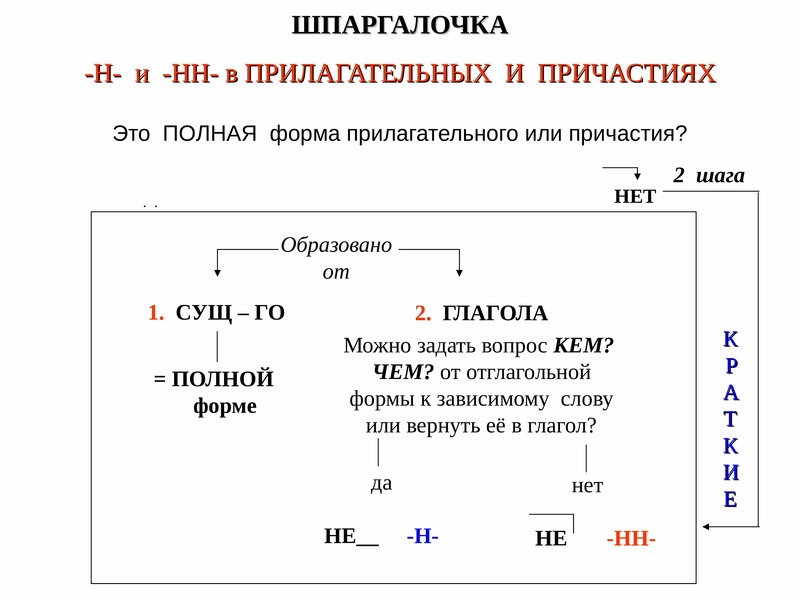

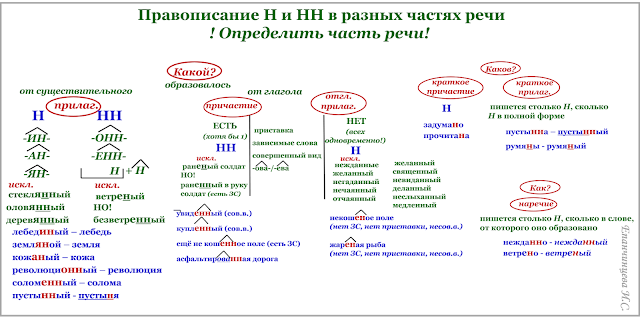

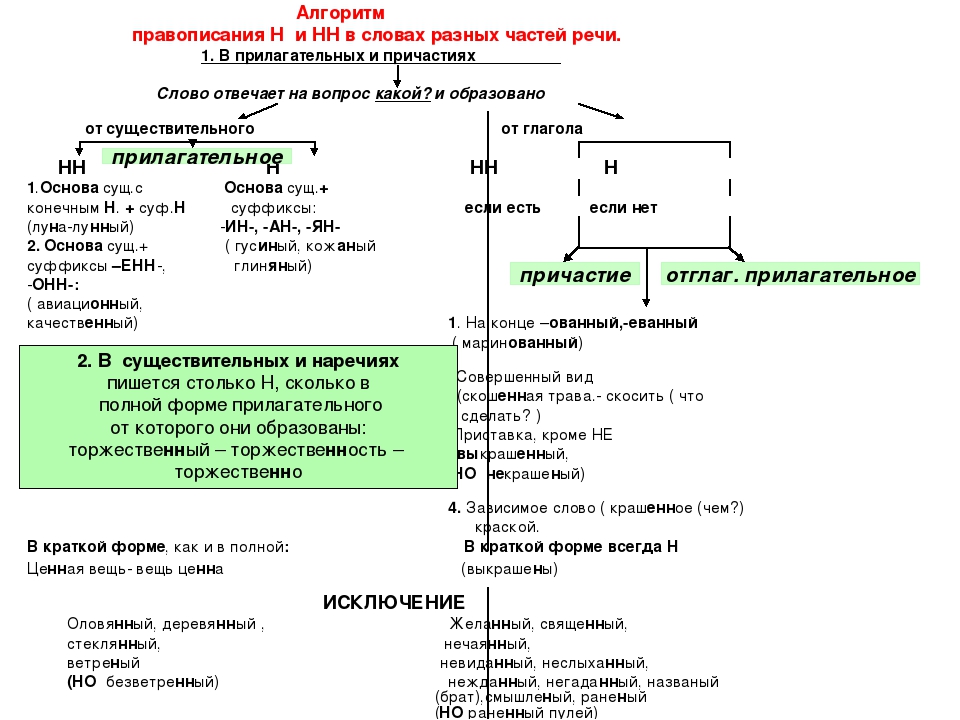

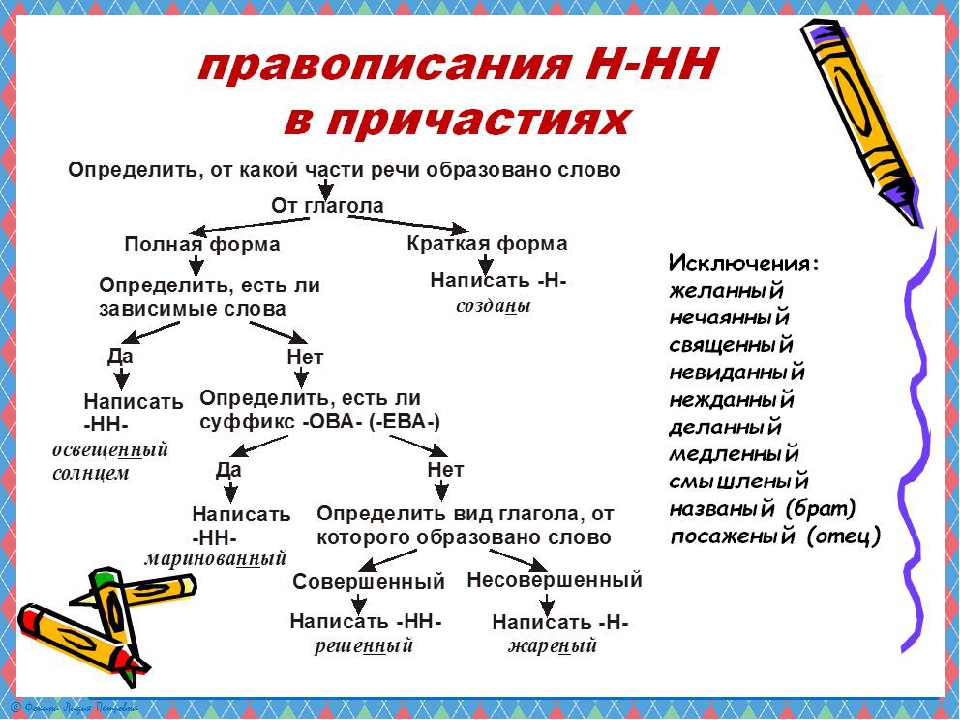

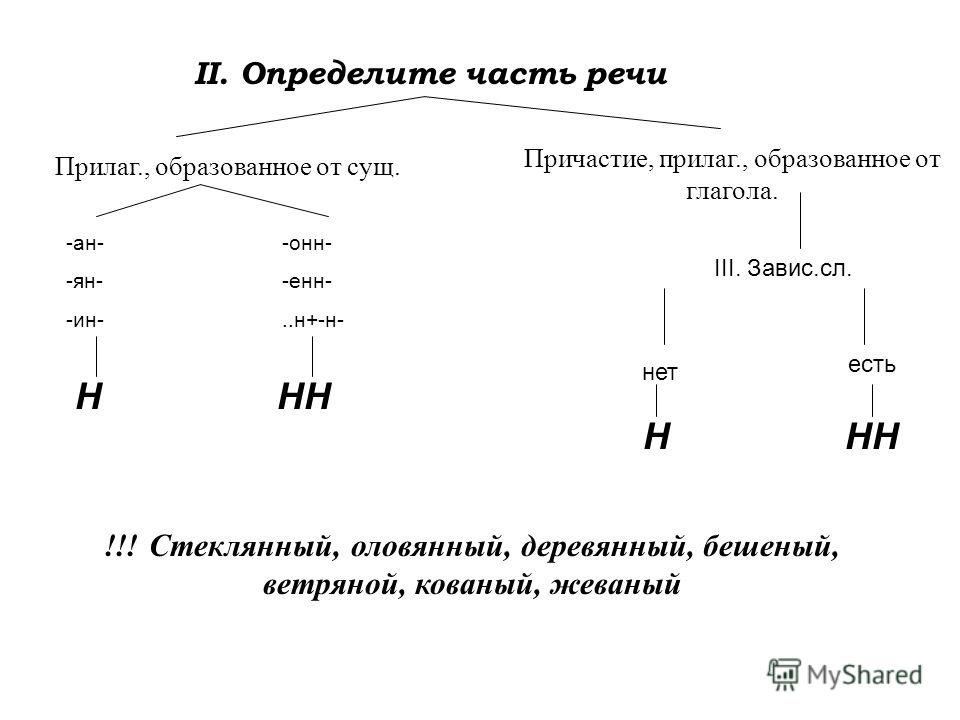

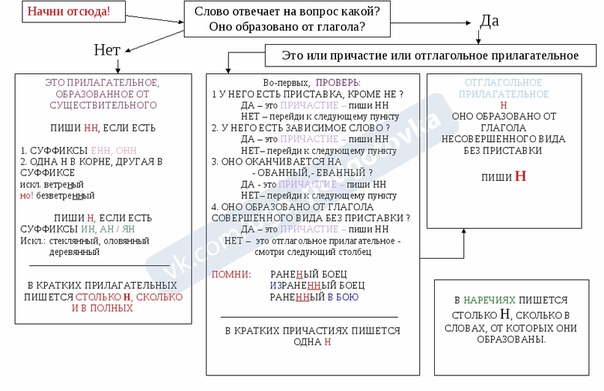

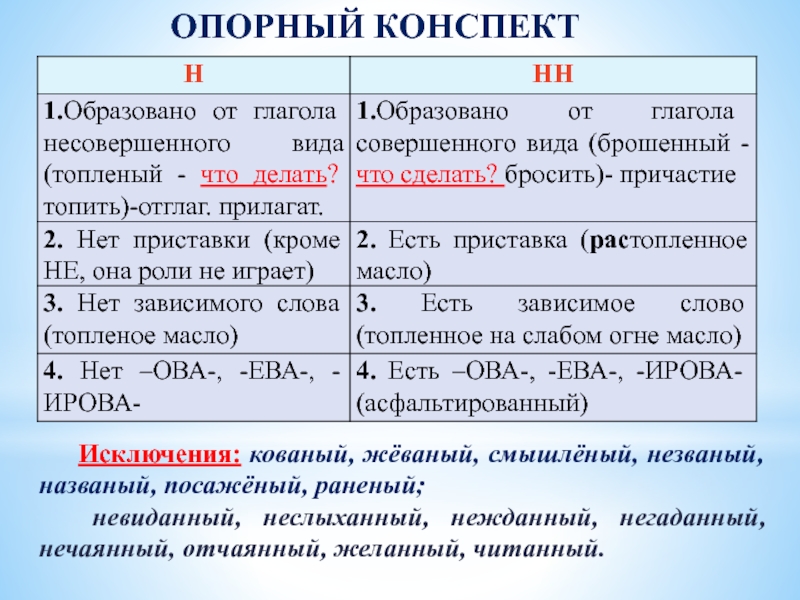

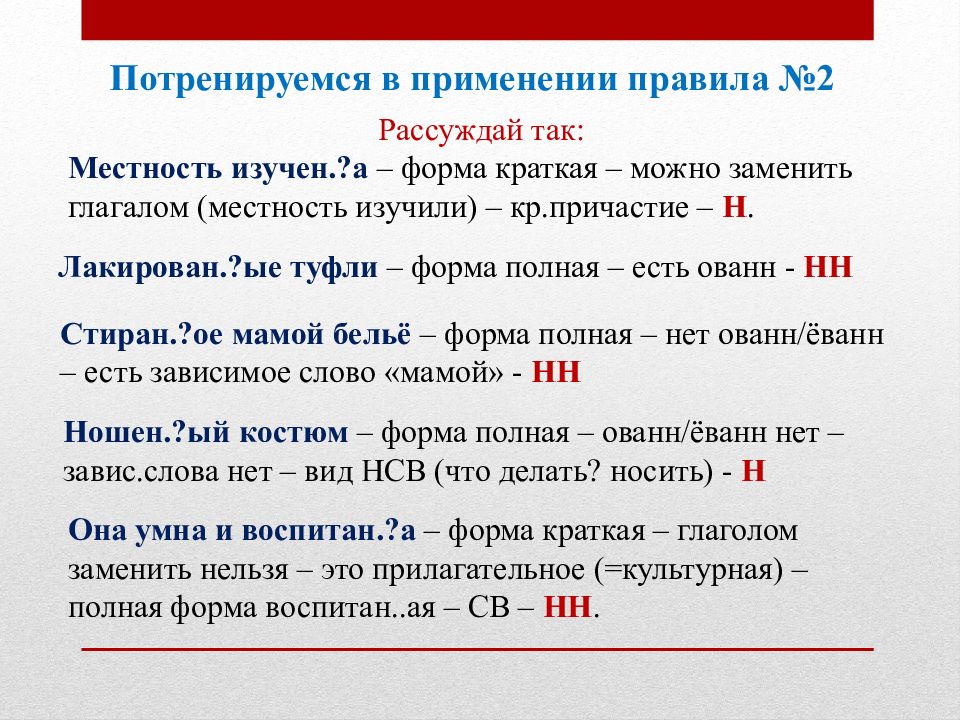

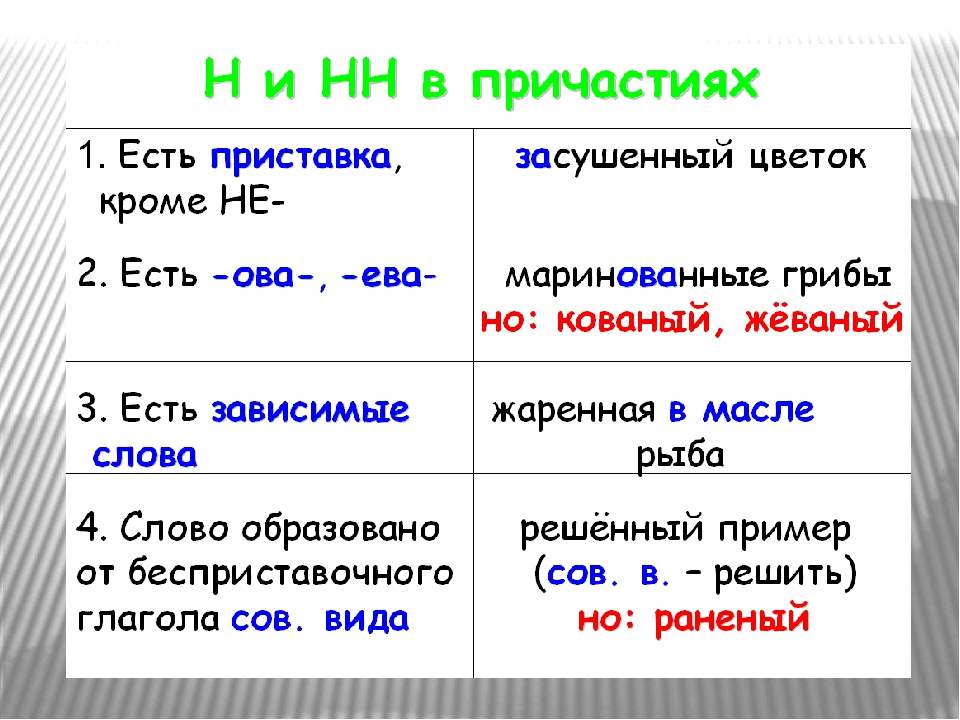

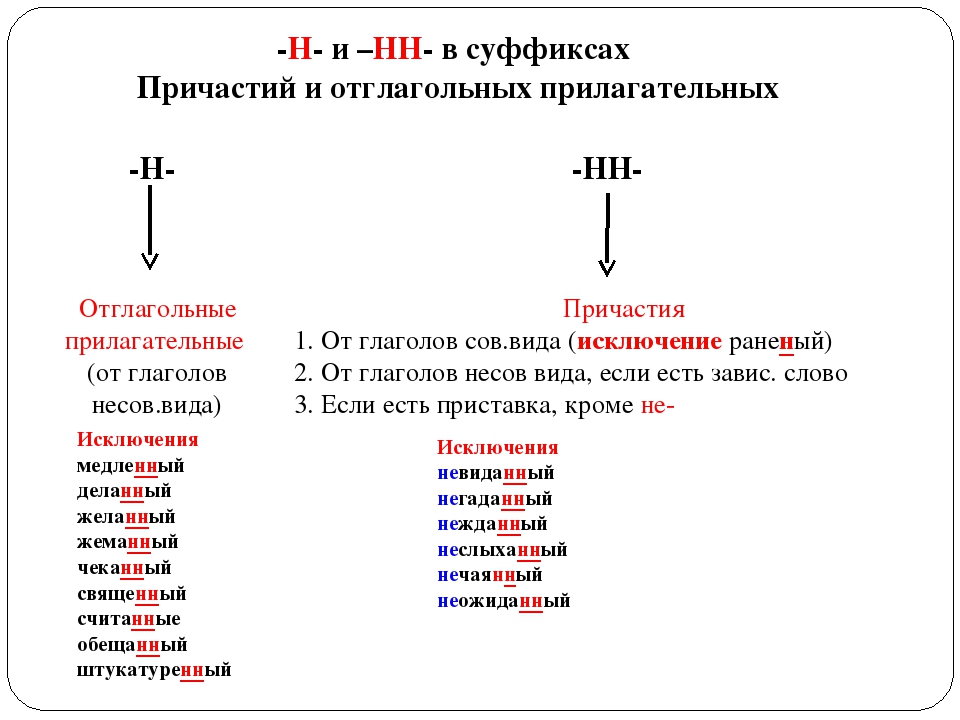

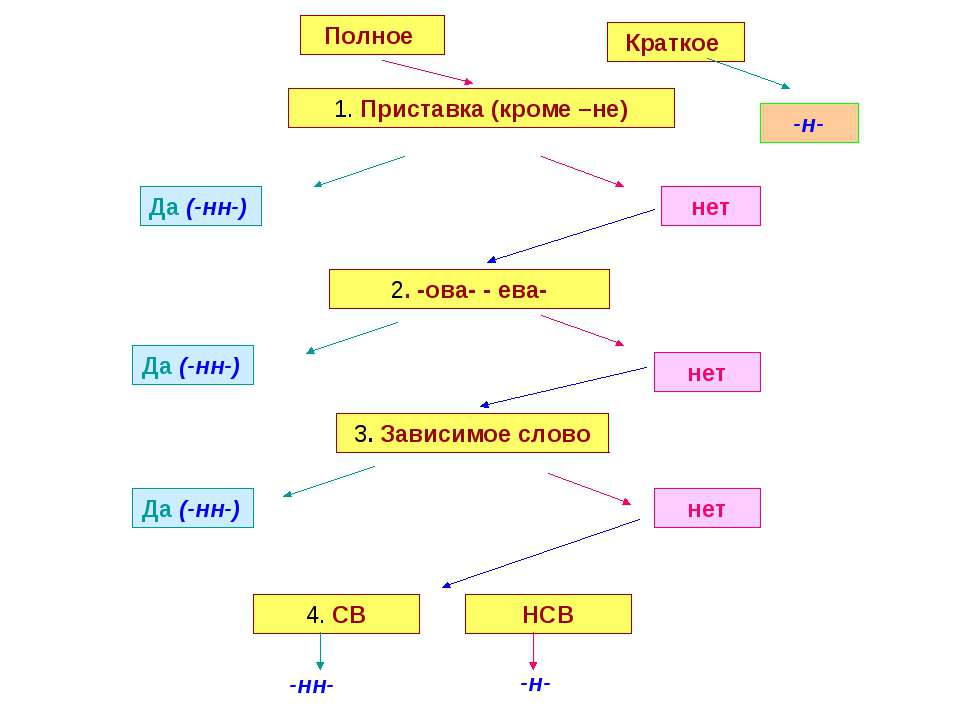

В отглагольных формах

1.Образованные от глаголов

несов вида

Тушить – тушёный

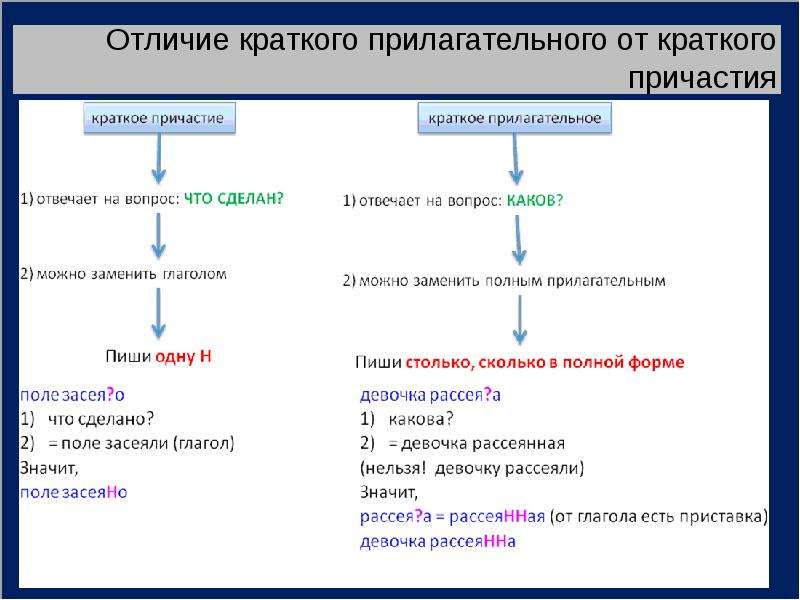

2. В крат прич

калитка покрашена

В отглагольных формах

1.Образованные от глаголов

сов вида

Решить – решённый

Искл! раненый

1.Образованные от глаголов с

приставками (кроме

приставки не-)

Покрасить – покрашенный

1.Если есть зависимое слов

Крашенный краской забор

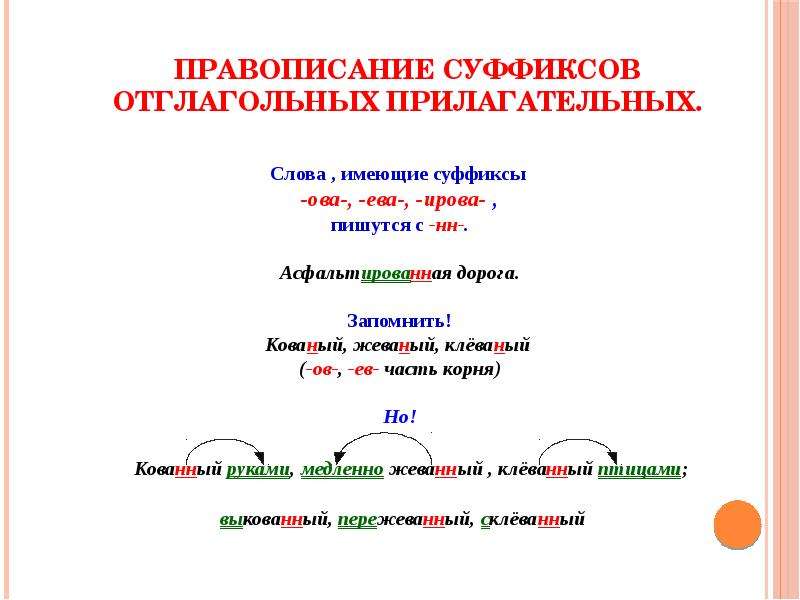

4. Если есть суффиксы –ова(-ева-), ирова

Маринованный

Искл! Жёваный, кованый

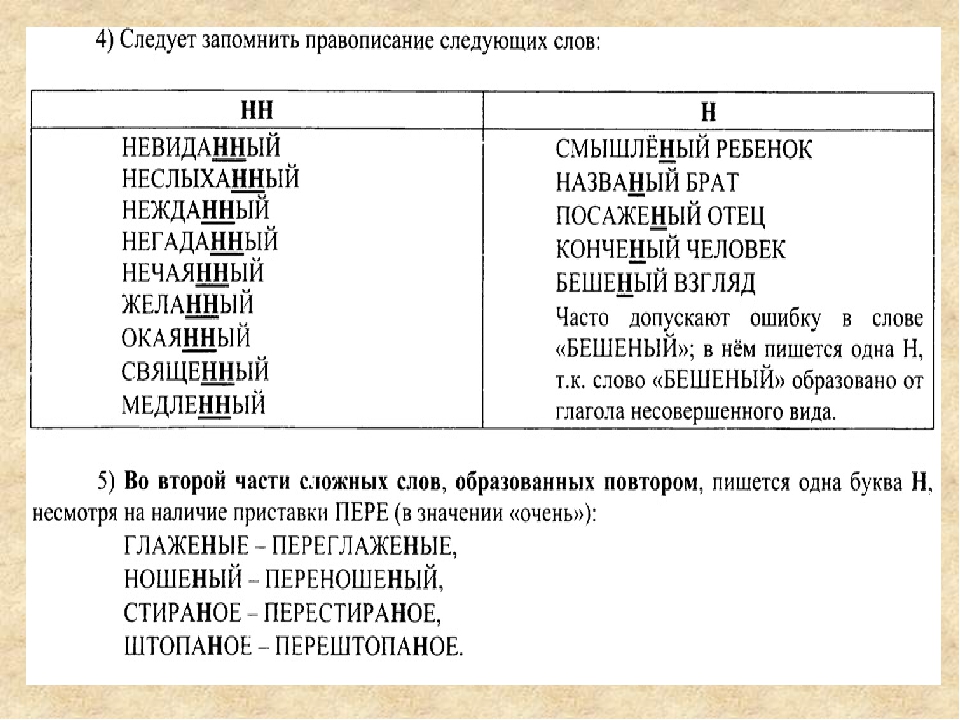

9. Запомнить!

Зап! Смышлёный,бешеный

Нежданный,

неожиданный,

нечаянный, медленный,

желанный, виденный,

нежданный, негаданный,

невиданный,

неслыханный,

священный, обещанный,

отчаянный, деланный.

Запомнить!

10.

Запомните слова-исключения! Они все есть в задании А14! назваНый (брат)

Запомните слова-исключения! Они все есть в задании А14! назваНый (брат)непрошеНый (гость)

посажёНый (отец)

смышлёНый

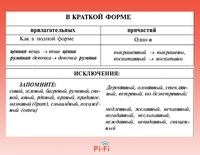

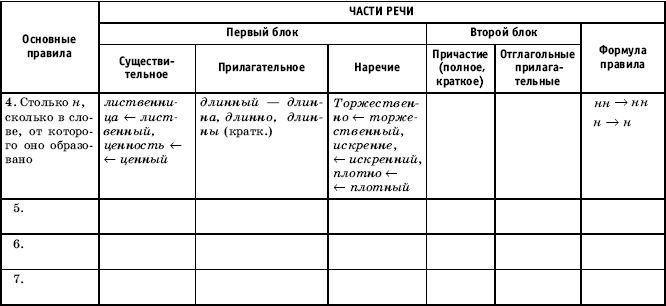

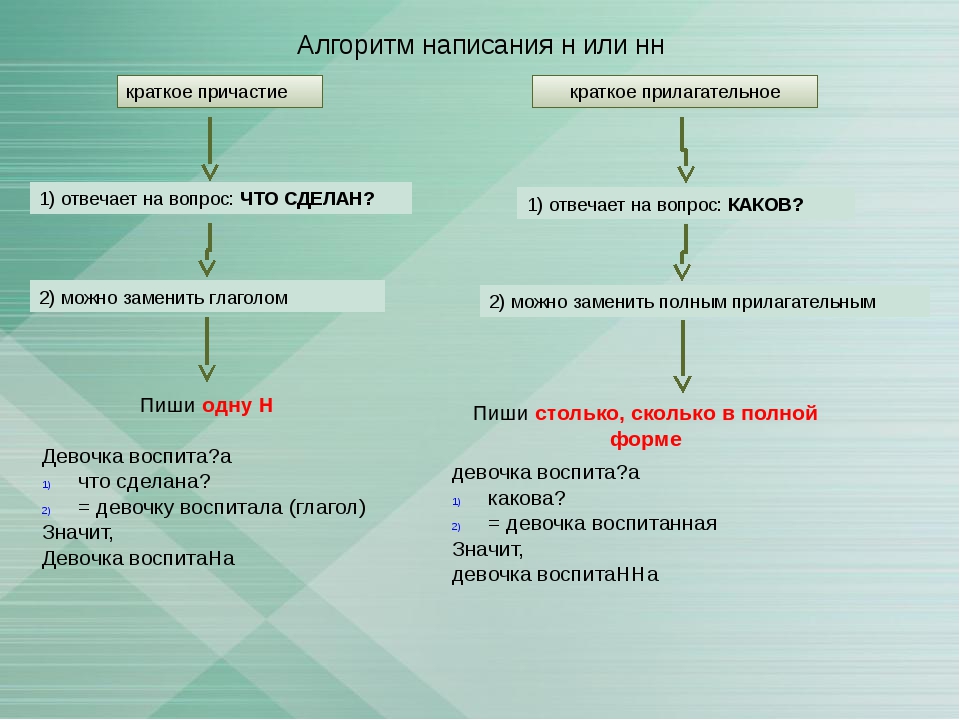

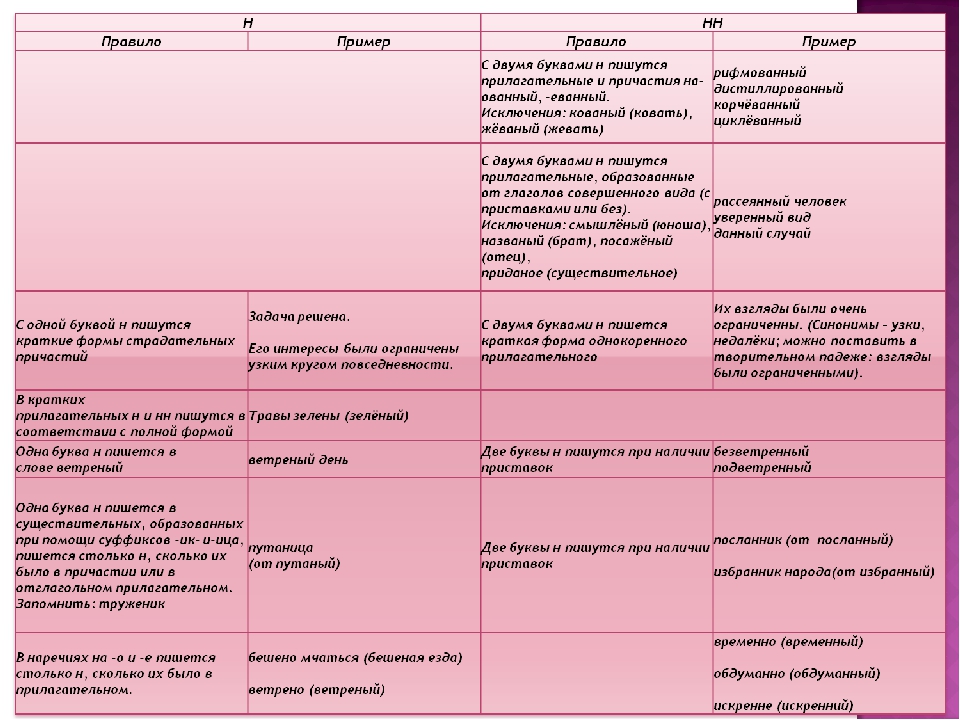

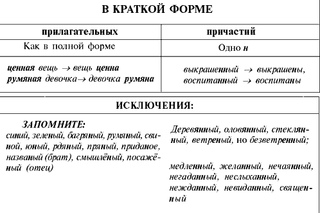

11. В кратких формах

Краткие причастияКраткие

прилагательные

Являются сказуемым

Временный

признак

Постоянный

Можно заменить

глаголом

Можно заменить

прилагательным

Н

Столько Н, сколько

в слове, от

которого оно

образовалось

Наречия

Являются

обстоятельством

Столько Н, сколько

в слове, от

которого оно

образовалось

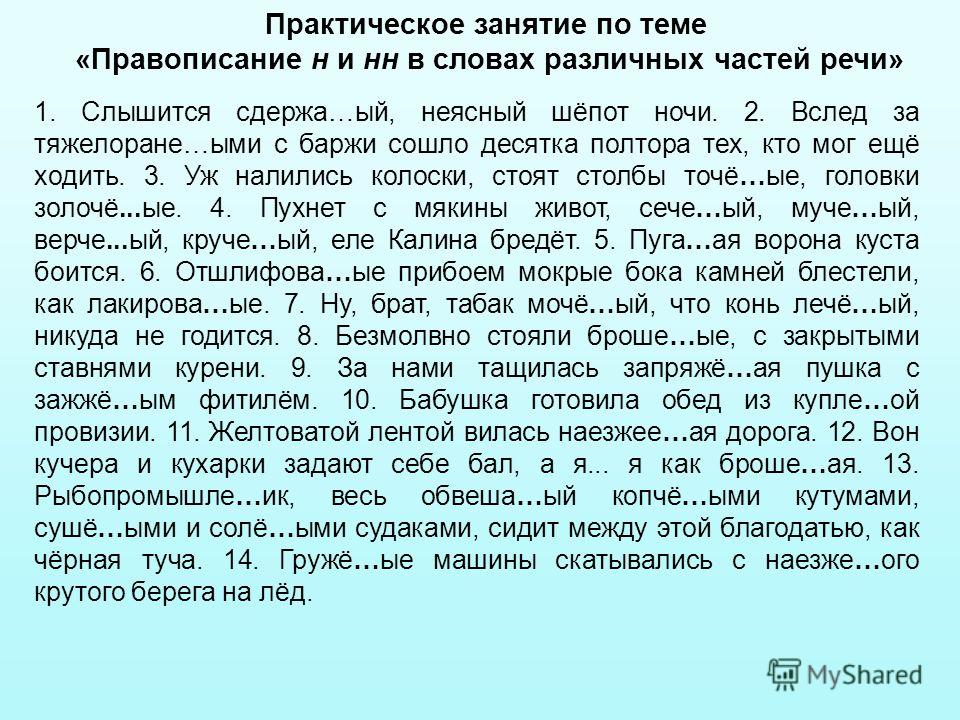

12. Объясните орфограммы

Гашё…ая известь, пута…ые ответы, нежда…ый гость,дублё…ый полушубок, стриже…ая голова, некраше…ый

пол, ране…ый боец, беше…ый кот, гружё…ая баржа,

чище…ые сапоги, плетё…ая корзина, балова…ый малыш,

графлё…ый блокнот, писа…ая красавица,

асфальтирова…ая дорога, незва…ые гости, жёва…ый

хлеб, домотка…ая скатерть, кова…ый меч, стреля…ый

воробей.

Объясните орфограммы

13.

Объясните орфограммы Поноше…ое пальто, ноше…ые вещи, растеря…ый человек,

Объясните орфограммы Поноше…ое пальто, ноше…ые вещи, растеря…ый человек,отвлечё…ое рассуждение, смышлё…ый малыш,

подстреле…ый воробей, пуга…ая ворона, напуга…ый

зверь, тиснё…ый переплет, тиснё…ый золотом билет,

краше…ые парты, некраше…ый пол, неслыха…ая наглость,

нежда…ый приезд, погаше…ый свет, скоше…ая трава,

коше…ая вчера трава, коше…ый луг, некоше…ые травы.

Объясните орфограммы

14. Объяснить устно пропущенные орфограммы

Растерян..ый человек, мочен..ые яблоки, брошен..ый мяч,стрижен..ый по-мальчишески, книга иллюстрирован..а,

завещан..ый, желан..ый, мощен..ый булыжником,

стремления молодежи возвышен..ы, копчен..ый окорок,

нарушен..ая тишина, жарен..ые в печке семечки, ягоды

рассыпан..ы, недоварен..ый картофель, неслыхан..ые дела,

лыжи заброшен..ы на чердак, известие получен..о утром,

посажён..ый отец, неискушен..ый человек, смышлен..ый

малыш, овощи сварен..ы, публика избалован..а зрителями,

мука просеян.

.а, топлен..ое в печке, отчаян..ый крик,

.а, топлен..ое в печке, отчаян..ый крик,честный тружен..ик, нехожен..ые тропы, куплен..ый, давно

мазан..ые хаты, она невежествен..а и ограничен..а,

Объяснить устно

пропущенные орфограммы

лица вымазан..ы сажей, квашен..ая капуста, вязан..ая из

шерсти кофта, всё погружен..о в сон, комната обставлен..а,

ранен..ый в руку, нескошен..ый луг, мука рассыпан..а по

столу, топлен..ое масло, зван..ые на вечер гости,

маринован..ые грибы, морожен..ое мясо, манеры

изыскан..ы, асфальтирован..ый, ламинирован..ый,

заплатан..ый полушубок, ткан..ая шелком салфетка,

поломан..ые деревья, зван..ые гости, дорога длин..а, тучи

рассеян..ы, вязан..ая скатерть, средства изыскан..ы,

чекан..ый шаг, усадьба ограничен..а рекой, жеман..ые

манеры, смущен..ая девушка, дорога пройден..а,

воронен..ая сталь, гранен..ый стакан, воспитан..ый

человек, бешен..ый темп, автоматизирован.

.ый, кован..ый,

.ый, кован..ый,мечен..ые карты, инкрустирован..ый, священ..ик,

маслен..ица, стиран..ый-перестиран..ый, гладкокрашен..ый

материал, воспитан..ик, известный учен..ый, мучен..ик,

варен..ик, варен..ый-переварен..ый

Укажите верное объяснение написания выделенного слова.

Берега Онежского озера были освое..ы ещё в III

тысячелетии до нашей эры.

1)

Пишутся две буквы НН, так как это прилагательное образовано от

местоимения свой с помощью суффикса -ЕНН-.

2)

Пишется одна буква Н, так как это краткая форма причастия,

образованного от глагола освоить.

3)

Пишется одна буква Н, так как это причастие без пояснительных

слов.

4)

Пишутся две буквы НН, так как это прилагательное, а не причастие;

в кратком прилагательном сохраняется написание -НН-.

2

17. В каком ряду в обоих случаях пишется НН:

1. подсуше..ое бельё, стари..ые вещи2. не выуче..ы уроки, связа..ый свитер

3. нечая..ый взгляд, кури.

.ый бульон

.ый бульон4. ути..ая охота, кова..ая лошадь

18. В суффиксах каких слов следует писать -нн-?

Га) Ошибка исправле_на;

б) полирова_ная мебель;

в) туше_ный картофель;

г) подкова_ная лошадь.

19. На месте каких цифр пишется НН?

Может быть, коньки назва(1)ыконьками именно потому, что в

старину делали деревя(2)ые коньки,

украше(3)ые завитками в виде

лошади(4)ой головы.

2,

3

20. Сколько Н в этих частях речи, столько будет и в наречиях

Вставьте пропущенные буквыОбращаться гума…о; рья…о приняться за

работу; смущё…о отвернуться; пута…о

объяснять; сдержа…о возражать; прийти

нежда…о – негада…о; вести себя легкомысле…о,

ветре…о; отвечать рассея…о; подли…о научный

анализ; жизне…о важное решение.

21. Найдите слова, в которых допущены ошибки.

1. Временый.2. Безветреный.

3. Шерстяной.

4. Напряженость.

5. Соотечественик.

6. Современик.

7.

Бешеный.

Бешеный.8. Конопляник.

1, 2, 4, 5, 6

22. Вставьте пропущенные н или нн. Обозначьте цифрой 1 слова с н, цифрой 2 – слова с нн.

а) Балова_ый,б) жже_ый,

2, 1, 2, 1, 1, 1, 1, 2, 2, 2, 1, 1, 2, 1, 2

в) взбеше_ый,

г) кипяче_ый,

д) кваше_ый,

е) пута_ый,

ж) копче_ый,

з) припая_ый,

и) прокипяче_ый,

к) рва_ый в нескольких местах,

л) сея_ый,

м) нестриже_ый,

н) туше_ый с пряностями,

о) пуга_ый,

п) засея_ый.

23. Найдите ошибки в следующих словах.

1. Непрошенный.2. Бесприданница.

3. Приданое (невесты).

4. Нежданый.

5. Даный.

6. Гостиная (комната).

7. Желанный.

8. Отчаянный.

9. Названый (брат).

10. Смышленный.

1, 4, 5, 10

24. Перепишите, вставьте н или нн, обозначая суффиксы.

1) Люди тайги сдержа_ы.2) Много войск сосредоточе_о на

этом участке.

3) Оратор говорил убежде_о.

4) Территория около нового дома

еще не благоустрое_а.

5) Ответы легкомысле_ы и

необдума_ы.

25. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Агитацио(1)ые листки, сорва(2)ыеветром, валялись на моще(3)ой

мостовой, были занесе(4)ы снегом.

1) 1, 2, 3

3

3) 3, 4

4) 1, 3

26. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

1) 1, 2, 3, 42

2) 1, 2, 4, 5, 6

3) 3, 5, 6

4) 3, 4, 5, 6

Барская воспита(1)ица была умна и

образова(2)а, да и прида(3)ое за ней

давали невида(4)ое, но нежда(5)о —

негада(6)о случилась небывалая история.

27. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Рассказа(1)ая Петром Ильичом история былаявно им выдума(2)а: у него и в помине не

было назва(3)ого брата, о котором он так

восхище(4)о и взволнова(5)о упоминал.

1) 1, 2

2) 3, 4, 5

3

3) 2, 3

4) 1, 2, 3, 4, 5

28.

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Постоя(1)ые внутре(2)ие противоречия

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Постоя(1)ые внутре(2)ие противоречиятерзали душу этого труже(3)ика,

муче(4)ика науки, убежде(5)ого только в

том, что избра(6)ый им путь верен.

1) 1, 2, 5, 6

2) 3, 4, 5

1

3) 4, 5, 6

4) 2, 3, 4

29. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

В гости(1)ой чи(2)о сидели наряже(3)ыедетишки, завороже(4)о смотревшие на

хозяйку, чьими руками было выставле(5)о

всё это великолепное угощение.

1) 2, 3, 4

2) 1, 2, 5

3

3) 1, 5

4) 3, 4, 5

30. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Моче(1)ые яблоки особе(2)о вкусны стоплё(3)ным молоком и свежеиспечё(4)ым

хлебом.

1) 1, 2, 3

2) 1, 3

3) 2, 3, 4

2

4) 2, 4

31. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Гранё(1)ые шпили собора былиторжестве(2)о устремле(3)ы в небесную

высь, и, потрясё(4)ые его красотой,

туристы ошеломле(5)о замолчали.

1) 1, 3

2) 2, 3, 5

1

3) 3, 5

4) 1, 5

32. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Урага(1)ый ветер в пусты(2)ых степяхКазахстана поднимает бесчисле(3)ое

множсество семян растений, и они

впоследствии будут рассея(4)ы на многие

десятки километров от места созревания.

1) 3, 4

2

2) 1, 2, 3

3) 1, 2, 4

4) 2, 4

33. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Сплете(1)ые из ивняка корзины былихорошо просуше(2)ы и сложе(3)ы в доме,

недавно построе(4)ом из листве(5)ицы.

1) 1, 4, 5

2) 2, 3, 5

3) 1, 2, 5

1

4) 3, 4, 5

34. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Изнеже(1)ые барские дочки былинабеле(2)ы и напудре(3)ы, наряже(4)ы в

платья, присла(5)ые из Парижа, и

вывезе(6)ы в большой свет.

1) 1, 2, 3

2) 1, 5, 6

3

3) 1, 5

4) 4, 5

35.

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Запряжё(1)ые кони беше(2)о храпели и били

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Запряжё(1)ые кони беше(2)о храпели и билио мостовую кова(3)ыми копытами; их

пышные гривы были украше(4)ы яркими

лентами, вплете(5) ыми накануне

конюхом Архипом.

1) 1, 5

1

2) 3, 5

3) 1, 3, 5

4) 2, 4

36. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

На пустыре за садом валялись разбитыеглиня(1)ые кувшины, жестя(2)ые банки,

рва(3)ая обувь, полома(4)ая мебель,

какие-то спиле(5)ые деревья.

1) 3, 4, 5

2) 4, 5

2

3) 1, 2, 3

4) 1, 4, 5

37. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Серебря(1)ая фляжка была наполне(2)аосе(3)ей студе(4)ой водой, вкусной, как

драгоце(5)ое выдержа(6)ое вино.

1) 3, 4, 5

2) 1, 3, 6

3) 2, 3, 4

4

4) 1, 2, 4

38. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Ребятишки, искре(1)е обрадова(2)ыенеожида(3)о богатым уловом, немедле(4)о

отправились к сторожке нехоже(5)ыми,

пута(6)ыми тропами.

1) 5, 6

2) 1, 4

1

3) 2, 3

4) 4, 5, 6

39. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Деревушка бала маленькая: несколькорубле(1)ых, давно не краше(2)ых

домиков, расположе(3)ых вдоль

наезжее(4)ой дороги, по которой

проносились груже(5)ые машины.

1) 1, 2, 5

2

2) 1, 5

3) 3, 4

4) 3, 4, 5

40. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Приветливый старик в суко(1)ой рубахе снесвойстве(2)ой ему хлопотливостью

ставит на стол соле(3)ые огурцы,

жаре(4)ую с салом картошку, мочё(5)ую

бруснику.

1) 3, 5

1

2) 2, 3, 4

3) 1, 3, 4, 5

4) 1, 2, 3, 4

41. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Чайки церемо(1)о сидели на чугу(2)ыхшарах, изъеде(3)ых ржавчиной, и

беспреста(4)о выхватывали что-то из

соле(5)ой морской воды.

1) 1, 2, 3, 4

2) 2, 3, 4

1

3) 2, 3, 4, 5

4) 1, 3, 5

42. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Матросы, издавая беше(1)ые горта(2)ыезвуки, подняли рва(3)ые паруса, и

таинстве(4)ое судно мгнове(5)о исчезло в

тума(6)ой дали.

1) 1, 2, 3, 5

2) 1, 2, 3, 4, 6

3

3) 2, 4, 5, 6

4) 2, 3, 5, 6

43. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Я до сих пор помню писа(1)ую масломкартину, висевшую над моей кроваткой:

золочё(2)ую упряжь коней с лебеди(3)ыми

шеями, запряжё(4)ых в разрисова(5)ую

карету.

1) 1, 4, 5

1

2) 2, 3, 4

3) 3, 4, 5

4) 1, 3, 5

44. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Свежескоше(1)ая трава издавала пря(2)ыйаромат, и Иван облегчё(3)о и обессиле(4)о

повалился на неё: стога сена уже были

сложе(5)ы и укрыты от приближающейся

грозы.

1) 2, 3, 4, 5

2

2) 1, 3, 4,

3) 1, 2, 5

4) 3, 4, 5

45. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Живем мы в цивилизова(1)ом миревысотных зданий, моще(2)ых и

асфальтирова(3)ых улиц и площадей,

автобусов и троллейбусов,

переполне(4)ых озабоче(5)ыми людьми.

1) 1, 3, 4, 5

1

2) 2, 3, 4, 5

3) 3, 4, 5

4) 1, 4, 5

46. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Румя(1)ый ю(2)ат протянул мне тетрадь, вкоторой была нарисова(3)а стра(4)ая

птица, будто стриже(5)ая под гребенку.

1) 2, 4, 5

2) 1, 3

3) 2, 4

2

4) 4, 5

47. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Как вкусен зимой компот, сваре(1)ый изсушё(2)ой малины, вяле(3)ой на солнце

вишни и щедро сдобре(4)ый ароматным

липовым медом!

1) 3, 4

2) 2, 3

3

3) 2

4) 3

48.

В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н? На глиня(1)ом истопта(2)ом полу томился

В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н? На глиня(1)ом истопта(2)ом полу томилсяране(3)ый пле(4)ый с болезне(5)ым

выражением лица.

1) 2, 3, 4

2) 3, 4, 5

3) 1, 2, 5

4

4) 1, 3

49. В каком варианте ответа правильно указаны все цифры, на месте которых пишется одна буква Н?

Охотники остановились у озера,восторже(1)о любуясь его серебря(2)ой

гладью, чистыми песча(3)ыми берегами,

лебеди(4)ой стаей, величаво плавающей у

берега.

1) 1, 2, 3

3

2) 2, 3

3) 2, 3, 4

4) 1, 3, 4

50. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Хозяин, увидев нежда(1)ого и незва(2)огогостя, раздраже(3)о и сконфуже(4)о

поздоровался.

1) 1, 2, 3, 4

2) 2, 3, 4

3) 1, 2

4

4) 1, 3, 4

51. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Сдержа(1)о поздоровавшись с вое(2)ыми,старик с каме(3)ым выражением лица

протянул им кожа(4)ую пастушью сумку с

жестя(5)ыми застежками.

1) 1, 2, 3

2) 3, 5

1

3) 1, 2, 4

4) 2, 3, 5

52. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Сколько песен сложе(1)о про зиму, сколькопоэм посвяще(2)о ю(3)ой писа(4)ой

красавице в тка(5)ом жемчугами и

серебром сарафане!

1) 2, 3, 4

2) 4, 5

4

3) 2, 3, 5

4) 5

53. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Утро было безветре(1)о и румя(2)о; деревья,припороше(3)ые инеем, торжестве(4)о

сияли в лучах утре(5)его солнца.

1) 3, 4, 5

2) 1, 3, 4

3) 1, 3, 4, 5

3

4) 2, 3, 4, 5

54. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Один из аморальных принципов,подмече(1)ых, предсказа(2)ых и

разоблаче(3)ых еще Ф.М.Достоевским,

является принцип «Всё дозволе(4)о».

1) 1, 2, 3

2) 2, 3, 4

1

3) 3, 4

4) 1, 3, 4

55.

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Материальная обеспече(1)ость, лишние

В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н? Материальная обеспече(1)ость, лишниекарма(2)ые деньги, неограниче(3)ые

возможности и запросы этого конче(4)ого

раскова(5)ого молодого человека сыграли

с ним плохую шутку.

1) 1, 2, 3, 5

1

2) 2, 3, 4, 5

3) 1, 2, 3

4) 3, 4, 5

56. В каком варианте ответа правильно указаны все цифры, на месте которых пишется две буквы Н?

Свяще(1)ая обяза(2)ость нашихсоотечестве(3)иков — в самые студё(4)ые

политические годы помнить о своем

высоком назначении, предначерта(5)ом

свыше.

1) 4, 5

3

2) 1, 3, 4

3) 1, 2, 3, 5

4) 1, 2, 5

| 1. | Какое слово подходит под правило? | 1 вид — рецептивный | лёгкое |

1 Б.

|

Упражнение, проверяющее навык различения условий написания Н/НН в прилагательных. Необходимые умения: правописание Н/НН в прилагательных; владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу. |

| 2. | Вставь буквы | 1 вид — рецептивный | лёгкое | 1 Б. |

Упражнение, проверяющее навык правописания Н/НН в словах разных частей речи. Необходимые умения:

владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу.

Необходимые умения:

владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу.

|

| 3. | Правильные варианты | 2 вид — интерпретация | среднее | 2 Б. |

Упражнение, проверяющее навык правописания Н/НН в словах разных частей речи.

Необходимые умения:

владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу. ч. лексическим, морфологическим анализом, разбором слова по составу.

|

| 4. | Найди вариант с правильным указанием | 2 вид — интерпретация | среднее | 2 Б. |

Упражнение, проверяющее навык правописания Н/НН в словах разных частей речи.

Необходимые умения:

владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу.

|

| 5. | Прилагательное или причастие? | 3 вид — анализ | сложное | 4 Б. | Упражнение, проверяющее навык различения кратких отглагольных прилагательных и кратких причастий. Необходимые умения: владение различными видами анализа языковых единиц, языковых явлений и фактов, в т. ч. лексическим, морфологическим анализом, разбором слова по составу. |

6.

|

Найди наречие | 3 вид — анализ | сложное | 4 Б. | Упражнение, проверяющее навык различения наречий, кратких прилагательных и кратких причастий, а также навык правописания Н/НН в словах этих частей речи. Необходимые умения: навыки лексического, морфологического анализа, разбора слова по составу. |

презентация подготовка к егэ правописание н и нн в разных частях речи docagiv

Ссылка:http://abecomi.sabemo.ru/2/63/prezentatsiya-podgotovka-k-ege-pravopisanie-n-i-nn-v-raznyh-chastyah-rechi

. 12 советов для сочинения в ЕГЭ . Правописание Н и НН в различных частях речи. . Презентация Задание 19 ЕГЭ 2017 по русскому языку: теория и практика состоит из теоретической . Главная Школьные презентации ЕГЭ . Готовимся к ЕГЭ А12 н -нн в различных частях речи . — презентация. Практикум «Правописание Н и НН в суффиксах разных частей речи». Упражнения по теме «Правописание Н и НН в разных частях речи». Упражнение 1. Запишите прилагательные, вставляя -н- или -нн-. Образуйте от них . Предмет презентации : Русский язык Тема: Правописание Н и НН в суффиксах разных частей речи Наличие плана — конспект урока: Да. Цели урока: • формирование языковой, лингвистической и коммуникативной компетентностей при подготовке к ЕГЭ, а именно. .фонетической стороны речи для сдачи ЕГЭ по английскому языку Правописание «НЕ» с различными частями речи Обобщение по теме «НЕ с разными частями речи » Правописание корней (подготовка к ЕГЭ ) Н и НН в разных частях речи Слайды и текст этой презентации. ПОДГОТОВКА К ЕГЭ.

. 12 советов для сочинения в ЕГЭ . Правописание Н и НН в различных частях речи. . Презентация Задание 19 ЕГЭ 2017 по русскому языку: теория и практика состоит из теоретической . Главная Школьные презентации ЕГЭ . Готовимся к ЕГЭ А12 н -нн в различных частях речи . — презентация. Практикум «Правописание Н и НН в суффиксах разных частей речи». Упражнения по теме «Правописание Н и НН в разных частях речи». Упражнение 1. Запишите прилагательные, вставляя -н- или -нн-. Образуйте от них . Предмет презентации : Русский язык Тема: Правописание Н и НН в суффиксах разных частей речи Наличие плана — конспект урока: Да. Цели урока: • формирование языковой, лингвистической и коммуникативной компетентностей при подготовке к ЕГЭ, а именно. .фонетической стороны речи для сдачи ЕГЭ по английскому языку Правописание «НЕ» с различными частями речи Обобщение по теме «НЕ с разными частями речи » Правописание корней (подготовка к ЕГЭ ) Н и НН в разных частях речи Слайды и текст этой презентации. ПОДГОТОВКА К ЕГЭ. Задача учителя — подготовить обучающихся к выполнению заданий ЕГЭ. Цели: 1. . правописании Н и НН в разных частях речи. 2. . М.А., обучающая учительская презентация, индивидуальные планшеты. Подготовка к русскому языку 2017. . 12 советов для сочинения в ЕГЭ . Правописание Н и НН в различных частях речи. . Презентация Задание 19 ЕГЭ 2017 по русскому языку: теория и практика состоит из теоретической . 4 мар 2012 . Урок по теме Правописание Н и НН в суффиксах разных частей речи для 11 класса по . школ и использован при подготовке к ЕГЭ. 1 из 19. Описание презентации по отдельным слайдам Правописание Н и НН в суффиксах имен прилагательных, образованных от существительных. Система работы учителя при подготовке к ЕГЭ по русскому языку. Н-НН в прилагательных НН пишется в суффиксах: -онн-, -енн- . Презентация на тему: Правописание Н-НН в разных частях речи. Н-НН .. Подготовка к ЕГЭ Василенко О. О., учитель русского языка и литературы МОУ СОШ 15 х. Подготовка к тотальному диктанту. Правописание Н и НН в суффиксах различных частей речи.

Задача учителя — подготовить обучающихся к выполнению заданий ЕГЭ. Цели: 1. . правописании Н и НН в разных частях речи. 2. . М.А., обучающая учительская презентация, индивидуальные планшеты. Подготовка к русскому языку 2017. . 12 советов для сочинения в ЕГЭ . Правописание Н и НН в различных частях речи. . Презентация Задание 19 ЕГЭ 2017 по русскому языку: теория и практика состоит из теоретической . 4 мар 2012 . Урок по теме Правописание Н и НН в суффиксах разных частей речи для 11 класса по . школ и использован при подготовке к ЕГЭ. 1 из 19. Описание презентации по отдельным слайдам Правописание Н и НН в суффиксах имен прилагательных, образованных от существительных. Система работы учителя при подготовке к ЕГЭ по русскому языку. Н-НН в прилагательных НН пишется в суффиксах: -онн-, -енн- . Презентация на тему: Правописание Н-НН в разных частях речи. Н-НН .. Подготовка к ЕГЭ Василенко О. О., учитель русского языка и литературы МОУ СОШ 15 х. Подготовка к тотальному диктанту. Правописание Н и НН в суффиксах различных частей речи. Акимова Алла Ивановна, кандидат филологических . Презентация — Подготовка к ЕГЭ — Правописание Н и НН в разных частях речи. Учебный тренажёр и проверочный тест по теме «Правописание НЕ и НИ с разными.

Акимова Алла Ивановна, кандидат филологических . Презентация — Подготовка к ЕГЭ — Правописание Н и НН в разных частях речи. Учебный тренажёр и проверочный тест по теме «Правописание НЕ и НИ с разными.Н и НН в разных частях речи

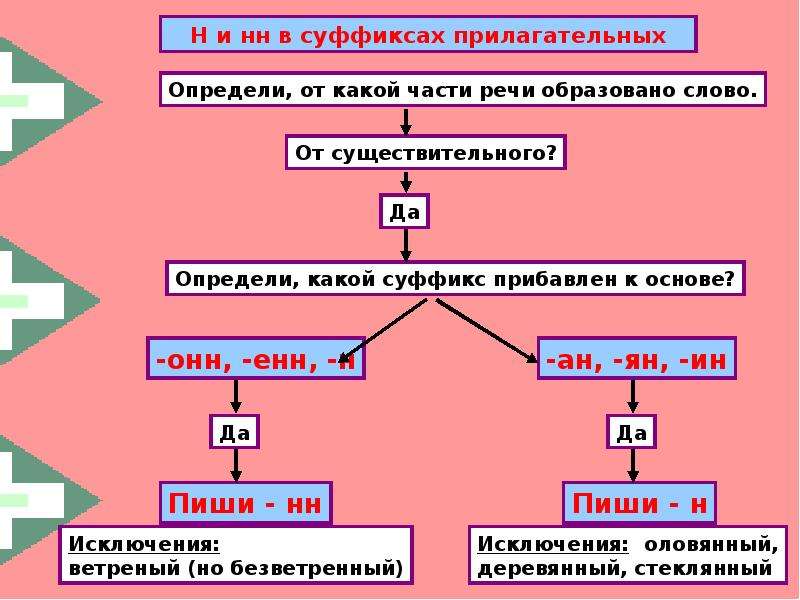

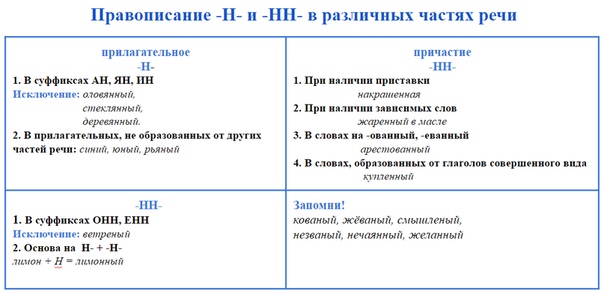

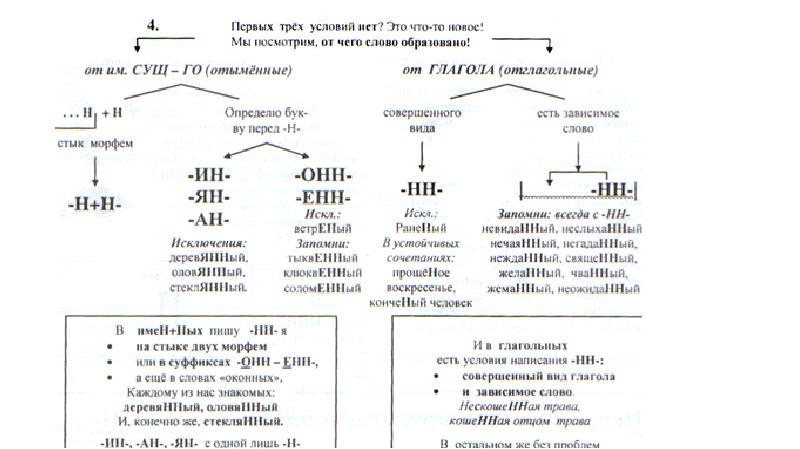

Отымённые прилагательные

Отымённые — образованные от имени. В этом случае от имени существительного.

отымённые прилагательное ← существительное

Исключения:

- Ветреный. Но, если в этом слове есть приставка, то НН: безветренный. Не путайте с «ветряно́й».

- С -янн-: оловянный, стеклянный, деревянный.

- С суффиксом j(-ий): бараний, тараканий, тюлений, пеликаний и т.д.

- Без суффикса: свин-ой ← свин. По аналогии золот-ой ← золот-о

количество Н в краткой форме = количество Н в полной

Непроизводные прилагательные

Эти прилагательные не образовывались от других слов.

непроизводное слово любой части речи ← Х

Всегда одна Н: зелёный, юный, румяный, пряный, единый, багряный (насыщенный краcный цвет), рьяный (очень усердный, ярый), буланый (одна из конских мастей).

Отглагольные прилагательные и причастия

отглагольное прилагательное или причастие ← глагол

Исключения:

- нежданный, негаданный, (не)виданный, виденный, неслыханный, читанный, слыханный, считанный, деланный, чеканный, нетленный, венчанный, обещанный, желанный.

Эти прилагательные образованы от глаголов несовершенного вида, и в них нет приставки, но они пишутся с НН. Такая особенность связана с тем, что раньше производящие глаголы этих слов были совершенного вида или двувидовыми. Например, «венчать» может отвечать на два вопроса в зависимости от контекста: «что делать» и «что сделать».

- Только в этих значениях:

- прощёное воскресенье (православный праздник), НО прощённый долг

- названый брат (не являющийся родственником, но родной в душевном и эмоциональном плане), НО названный в честь кого-то

- посажёный отец (в народном свадебном обряде у православных: мужчина, заменяющий родного отца), НО поса́женное дерево

- конченый человек (пропащий, ни на что не способный), НО конченное дело (завершённое)

- смышлёный ребёнок

- приданое невесты (субстантиви́рованное, т. е. из причастия стало существительным)

В краткой форме у причастий и отглагольных прилагательных всегда одна Н, в том числе в словах-исключениях.

Наречия

количество Н в наречии = количество Н в производящем слове

Ветреный (отымённое прилагательное, исключение) день — сегодня ветрено (наречие).

Монотонная (отымённое прилагательное, моно- + -тон- + -н-) функция — говорить монотонно (наречие).

Нежданный (причастие, исключение) гость — вернуться нежданно (наречие).

Трудные моменты:

- Существуют причастия, перешедшие в разряд прилагательных. Например, «медленный» ← «медлить», «рассеянный» (в знач. прил. «невнимательный») ← «рассеять». Выполняя задания в тренажёре, считайте эти слова причастиями.

- Слова «искусный» и «искуственный» — однокоренные. Искусный ← сущ. иску́с (продолжительная проверка на деле чьих-либо качеств; испытание).

- Есть двувидовые глаголы, они могут отвечать как на вопрос несовершенного вида (что делать?), так и совершенного (что сделать?) в зависимости от контекста. Если нет зависимого слова и приставки, то слово, образованное от двувидового глагола, считается отглагольным прилагательным и пишется с одной Н (раненый боец).

Если зависимое слово или приставка есть, то это причастие и оно пишется с НН (раненный в руку). Но не забывайте про исключения: обещать (что сделать, сов. вид) → обещанный.

Если зависимое слово или приставка есть, то это причастие и оно пишется с НН (раненный в руку). Но не забывайте про исключения: обещать (что сделать, сов. вид) → обещанный. - Не путайте паронимы (внешне схожие слова) ве́треный и ветряно́й. Ветреный — 1. сопровождаемый ветром (ветреный день) 2. (перен.) легкомысленный, непостоянный, несерьезный (ветреное поведение). Ветряной — приводимый в действие силой ветра (ветряной двигатель).

- У разносклоняемых существительных (на -мя) бремя, время, вымя, знамя, имя, пламя, племя, темя, семя, стремя прилагательные образуются с использованием суффикса -Н- и наращением -ЕН- (как в Родительном падеже: нет времени), суффикс -ЕНН- не используется. Время + -н- → врем-ен-н-ый.

РАЗРАБОТКИ | Страница 2 В категории разработок: 100 Фильтр по целевой аудитории — Целевая аудитория -для 1 классадля 2 классадля 3 классадля 4 классадля 5 классадля 6 классадля 7 классадля 8 классадля 9 классадля 10 классадля 11 классадля учителядля классного руководителядля дошкольниковдля директорадля завучейдля логопедадля психологадля соц. Данная презентация составлена к уроку повторения изученного в 5-6 классах материала по теме «Правописание букв о-ё после шипящих в разных частях речи». Работа предназначена для обучающихся 7 класса по учебнику А.Д. Шмелева. Можно использовать для работы по другому УМК. Цель ресурса: отработка навыков правописание изученных орфограмм. Задача презентации: проверить знания обучающихся по теме. В форме интерактивного теста школьники повторяют написание букв о-ё в корне слова, суффиксе и окончании.

Целевая аудитория: для 7 класса Тренажер подходит как для фронтальной, так и для индивидуальной работы на уроках русского языка в начальной школе. Цель: закрепить знания учащихся в написании слов с разделительными мягким и твердым знаками. Данный ресурс создан в программе Microsoft Office PowerPoint 2007,использован технологический прием «Волшебная труба».

Целевая аудитория: для 3 класса Данная презентация может быть использована учителем при изучении темы «Правописание суффиксов -ЧИК и -ЩИК», а также для организации самостоятельной работы обучающихся по данной теме.

Целевая аудитория: для 5 класса Интерактивный тренажёр предназначен для отработки правописания Ы-И после Ц в 5-6 классах. Может использоваться и в других классах при повторении этой темы. Пособие можно использовать для фронтальной работы на интерактивной доске, индивидуальной и групповой работы в компьютерном классе, самостоятельной работы учащихся дома и в классе для отработки навыков правописания Ы-И после Ц. Пособие содержит теоретический материал, тренировочные упражнения, контрольные тесты.

Целевая аудитория: для 5 класса Интерактивный тест состоит из 15 заданий с выбором одного варианта ответа. Ресурс предназначен для проверки умения определять количество грамматических основ в сложном предложении (ОГЭ – задание 11). В качестве дидактического материала использованы задания из пособия Т.Н. Назаровой «ОГЭ 2016. Практикум по русскому языку: подготовка к выполнению заданий 6-14» / Т.Н. Назарова, Е.Н. Скрипка. – М.: Издательство «Экзамен», 2016

Целевая аудитория: для 9 класса Ресурс представляет собой презентацию-тренажёр. Данный методический ресурс предполагает комплексную работу с текстом. Может быть использован на уроках повторения и обобщения изученного материала Целевая аудитория: обучающиеся 6-го класса. При нажатии на правильный ответ изменяется цвет слов, появляется правильная буква. Неправильный ответ исчезает.

Целевая аудитория: для 6 класса Ресурс представляет собой презентацию-тренажёр. Данный методический ресурс может быть использован на уроках повторения и обобщения изученного материала. Целевая аудитория: обучающиеся 6-го класса. При нажатии на правильный ответ изменяется цвет слов, появляется правильная буква.

Целевая аудитория: для 6 класса Данный тренажер помогает учащимся повторить правила правописания существительных и прилагательных. Если у ученика есть ошибки, ему предлагается повторить орфограммы, а затем перейти к выполнению теста, получить оценку и увидеть допущенные ошибки. Используемый УМК: Русский язык. 6 класс. Учебник для общеобразовательных учреждений. В 2 частях. М.Т. Баранов, Т.А. Ладыженская, Л.А. Тростенцова и др

Целевая аудитория: для 6 класса Интерактивный тест (на основе шаблона А. А. Баженова) для обучающихся 7-го класса «Н и НН в именах прилагательных и причастиях»

Целевая аудитория: для 7 класса Интерактивный тест (на основе шаблона А. А. Баженова) для обучающихся 5-го класса «Знаки препинания в сложносочинённом предложении»

Целевая аудитория: для 5 класса | Конкурсы Диплом и справка о публикации каждому участнику! |

Генерал Акчурин рассказал, как немец Руст уничтожил командные кадры войск ПВО СССР

СПРАВКА «МК»

Расим Сулейманович Акчурин родился 24 декабря 1931 года в поселке Зангиата Ташкентской области Узбекистана. В 1949 году поступил в Ленинградский политехнический институт имени М.И.Калинина. После 2-го курса в 1951 году призван в Советскую армию. Окончил 3-е Балтийское зенитное артиллерийское училище войск ПВО, Военную командную академию ПВО. Служил в Туркестанском военном округе, Московском округе ПВО. С 1985 года командующий зенитными ракетными войсками Войск ПВО страны. В 1992 году уволен в запас по возрасту. Родной брат известного кардиохирурга, академика Рената Акчурина, которому доверили делать операцию Борису Ельцину.

В 1949 году поступил в Ленинградский политехнический институт имени М.И.Калинина. После 2-го курса в 1951 году призван в Советскую армию. Окончил 3-е Балтийское зенитное артиллерийское училище войск ПВО, Военную командную академию ПВО. Служил в Туркестанском военном округе, Московском округе ПВО. С 1985 года командующий зенитными ракетными войсками Войск ПВО страны. В 1992 году уволен в запас по возрасту. Родной брат известного кардиохирурга, академика Рената Акчурина, которому доверили делать операцию Борису Ельцину.

— Вот вы возглавляли зенитные ракетные войска советской сверхдержавы. А могли бы сравнить возможности Войск ПВО СССР и современной ПВО России. Мы хоть приближаемся к тому уровню, который был?

— Я, конечно, слежу за тем, как развивается техника ПВО, в курсе новинок: С-350, С-400, С-500. Но количественного состава зенитных комплексов, разумеется, не знаю — уже не положено. Когда командовал зенитными ракетными войсками страны, в их составе было более 240 зенитных ракетных полков и бригад. Это внушительная цифра. Причем в каждой бригаде было по 12–16 зенитных ракетных дивизионов. Это были мощные бригады, оснащенные зенитно-ракетной техникой различного типа. И огневая плотность была большая. В случае нападения противника вероятность уничтожения его средств очень высокая.

Это внушительная цифра. Причем в каждой бригаде было по 12–16 зенитных ракетных дивизионов. Это были мощные бригады, оснащенные зенитно-ракетной техникой различного типа. И огневая плотность была большая. В случае нападения противника вероятность уничтожения его средств очень высокая.

Мне есть с чем сравнивать. Я начинал службу в 1954 году лейтенантом в зенитной артиллерийской части. Мы прикрывали урановый комбинат в Киргизии, возле городка Майли-Сай. Один отдельный зенитный артиллерийский дивизион стоял на входе в ущелье, в котором располагались этот комбинат и урановые шахты, а второй — на выходе.

Начальником комбината был генерал-майор Данилин. Я даже фамилию его помню, потому что при мне, лейтенанте, мой командир части Бочков часто произносил эту фамилию. И как-то командир ставит задачу дивизионам: «Вот звонил Данилин сейчас. Если полетит американский «Бостон», то сбить…». Дальше военно-матерным языком, чтобы было понятно, как именно сбить.

Он, вообще-то, был артиллеристом, иконостас фронтовых орденов — во всю грудь. Очень заслуженный подполковник.

Очень заслуженный подполковник.

СПРАВКА «МК»

Самолет «Дуглас», или «Бостон», со времен Второй мировой войны стоял на вооружении ВВС США, Великобритании, СССР. По лендлизу в СССР было поставлено более 3000 таких самолетов разных модификаций.

Расим Акчурин, экс-командующий зенитными ракетными силами Войск ПВО СССР. Фото: Из личного архиваАмериканские самолеты в то время, пользуясь тем, что зенитных ракет у нас еще не было, а зенитные пушки до высотных целей достать не могли, часто совершали разведывательные полеты над территорией СССР. Особенно интересовались, конечно, ядерными объектами. Конец такой практике положили только зенитные ракеты, которыми 1 мая 1960 года был сбит над Свердловском самолет U-2 с американским летчиком Пауэрсом.

Мы, конечно, изготовились. Ждем. Летит «Бостон». Открыли огонь из 16 зенитных орудий двух батарей. Море огня. По теории вероятности, на уничтожение одного самолета надо выпустить до 600–800 зенитно-артиллерийских снарядов. Я командовал своим взводом. Видел, что самолет резко маневрировал то вниз, то вверх. Пилот, видимо, сильный был. Понял, что по нему стреляют. И ушел. Мы не сбили его.

Море огня. По теории вероятности, на уничтожение одного самолета надо выпустить до 600–800 зенитно-артиллерийских снарядов. Я командовал своим взводом. Видел, что самолет резко маневрировал то вниз, то вверх. Пилот, видимо, сильный был. Понял, что по нему стреляют. И ушел. Мы не сбили его.

Командир части Бочков приехал, выставил строй офицеров и говорит: «Солдаты тут ни при чем. Вы не научили их воевать». И как пошел чистить! Всем досталось. Особенно прибористам. Сказал: «В боевой обстановке я бы вас расстрелял, можете не сомневаться, но сейчас другая обстановка».

А на следующий день мы узнаем, что это был… наш самолет аэрофоторазведки. Он просто без заявки летал над ущельем, фотографировал урановый комбинат. Так что ему повезло, что мы мазилами оказались.

Это я к тому, насколько возможности противовоздушной обороны выросли, когда у нас на вооружении появились зенитные управляемые ракеты. Это доказано было на Пауэрсе.

— В советское время ваши войска учились отражать массированные налеты авиации противника?

— А вы как думаете? Конечно. Причем воевали, как говорится, насмерть с нашими же авиаторами, которые выступали в роли противника.

Причем воевали, как говорится, насмерть с нашими же авиаторами, которые выступали в роли противника.

Во время командования войсками я много учений проводил. Жизнь проходила больше на полигонах. Это Сары-Шаган в Казахстане, Ашулук в Астраханской области. Все зенитные комплексы дальнего действия работали обычно с Сары-Шагана, а на Ашулуке работали комплексы С-75, С-125.

Служба проходила на полигонах. Генерал Расим Акчурин (в центре) принимает доклады подчиненных. Фото: Из личного архиваОбычно проводили совместные учения с дальней авиацией. Они — нападающие, запускают крылатые ракеты. И стараются нас всячески принизить. Это просто болезнь такая была. До того загрубят чувствительность автопилотов, что крылатые ракеты не то что огибают рельеф местности, а утыкаются в холмы.

Помню, Петр Дейнекин — он тогда был заместителем командующего дальней авиацией — организовывал в Сары-Шагане такую атаку. Мои ракетчики готовы, ждут — и все впустую: все крылатые ракеты в бугор уперлись. Мы ни одной ракеты не пускали, а целей нет, к объекту не прошли.

Мои ракетчики готовы, ждут — и все впустую: все крылатые ракеты в бугор уперлись. Мы ни одной ракеты не пускали, а целей нет, к объекту не прошли.

СПРАВКА «МК»

Петр Степанович Дейнекин, командующий дальней авиацией ВВС СССР (1988–1990), главком ВВС СССР (1991), главком ВВС РФ (1992–1998), Герой России, генерал армии. Под его руководством на аэродромах была уничтожена дудаевская военная авиация Ичкерии.

И тут начинается перетягивание канатов: кто виноват, что делать! Это было ужасно. Я уже командовал зенитными ракетными войсками ПВО страны. Говорю Дейнекину: «Петя …, ты что творишь?»

Дальше — решение главковерха: проводить учение повторно. Тут уже авиаторы не рисковали, задали реальные параметры полета ракет. И все крылатые ракеты были положены на землю системой С-300.

Я же предварительно пролетел на вертолете весь полигон. Все маршруты посмотрел: где поставить ракетные дивизионы, где могут пойти крылатые ракеты. И спасибо вертолетчикам, они помогли мне. Я расставил силы так, что крылатые ракеты не прошли.

Я расставил силы так, что крылатые ракеты не прошли.

Тут Дейнекин мне говорит: «Слушай, не торопись докладывать своему Колдунову (главком Войск ПВО страны, Главный маршал авиации Александр Колдунов. — «МК»), потому что он обязательно позвонит моему главкому Кутахову (главком ВВС, Главный маршал авиации Павел Кутахов. — «МК») — и все! Пойдет шум страшный. Я тебя очень прошу».

Я говорю: ладно, как сотоварищ, до вечера не буду докладывать, а вечером — если будет в кабинете, доложу. Если нет — то уже завтра. И тут уже бедный Дейнекин ходил, соображал, как доложить Кутахову, чтобы не очень попало. Так мы с ним в Сары-Шагане мучились.

Понятно, что в целом общее дело выигрывало. Противостояние зенитчиков и авиаторов было только на пользу обороне. У СССР были сильнейшая ПВО и сильнейшая авиация. Но ревность была жуткая…

Работа с молодежью — главная забота советов ветеранов. Фото: Из личного архива— Да, но потом были развал Союза и армии. .. Какие чувства испытывали, когда видели, что огромная система ПВО — многоэшелонированная, со всеми радиолокационными полями — рушилась? Что чувствовали?

.. Какие чувства испытывали, когда видели, что огромная система ПВО — многоэшелонированная, со всеми радиолокационными полями — рушилась? Что чувствовали?

— Ужасно было обидно. Мы даже в плохом сне не могли допустить, что все так будет. Меня часто родные потом упрекали: вы, военные, должны были подняться, поднять голову. Но я не допускал, что до такого дойдет. Я был уверен в силе Центрального комитета Коммунистической партии Советского Союза.

В августе 1991 года при мне разговаривал Третьяк (замминистра обороны СССР, главком Войск ПВО. — «МК») с Язовым (министр обороны СССР при Горбачеве маршал Дмитрий Язов. — «МК») и говорил: «Что вы творите? Вы же власть! Решительнее надо».

Этот разговор был в присутствии всех членов военного совета Войск ПВО. Начальник политуправления Войск ПВО тоже по телефону предлагал министру: введите танки, арестуйте всех, вам будет благодарность людей.

Никто не мог предположить такой масштаб предательства и безответственности.

— А перед этим же еще была эпопея с самолетом Руста. Что тогда произошло?

— Скажу грубо: Руст бы яйца свои не нашел, если бы решительнее были некоторые командиры ПВО. Я в тот день был в составе комиссии главкома Войск ПВО, проверял как раз Таллиннскую дивизию ПВО по итогам зимнего периода обучения.

СПРАВКА «МК»

Матиас Руст — немецкий пилот-любитель. В возрасте 18 лет перелетел на легкомоторном самолете «Цессна» из Гамбурга через Хельсинки в Москву. 28 мая 1987 года (День пограничных войск СССР) приземлился на Большом Москворецком мосту. Был обвинен судом в хулиганстве и приговорен к четырем годам лишения свободы. В 1988 году освобожден по амнистии, вернулся в ФРГ. Полет Руста привел к массовым отставкам советского военного руководства.

Утром меня встречает командир дивизии и говорит: вот такая история произошла вчера вечером. Говорю: подожди, почему вечером не доложили? «Ну вот, товарищ командующий, я как-то не придал этому значения». Представляете?!

Представляете?!

После доклада командира дивизии я выехал в дивизионы, которые сопровождали нарушителя.

Сопровождали Руста! Зенитная система С-200 сопровождала и С-125. От него бы ничего не осталось. Одной ракетой бы его сбили. И попадание было бы точное! Абсолютно!

Я разобрался с материалами объективного контроля, показавшими беспровальное сопровождение нарушителя и готовность к уничтожению «гостя».

Спрашиваю командира дивизиона: «Почему не открывали огня?» — «А команды не было, товарищ командующий». — «Подожди, — говорю, — ты представь, что враг летит, ты же сопровождаешь его, видишь, что на сигнал «свой-чужой» не отвечает! Как же ты можешь? Ты же командир огня! Понимаешь?» — «Команды не было, и по легкомоторным самолетам открывать огонь мы не имеем права».

Вот такой примитивный доклад в одном дивизионе. Может, и подготовил его командир дивизии так говорить — не знаю. Но, короче говоря, были два дивизиона, через которые самолет Руста прошел, как говорится, с нулевым параметром. Там была стопроцентная вероятность уничтожения нарушителя. Полностью! И никто бы даже шума не поднял! Ну сбили и сбили.

Там была стопроцентная вероятность уничтожения нарушителя. Полностью! И никто бы даже шума не поднял! Ну сбили и сбили.

— Что ж это было — бардак перестроечный, расслабленность или горбачевская эйфория — «мир, дружба, жвачка»?

— Не знаю, может, все вместе. Как мне потом рассказывали, генерал в главкомате Войск ПВО, которому первому доложили, что легкомоторная «Цессна» летит, умнее ничего не придумал, как сказать: «Вы разберитесь, может, это гуси летят?».

Как могут гуси с севера лететь на юг? Май месяц — гуси летят с юга на север!

Вместо того чтобы спуститься на центральный командный пункт Войск ПВО и там разбираться на месте, он эту «утку» выдал всем командным пунктам — 6-й отдельной армии ПВО, Московскому округу ПВО. Два кольца комплексов С-300 было вокруг столицы.

Короче говоря, прошляпили. Один истребитель только видел, и он доложил четко, что это легкомоторный самолет типа «Цессна». Но ему было приказано сесть. Если бы оперативный дежурный без боязни доложил не случайному генералу, а главнокомандующему Войск ПВО, как это ему положено было сделать, главком бы спустился на ЦКП и принял бы решение либо к принуждению к посадке этого самолета, либо к его уничтожению! Решительность Главного маршала авиации Александра Ивановича Колдунова была известна еще со времен Великой Отечественной. В 1945 году он был уже дважды Героем Советского Союза.

В 1945 году он был уже дважды Героем Советского Союза.

— Многих генералов сняли?

— Сильно подкосили командный состав Войск ПВО. Снято с должности было очень много генералов. Из членов военного совета Войск ПВО страны остался я и начальник штаба, который был в момент ЧП в отпуске. Кстати, того генерала, который запустил версию про стаю гусей, повысили. Вроде бы он был земляком Горбачева, чуть ли не с одной улицы с ним.

Был снят главком Войск ПВО главный маршал авиации Колдунов. Он в тот день был уже дома, а в это время звонок — Руст на Красной площади. Представляете его состояние? Я был у него примерно через год после отставки. Министр обороны поручил его поздравить с днем рождения. Под 9 мая он родился. Я ездил его поздравлять. Он уже был без одной ноги. У него был диабет, и на нервной почве он развился бурно. Потом и вторую ногу отрезали, и он умер. Достойный военачальник. А все из-за Руста.

— После 1991 года вы не захотели служить дальше?

— В 1991 году я написал рапорт на увольнение. Меня пригласил на заседание высшей аттестационной комиссии секретарь Совета безопасности Юрий Владимирович Скоков. Хороший человек был. Беседа была очень долгой. Просили остаться, помочь наладить систему. Но я сказал: «Нет, я не хочу быть при развале Войск ПВО, который начался!».

Меня пригласил на заседание высшей аттестационной комиссии секретарь Совета безопасности Юрий Владимирович Скоков. Хороший человек был. Беседа была очень долгой. Просили остаться, помочь наладить систему. Но я сказал: «Нет, я не хочу быть при развале Войск ПВО, который начался!».

Вот такой простой пример. Скажем, дальневосточное направление у меня прикрывало более 180 зенитных ракетных дивизионов. Осталось 18! Представляете, в десять раз сократить активный род войск — зенитные ракетные войска! Понятно, что ракетные комплексы без эксплуатации, в режиме хранения, теряют свои боевые качества.

Все это было тяжелым ударом и для зенитных ракетных войск, да и в целом Войск ПВО.

— Как вам боевые возможности современных комплексов ПВО?

— Это удивительно! Высота обнаружения целей до 500 километров. Это же вообще немыслимо! Дальность обнаружения воздушных целей увеличилась, уже не говоря об огневых возможностях. И, наверное, правильно делают, что уходят от старой системы управления. Она все-таки свое отслужила и сейчас никак не может действовать эффективно. Мне рассказывали, сколько зенитных ракетных полков могут быть объединены в одну систему. Вы не представляете, какая это мощь под единым управлением. Это легко сказать, но представляю, как трудно было сделать ученым, конструкторам. Это правильно, что президент, военное руководство противоракетной обороне столько внимания уделяют, развитию зенитных ракетных войск.

И, наверное, правильно делают, что уходят от старой системы управления. Она все-таки свое отслужила и сейчас никак не может действовать эффективно. Мне рассказывали, сколько зенитных ракетных полков могут быть объединены в одну систему. Вы не представляете, какая это мощь под единым управлением. Это легко сказать, но представляю, как трудно было сделать ученым, конструкторам. Это правильно, что президент, военное руководство противоракетной обороне столько внимания уделяют, развитию зенитных ракетных войск.

— А если бы довелось с президентом встретиться, что бы покритиковали?

— Да хоть учебники истории. Недавно в нашем совете ветеранов я проводил семинар с людьми, которые возглавляют систему пропаганды в окружных ветеранских организациях. Обсуждали как раз отношение к истории Великой Отечественной войны. И опять ругали школьные учебники, в которых о Сталинградской битве несколько строк только напечатано. Многие вещи даже не перечислены. История — мертвая! И ведь Владимиру Владимировичу Путину уже на каком-то совещании об этом говорили. А ничего же не изменилось.

А ничего же не изменилось.

Почему-то сбой происходит в системе исполнения. Надо, чтобы прислушивались к мнению ветеранских организаций. Мы же не критиканством занимаемся. Мы хотим, чтобы Россия была мощной страной, великим государством.

Ну и, конечно, считаю, что войска воздушно-космической обороны должны быть самостоятельным видом Вооруженных сил. И его надо развивать. Надо систему ПВО укреплять. Это система сохранения государства, не говорю уже о городах или важных объектах.

Вспомните Великую Отечественную, 1941 год. Тогда Сталин все сделал, чтобы вокруг Москвы создали непреодолимую систему ПВО. Мощная система зенитного огня была создана, истребительная авиация, зенитная артиллерия, аэростаты заграждения, маскировка. Да, некоторые немецкие самолеты прорывались. Но это не идет ни в какое сравнение, например, с тем, какой ущерб немецкая авиация нанесла английским городам или с последствиями бомбардировок союзников по немецким городам. Надо помнить уроки истории!

Оптимизация имитатора в реальном времени на основе рекуррентных нейронных сетей для прогнозирования переходных процессов компрессора | J.

Turbomach.

Turbomach. В этой статье изучаются и разрабатываются рекуррентные нейронные сети с прямой связью (RNN) с одним скрытым слоем, обученные с использованием алгоритма обучения с обратным распространением, для моделирования поведения компрессора в нестационарных условиях. Данные, используемые для обучения и тестирования RNN, получены с помощью модели на основе нелинейной физики для динамического моделирования компрессора (смоделированные данные) и измерены на многоступенчатом аксиально-центробежном малогабаритном компрессоре (полевые данные).Анализ смоделированных данных связан с оценкой влияния количества обучающих шаблонов и каждого входа RNN на отклик модели как для данных, не поврежденных, так и для данных, поврежденных ошибками измерения, для различных конфигураций RNN и различных значений общей задержки. время. Для моделей RNN, обученных непосредственно на экспериментальных данных, анализ влияния входной комбинации RNN на отклик модели повторяется, как и для моделей, обученных на имитированных данных, чтобы оценить динамическое поведение реальной системы. Затем разрабатываются RNN-предикторы (то есть те, которые не включают среди входов экзогенные входы, оцениваемые на том же временном шаге, что и выходной вектор), и проводится обсуждение их возможностей. Анализ смоделированных данных привел к выводу, что для улучшения характеристик RNN выгодно использовать RNN с одноразовой задержкой, с как можно меньшим общим временем задержки (в этой статье 0,1 с) и тренировались с максимально возможным количеством тренировочных шаблонов (не менее 500).Анализ влияния каждого входа на ответ RNN, проведенный для моделей RNN, обученных на полевых данных, показал, что предсказатель на один шаг вперед RNN обеспечивает очень хорошую производительность, сравнимую с характеристиками моделей RNN со всеми входами (общая ошибка для каждого единый расчет равен 1,3% и 0,9% для двух рассмотренных тестовых случаев). Более того, анализ возможностей многошагового предсказателя показал, что сокращение количества вычислений RNN является ключевым фактором для повышения его производительности на значительном временном горизонте.

Затем разрабатываются RNN-предикторы (то есть те, которые не включают среди входов экзогенные входы, оцениваемые на том же временном шаге, что и выходной вектор), и проводится обсуждение их возможностей. Анализ смоделированных данных привел к выводу, что для улучшения характеристик RNN выгодно использовать RNN с одноразовой задержкой, с как можно меньшим общим временем задержки (в этой статье 0,1 с) и тренировались с максимально возможным количеством тренировочных шаблонов (не менее 500).Анализ влияния каждого входа на ответ RNN, проведенный для моделей RNN, обученных на полевых данных, показал, что предсказатель на один шаг вперед RNN обеспечивает очень хорошую производительность, сравнимую с характеристиками моделей RNN со всеми входами (общая ошибка для каждого единый расчет равен 1,3% и 0,9% для двух рассмотренных тестовых случаев). Более того, анализ возможностей многошагового предсказателя показал, что сокращение количества вычислений RNN является ключевым фактором для повышения его производительности на значительном временном горизонте. Фактически, когда выбрано высокое время выборки тестовых данных (в этой статье 0,24 с), ошибки предсказания были приемлемыми (менее 1,9%).

Фактически, когда выбрано высокое время выборки тестовых данных (в этой статье 0,24 с), ошибки предсказания были приемлемыми (менее 1,9%).

Приложения и алгоритмы искусственных нейронных сетей

Что такое искусственная нейронная сеть?

Искусственные нейронные сети — это вычислительные модели, созданные человеческим мозгом. Многие из недавних достижений были сделаны в области искусственного интеллекта, включая распознавание голоса, распознавание изображений, робототехнику с использованием искусственных нейронных сетей.Искусственные нейронные сети — это моделирование, основанное на биологической природе, выполняемое на компьютере для выполнения определенных конкретных задач, таких как: Искусственные нейронные сети, в целом — — это биологически вдохновленная сеть искусственных нейронов, сконфигурированных для выполнения определенных задач. Эти биологические методы вычислений известны как следующее крупное достижение в компьютерной индустрии.Что такое нейронная сеть?

Термин «нейронный» происходит от основной функциональной единицы нервной системы человека (животного) «нейрон» или нервных клеток, присутствующих в головном мозге и других частях тела человека (животного). Нейронная сеть — это группа алгоритмов, которые удостоверяют основную взаимосвязь в наборе данных, аналогичных человеческому мозгу. Нейронная сеть помогает изменить ввод так, чтобы сеть давала лучший результат без изменения процедуры вывода. Вы также можете узнать больше о ONNX в этом обзоре.

Нейронная сеть — это группа алгоритмов, которые удостоверяют основную взаимосвязь в наборе данных, аналогичных человеческому мозгу. Нейронная сеть помогает изменить ввод так, чтобы сеть давала лучший результат без изменения процедуры вывода. Вы также можете узнать больше о ONNX в этом обзоре.Части нейрона и их функции

Типичная нервная клетка человеческого мозга состоит из четырех частей: Он получает сигналы от других нейронов. Он суммирует все входящие сигналы для генерации входных данных.Когда сумма достигает порогового значения, нейрон срабатывает, и сигнал проходит по аксону к другим нейронам. Точка соединения одного нейрона с другими нейронами. Количество передаваемого сигнала зависит от силы (синаптического веса) соединений. Связи могут быть тормозящими (уменьшение силы) или возбуждающими (увеличение силы) по своей природе. Итак, нейронная сеть, как правило, имеет связанную сеть из миллиардов нейронов с триллионом взаимосвязей между ними.В чем разница между компьютером и человеческим мозгом?

Искусственные нейронные сети (ИНС) и биологические нейронные сети (BNN) — Разница

| Характеристики | Искусственная нейронная сеть | Биологическая (реальная) нейронная сеть |

| Скорость | Более быстрая обработка информации. Время отклика в наносекундах. Время отклика в наносекундах. | Медленнее обрабатывает информацию.Время ответа в миллисекундах. |

| Обработка | Последовательная обработка. | Массивно-параллельная обработка. |

| Размер и сложность | Меньше размера и сложности. Он не выполняет сложных задач распознавания образов. | Очень сложная и плотная сеть взаимосвязанных нейронов, содержащая нейроны порядка 1011 с 1015 взаимосвязями. |

| Склад | Хранилище информации заменяемое — это замена новых данных на старые. | Очень сложная и плотная сеть взаимосвязанных нейронов, содержащая нейроны порядка 1011 с 1015 взаимосвязями. |

| Отказоустойчивость | Отказоустойчивый. Поврежденная информация не может быть восстановлена в случае отказа системы. | Хранилище информации является адаптируемым, что означает добавление новой информации путем корректировки силы межсоединений без уничтожения старой информации. |

| Механизм управления | Есть блок управления вычислительной деятельностью | Нет специального механизма управления, внешнего по отношению к вычислительной задаче. |

Искусственные нейронные сети с биологической нейронной сетью — подобие

Нейронные сети напоминают человеческий мозг двумя способами:- Нейронная сеть приобретает знания в процессе обучения.

- Знания нейронной сети — это запас прочности межнейронных связей, известный как синаптические веса.

ВЫЧИСЛЕНИЯ НА ОСНОВЕ АРХИТЕКТУРЫ ФОН НЕЙМАНА | ВЫЧИСЛЕНИЯ НА ОСНОВЕ ИНН |

| Последовательная обработка — инструкция обработки и проблема, правило по одному (последовательное) | Параллельная обработка — несколько процессоров работают одновременно (многозадачность) |

| Функционирование логически с набором правил if и else — подход на основе правил | Функция путем обучения шаблону на заданном входе (изображение, текст, видео и т. Д.)) Д.)) |

| Программируется языками более высокого уровня, такими как C, Java, C ++ и т. Д. | ИНС — это, по сути, сама программа. |

| Требуются либо большие, либо подверженные ошибкам параллельные процессоры | Использование специализированных мультичипов. |

Искусственная нейронная сеть (ИНС) с биологической нейронной сетью (BNN) — Сравнение

- Дендриты биологической нейронной сети аналогичны взвешенным входам, основанным на их синаптических взаимосвязях в искусственной нейронной сети.

- Тело клетки сравнимо с блоком искусственного нейрона в искусственной нейронной сети, состоящим из блока суммирования и порогового значения.

- Axon передает вывод, который аналогичен блоку вывода в случае искусственной нейронной сети. Итак, ИНС — это модель, использующая работу основных биологических нейронов.

Как работает искусственная нейронная сеть?

- Искусственные нейронные сети можно рассматривать как взвешенные ориентированные графы, в которых искусственные нейроны являются узлами, а направленные ребра с весами являются связями между выходами нейронов и входами нейронов.

- Искусственная нейронная сеть получает информацию из внешнего мира в виде рисунков и изображений в векторной форме. Эти входы обозначаются обозначением x (n) для количества входов n.

- Каждый вход умножается на соответствующие веса. Веса — это информация, используемая нейронной сетью для решения проблемы. Обычно вес представляет собой силу взаимосвязи между нейронами внутри нейронной сети.

- Все взвешенные входные данные суммируются внутри вычислительного блока (искусственного нейрона).В случае, если взвешенная сумма равна нулю, добавляется смещение, чтобы выходной сигнал не был нулевым, или для увеличения отклика системы. У смещения вес и вход всегда равны «1».

- Сумма соответствует любому числовому значению от 0 до бесконечности. Чтобы ограничить отклик для достижения желаемого значения, устанавливается пороговое значение. Для этого сумма пересылается через функцию активации.

- Функция активации настроена на передаточную функцию для получения желаемого результата.

Существуют как линейные, так и нелинейные функции активации.

Существуют как линейные, так и нелинейные функции активации.

Какие функции активации обычно используются?

Некоторые из часто используемых функций активации — это бинарные, сигмоидальные (линейные) и желтовато-гиперболические сигмоидальные функции (нелинейные).- Двоичный — Выход имеет только два значения, либо 0, либо 1. Для этого устанавливается пороговое значение. Если чистый взвешенный вход больше 1, выход считается равным единице, в противном случае — нулю.

- Сигмоидальный гиперболический — Эта функция имеет S-образную кривую.Здесь гиперболическая функция tan используется для аппроксимации выпуска от чистого входа. Функция определяется как — f (x) = (1/1 + exp (- ???? x)), где ???? — параметр крутизны.

Щелкните, чтобы прочитать около Обзор искусственного интеллекта и роли НЛП в больших данных

Типы нейронных сетей в искусственном интеллекте

| Параметр | Типы | Описание |

| По схеме подключения | FeedForward, рекуррентный | Feedforward — в графиках нет циклов. Recurrent — Зацикливание происходит из-за обратной связи. Recurrent — Зацикливание происходит из-за обратной связи. |

| По количеству скрытых слоев | Однослойный, Многослойный | Однослойный — Имеет один секретный слой. Например, Single Perceptron Multilayer — Имеет несколько секретных слоев. Многослойный персептрон |

| По характеру весов | Фиксированный, Адаптивный | Фиксированный — Вес имеет фиксированный приоритет и не изменяется вообще. Adaptive — Обновляет веса и изменения во время тренировки. |

| На основе блока памяти | Статический, динамический | Статический — Блок без памяти. Текущий выход зависит от текущего входа. Например, сеть прямого распространения. Dynamic — Блок памяти — Выход зависит как от токового входа, так и от токового выхода. Например, рекуррентная нейронная сеть |

Типы архитектуры нейронной сети

Модель персептрона в нейронных сетях

Они также известны как «однослойные перцептроны».

Они также известны как «однослойные перцептроны».Нейронная сеть с радиальной базисной функцией

Многослойная нейронная сеть персептрона

Нейронная сеть с кратковременной памятью (LSTM)

Сеть обучается с помощью входных шаблонов, устанавливая для нейронов желаемый шаблон. Затем вычисляются его веса. Вес не изменился. После обучения одному или нескольким шаблонам сеть сходится к изученным шаблонам. Он отличается от других нейронных сетей.

Сеть обучается с помощью входных шаблонов, устанавливая для нейронов желаемый шаблон. Затем вычисляются его веса. Вес не изменился. После обучения одному или нескольким шаблонам сеть сходится к изученным шаблонам. Он отличается от других нейронных сетей.Машинная нейронная сеть Больцмана

Сверточная нейронная сеть

В этом типе искусственной нейронной сети для имитации синапса используется электрически регулируемый материал сопротивления, а не программное моделирование, выполняемое в нейронной сети.

В этом типе искусственной нейронной сети для имитации синапса используется электрически регулируемый материал сопротивления, а не программное моделирование, выполняемое в нейронной сети.Щелкните, чтобы изучить Генеративные состязательные сети

Аппаратная архитектура для нейронных сетей

Для реализации оборудования для нейронных сетей используются два типа методов.- Программное обеспечение для моделирования на обычном компьютере

- Специальное аппаратное решение для уменьшения времени выполнения.

д. края нейронной сети.В то время как производительность алгоритма обучения измеряется в количестве обновлений соединения в секунду (чашки)

д. края нейронной сети.В то время как производительность алгоритма обучения измеряется в количестве обновлений соединения в секунду (чашки)Методы обучения в искусственных нейронных сетях

Нейронная сеть обучается, итеративно регулируя свои веса и смещение (порог), чтобы получить желаемый результат. Их также называют свободными параметрами. Чтобы обучение происходило, сначала обучается нейронная сеть. Обучение выполняется с использованием определенного набора правил, также известного как алгоритм обучения.Алгоритмы обучения искусственных нейронных сетей

Алгоритм градиентного спуска

Алгоритм обратного распространения

Здесь, после обнаружения ошибки (разницы между желаемым и целевым), ошибка распространяется в обратном направлении от выходного слоя к входному через скрытый слой.Он используется в случае многослойной нейронной сети.

Здесь, после обнаружения ошибки (разницы между желаемым и целевым), ошибка распространяется в обратном направлении от выходного слоя к входному через скрытый слой.Он используется в случае многослойной нейронной сети.Наборы обучающих данных в искусственных нейронных сетях

Набор примеров, используемых для обучения, соответствует параметрам [т. Е. Весам] сети. Один подход включает один полный цикл тренировки на тренировочной выборке. Набор примеров, используемых для настройки параметров [т. Е. Архитектуры] сети. Например, чтобы выбрать количество скрытых блоков в нейронной сети. Набор примеров используется только для оценки производительности [обобщения] полностью определенной сети или успешно применяется для прогнозирования выходных данных, входные данные которых известны.Подробнее о Лучшие практики и платформы Capsule Networks

Пять алгоритмов для обучения нейронной сети

- Правило обучения на языке хебби

- Правило Кохонена с самоорганизацией

- Закон о сети Хопфилда

- Алгоритм LMS (наименьший средний квадрат)

- Конкурсное обучение

Архитектура искусственной нейронной сети

Типичная нейронная сеть содержит большое количество искусственных нейронов, называемых единицами, расположенными в серии слоев. Типичная искусственная нейронная сеть состоит из разных слоев —

Типичная искусственная нейронная сеть состоит из разных слоев —- Входной уровень — Он содержит те блоки (искусственные нейроны), которые получают входные данные из внешнего мира, на которых сеть будет учиться, распознавать или иным образом обрабатывать.

- Выходной слой — Он содержит блоки, которые реагируют на информацию о том, как он изучает какую-либо задачу.

- Скрытый слой — Эти блоки находятся между входным и выходным слоями. Задача скрытого слоя — преобразовать ввод во что-то, что блок вывода может каким-то образом использовать.

Методы обучения в нейронных сетях

В этом обучении данные обучения вводятся в сеть, и желаемый результат известен, веса корректируются до тех пор, пока производство не даст желаемое значение. Используйте входные данные для обучения сети, выход которой известен. Сеть классифицирует входные данные и корректирует вес путем извлечения признаков во входных данных.Здесь выходное значение неизвестно, но сеть предоставляет обратную связь о том, является ли выход правильным или неправильным. Это полу-контролируемое обучение. Регулировка вектора весов и корректировка пороговых значений выполняются только после того, как обучающий набор показан в сети. Это также называется пакетным обучением. Регулировка веса и порога выполняется после представления каждой обучающей выборки в сеть.

Используйте входные данные для обучения сети, выход которой известен. Сеть классифицирует входные данные и корректирует вес путем извлечения признаков во входных данных.Здесь выходное значение неизвестно, но сеть предоставляет обратную связь о том, является ли выход правильным или неправильным. Это полу-контролируемое обучение. Регулировка вектора весов и корректировка пороговых значений выполняются только после того, как обучающий набор показан в сети. Это также называется пакетным обучением. Регулировка веса и порога выполняется после представления каждой обучающей выборки в сеть.Обучение и развитие в нейронных сетях

Обучение происходит, когда веса внутри сети обновляются после многих итераций.Например, предположим, что у нас есть входные данные в виде шаблонов для двух разных классов шаблонов — I & 0, как показано, и b-bias и y в качестве желаемого результата.Узор | y | x1 | x2 | x3 | x4 | x5 | x6 | x7 | x8 | x9 | b |

I | 1 | 1 | 1 | 1 | -1 | 1 | -1 | 1 | 1 | 1 | 1 |

O | -1 | 1 | 1 | 1 | 1 | -1 | 1 | 1 | 1 | 1 | 1 |

‘Ниже приведены выполняемые шаги:

‘Ниже приведены выполняемые шаги:- Девять входов от x1 — x9 и смещения b (вход со значением веса 1) подаются в сеть для первого шаблона.

- Первоначально веса сбрасываются на ноль.

- Затем веса обновляются для каждого нейрона по формулам: Δ wi = xi y для i = от 1 до 9 (правило Хебба)

- Наконец, новые веса находятся по формулам:

- wi (новый) = wi (старый) + Δwi

- Wi (новый) = [111-11-1 1111]

- Второй шаблон вводится в сеть.На этот раз веса не обнуляются. Используемые здесь начальные веса — это окончательные веса, полученные после представления первого шаблона. Таким образом, network.

- Шаги с 1 по 4 повторяются для вторых входов.

- Новые веса: Wi (новый) = [0 0 0 -2 -2 -2 000]

Какие 4 различных метода создания нейронных сетей?

Классификация нейронной сети

Он использует сети прямого распространения.

Он использует сети прямого распространения.Нейронная сеть прогнозирования

Кластеризация нейронной сети

- Конкурентные сети

- Сети теории адаптивного резонанса

- Самоорганизующиеся карты Кохонена.

Ассоциация нейронных сетей

Нейронные сети для распознавания образов

Распознавание образов — это исследование того, как машины могут наблюдать за окружающей средой, учиться отличать представляющие интерес закономерности от их фона и принимать обоснованные и разумные решения относительно категорий образов. Некоторые примеры шаблона: изображения отпечатков пальцев, рукописное слово, человеческое лицо или речевой сигнал. Учитывая шаблон ввода, его распознавание включает в себя следующую задачу:

Некоторые примеры шаблона: изображения отпечатков пальцев, рукописное слово, человеческое лицо или речевой сигнал. Учитывая шаблон ввода, его распознавание включает в себя следующую задачу:- Контролируемая классификация — Данный входной шаблон известен как член предопределенного класса.

- Неконтролируемая классификация — Назначить шаблон неизвестному до сих пор классу.

- Сбор и предварительная обработка данных

- Представление данных

- Принятие решений

Подходы к распознаванию образов

- Соответствие шаблона

- Статистический

- Синтаксическое сопоставление

- Искусственные нейронные сети

- Многослойный персептрон

- Kohonen SOM (Самоорганизующаяся карта)

- Сеть радиальных базисных функций (RBF)

Нейронная сеть для глубокого обучения

Вслед за нейронной сетью в глубоком обучении используются архитектуры.

- Нейронные сети с прямой связью

- Рекуррентная нейронная сеть

- Многослойный перцептрон (MLP)

- Сверточные нейронные сети

- Рекурсивные нейронные сети

- Сети глубоких убеждений

- Сверточные сети глубоких убеждений

- Самоорганизующиеся карты

- Станки глубокого Больцмана

- Составные автокодеры с шумоподавлением

Нейронные сети и нечеткая логика

Нечеткая логика относится к логике, разработанной для выражения степени правдивости путем присвоения значений от 0 до 1, в отличие от традиционной булевой логики, представляющей 0 и 1.Нечеткая логика и нейронные сети имеют одну общую черту. Их можно использовать для решения задач распознавания образов и других задач, не связанных с какой-либо математической моделью. Системы, сочетающие нечеткую логику и нейронные сети, являются нейронечеткими системами. Эти системы (гибридные) могут сочетать в себе преимущества как нейронных сетей, так и нечеткой логики, чтобы работать лучше. Нечеткая логика и нейронные сети были интегрированы для использования в следующих приложениях:

Нечеткая логика и нейронные сети были интегрированы для использования в следующих приложениях:- Автомобильная техника

- Отбор кандидатов на вакансии

- Управление краном

- Мониторинг глаукомы

Нейронная сеть для машинного обучения

- Многослойный персептрон (контролируемая классификация)

- Сеть обратного распространения (контролируемая классификация)

- Сеть Хопфилда (для ассоциации шаблонов)

- Глубокие нейронные сети (неконтролируемая кластеризация)

Каковы применения нейронных сетей?

Нейронные сети успешно применяются в широком спектре приложений с интенсивным использованием данных, таких как:| Заявка | Архитектура / алгоритм | Функция активации |

| Моделирование и управление процессами | Радиальная базовая сеть | Радиальное основание |

| Диагностика машины | Многослойный персептрон | Tan — сигмовидная функция |

| Управление портфелем | Классификация контролируемых алгоритмов | Tan — сигмовидная функция |

| Распознавание цели | Модульная нейронная сеть | Tan — сигмовидная функция |

| Медицинский диагноз | Многослойный персептрон | Tan — сигмовидная функция |

| Кредитный рейтинг | Логистический дискриминантный анализ с использованием ИНС, машина опорных векторов | Логистическая функция |

| Целевой маркетинг | Алгоритм обратного распространения сигнала | Логистическая функция |

| Распознавание голоса | Многослойный персептрон, глубокие нейронные сети (сверточные нейронные сети) | Логистическая функция |

| Финансовое прогнозирование | Алгоритм обратного распространения ошибки | Логистическая функция |

| Интеллектуальный поиск | Глубокая нейронная сеть | Логистическая функция |

| Обнаружение мошенничества | Градиент — алгоритм спуска и алгоритм наименьшего среднего квадрата (LMS). | Логистическая функция |

Каковы преимущества нейронных сетей?

- Нейронная сеть может выполнять задачи, которые не может выполнять линейная программа.

- Когда элемент нейронной сети выходит из строя, его параллельный характер может продолжаться без каких-либо проблем.

- Нейронная сеть обучается, и в перепрограммировании нет необходимости.

- Может быть реализован в любом приложении.